Juli Ponce Solé

Límites jurídicos de la toma de decisiones discrecionales automatizadas mediante inteligencia artificial: racionalidad, sabiduría y necesaria reserva jurídica de humanidad en el ámbito digital.

El presente estudio analiza la relación entre la inteligencia artificial (IA) y los humanos en la toma de decisiones administrativas formalizadas discrecionales. En el mismo, tras exponer brevemente los distintos tipos de IA, se argumenta como la eliminación de la discrecionalidad (fettering), en el caso de la IA basada en reglas, y determinadas características, por el momento únicamente humanas, como la empatía y la realización de razonamientos abductivos, en el caso de la IA no simbólica o estadística (aprendizaje automático y profundo) suponen un impedimento jurídico para el ejercicio totalmente automatizado de la discrecionalidad por máquinas.

Juli Ponce Solé es Catedrático de Derecho Administrativo en la Universidad de Barcelona

El artículo se publicó en el número 66 de la Revista General de Derecho Administrativo (Iustel, mayo 2024)

RESUMEN: El presente estudio analiza la relación entre la inteligencia artificial (IA) y los humanos en la toma de decisiones administrativas formalizadas discrecionales. En el mismo, tras exponer brevemente los distintos tipos de IA, se argumenta como la eliminación de la discrecionalidad (fettering), en el caso de la IA basada en reglas, y determinadas características, por el momento únicamente humanas, como la empatía y la realización de razonamientos abductivos, en el caso de la IA no simbólica o estadística (aprendizaje automático y profundo) suponen un impedimento jurídico para el ejercicio totalmente automatizado de la discrecionalidad por máquinas. Éstas no deberían realizar juicios volitivos, que deberían quedar en manos humanas, pues se violaría el derecho a una buena administración, al procedimiento administrativo debido y a una motivación comprensible, corolarios de ésta. Se sugiere la explicitación de dicha prohibición jurídica en España, como ya han realizado algunas normas de Derecho comparado y autonómico, de acuerdo con el estado actual de la técnica y el principio jurídico de precaución, sin perjuicio de que la IA puede emplearse como apoyo al decisor humano en la toma de decisiones discrecionales. Para el caso de que la IA ejerza potestades regladas, o se permita el ejercicio de la discrecionalidad por ella, lo que aquí se rechaza, se subraya la necesidad (y dificultad) de ejercer una supervisión del funcionamiento de la IA por un humano gestor público, responsable del procedimiento administrativo o/y de la decisión final. Se finaliza el análisis con las conclusiones alcanzadas y con la necesidad de reflexionar sobre el modo de desarrollar la supervisión humana y de configurarla como un auténtico derecho subjetivo de los interesados.

LEGAL LIMITATIONS FOR AUTOMATED DISCRETIONARY POWERS: RACIONALITY, WISDOM AND THE NEED FOR A HUMAN RESERVE IN THE DIGITAL SPHERE

ABSTRACT: This study analyzes the relationship between artificial intelligence (AI) and humans in formalized discretionary administrative decision making. It shows how the undue elimination of discretionary powers (fettering), in the case of rule-based AI, and certain characteristics that are for the moment only human (empathy and abductive reasoning), in the case of non-symbolic or statistical AI (automatic and deep learning) pose a legal impediment to the fully automated exercise of discretion by machines. They should not make volitional judgments, as this would violate the right to good administration, the due administrative procedure and the duty of giving reasons, a corollary of the latter. It is suggested that this legal prohibition be made explicit in Spain, as has already been done in some rules of comparative and regional law, in accordance with the current state of the art and the legal principle of precaution, without prejudice to the fact that AI can be used to support the human decision-maker in making discretionary decisions. In the case of AI exercising regulated powers, or allowing the exercise of discretion, which is rejected here, the need (and difficulty) of supervising the operation of AI by a human public manager, responsible for the administrative procedure and/or the final decision, is emphasized. The analysis ends with the conclusions reached and with the need to reflect on how to develop human supervision and to configure it as an authentic subjective right of the interested parties.

I. INTRODUCCIÓN: OBJETO DE ESTE ANÁLISIS (1)

La investigación sobre las relaciones entre los seres humanos y la inteligencia artificial (en adelante, IA) nos conduce a reflexionar sobre qué significa ser humano y qué nos caracteriza como tales, en general y, en relación específica con lo que se va a tratar aquí, el impacto de la IA en el funcionamiento de las Administraciones Públicas y el propio concepto de discrecionalidad.

Antes de nada, conviene aclarar qué se entiende por IA. No existe una definición científica canónica de lo que sea la IA. Esta dificultad de caracterizar a la inteligencia artificial nos obliga, por otro lado, a reflexionar también sobre lo que sea la inteligencia humana, tarea nada sencilla, como veremos.

El informe de 2022 del Consejo de Estado francés intenta una interesante aproximación al concepto de IA(2). Así, distingue entre la IA como producto o servicio que utiliza uno o varios programas informáticos, basados en el uso de algoritmos(3) y datos masivos(4), y como disciplina científica. En este ámbito, establece una diferencia entre la IA general o fuerte, que podría combinar la unión de funciones cognitivas y desarrollar capacidades autónomas, hoy en día inexistente, e IA estrecha o débil, que pueden efectuar, sólo, tareas específicas. De hecho, cuanto mejor realiza dichas tareas la IA, más se alejan de la general o fuerte, en una especie de contradicción en búsqueda del mito de ésta última, señalada por LARSON(5).

La Comisión Europea, por su parte, se ha referido a que la expresión IA se usa para hablar de un grupo de tecnologías que están automatizadas, es decir, que pueden decidir por sí solas. Se trata de programas informáticos que son diseñados para resolver de forma autónoma. Son sistemas que manifiestan un comportamiento inteligente, pues son capaces de analizar su entorno y pasar a la acción, con cierto grado de autonomía, con el fin de alcanzar objetivos específicos(6). Estos sistemas pueden consistir en un simple programa informático (por ejemplo, motores de búsqueda o sistemas de reconocimiento facial o de voz) pero también pueden estar incorporados en dispositivos de hardware (como robots o automóviles autónomos)(7).

En los años 60 del pasado siglo LICKELIDER, psicólogo de formación y uno de los padres de la IA, se ocupó teóricamente de la relación entre humanos y máquinas, en un famoso artículo, en el que abogaba por una colaboración en la que las máquinas desarrollaran las labores rutinarias aportando a los humanos sus capacidades singulares(8).

Sin embargo, fue un militar de la extinta Unión Soviética, el teniente Stanislov PETROV, quien experimentó en los años ochenta, en la práctica, las tensiones que pueden surgir en la relación máquina-humano. La mañana del 26 de septiembre de 1983, las computadoras del centro donde se hallaba como responsable detectaron el lanzamiento de misiles nucleares estadounidenses. Petrov tomó la decisión de que se trataba de una falsa alarma, generada por el sistema algoritmos existente, y no actuó. Esta decisión, que se dio a conocer años después, posiblemente salvó al mundo de una guerra nuclear(9)

En las breves líneas que siguen, de todos los temas posibles en esa relación entre seres humanos-IA voy a seleccionar uno en concreto: el papel de los humanos respecto a la limitación y supervisión del funcionamiento de la IA en la práctica en relación con las decisiones discrecionales formalizadas y adoptadas a través de un procedimiento administrativo de las Administraciones Públicas y su posible automatización total.

Efectivamente, con anterioridad hemos tenido ocasión de destacar como creíamos que era necesario limitar, en principio, el uso de la IA en relación con el ejercicio de potestades administrativas discrecionales, sobre la base de que ésta carece de la empatía necesaria para adoptar decisiones que puedan afectar a los ciudadanos de manera adecuada(10).

Retomaremos aquí esta cuestión con nuevas reflexiones, además, sobre el modo de pensar de máquinas y humanos, y añadiremos otra: la de la supervisión, control o vigilancia humana del funcionamiento del sistema, lo que en la literatura específica se conoce desde hace tiempo como human in the loop, o el humano en el sistema, en aquellos supuestos en que se acepte el uso de IA.

Ambas intervenciones humanas creemos que son distintas. En la primera, son los humanos, a través de los mecanismos propios del Estado Democrático y de Derecho los que deciden, en un espacio temporal y territorial determinado, prohibir el uso de la IA en ciertos ámbitos, por diversas razones, como veremos, reservándose la toma de la decisión. En cambio, en el segundo caso, aceptado dicho uso para tomar decisiones, el papel humano ahora será el de garantizar el correcto funcionamiento del sistema para evitar, en lo que aquí nos interesa, la violación de derechos o intereses legítimos de los ciudadanos afectados por la IA que use una Administración.

En ambos casos, el Derecho, el Derecho público y específicamente el Derecho Administrativo, que es el que aquí consideraremos, tiene que hacer frente a una posible situación que hasta hace relativamente poco era inédita: que quien toma la decisión final formalizada sometida al ordenamiento jurídico en vigor no sea un humano, un gestor público, un burócrata, sino un sistema algorítmico, en su caso con uso de IA (esto es sistemas algorítmicos que hacen uso de Big Data con aprendizaje automático o profundo, machine learning, deep learning), una máquina, pues. Esta decisión de la máquina puede servir de apoyo para la toma de la decisión final administrativa por parte de un ser humano (resolución, contrato o convenio, reglamento, plan: decisión semiautomatizada) o bien, prescindiendo totalmente de éste, para adoptarla directamente (decisión automatizada)(11), supuesto en que nos centraremos aquí, específicamente en las decisiones formalizadas automatizadas en ejercicio de una potestad discrecional.

Frente a esa intervención de las máquinas, el Derecho, como decimos, puede decidir, como veremos, prohibirla en ciertos casos, debido a determinadas razones, o aceptarla, con supervisión humana (como veremos, es el caso europeo) o sin ella.

Una pregunta relevante entonces puede ser la siguiente: ¿por qué le interesaría al Derecho prohibir la toma de decisiones automatizadas o imponer una supervisión humana respecto al uso de la IA?

Para comprender lo que se va a exponer a continuación, es necesario realizar algunas distinciones que serán importantes para extraer conclusiones. Se trata de tres parejas de conceptos que, como veremos, se interrelacionan entre sí:

a) Tipos de participación de la IA en la toma de la decisión administrativa formalizada: obviando ahora matices, la participación puede consistir en ser soporte y ayuda para la toma de una decisión administrativa humana, que será semiautomatizada, frente a una participación de la IA que supone la adopción de la decisión final que termina el procedimiento, esto es una decisión automatizada.

b) Tipos de potestades administrativas que se ejercen: que pueden ser regladas o discrecionales.

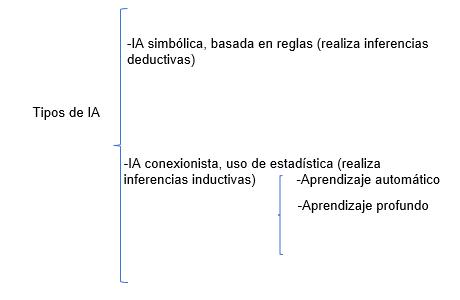

c) Tipos de IA: frente a la simbólica, que desarrolla inferencias deductivas (good old fashioned IA o GOFAI), se sitúa la no simbólica, conexionista o basada en estadística (aprendizaje automático, aprendizaje profundo), que realiza inferencias inductivas.

Veamos cómo se combinan estas tres perspectivas y que conclusiones podemos extraer.

II. HUMANOS E INTELIGENCIA ARTIFICAL: EMPATÍA E INFERENCIAS ABDUCTIVAS

Las ventajas de la IA parecen indudables: una capacidad de procesamiento mucho mayor que los humanos (cuya memoria es mucho más limitada y se ve afectada por la fatiga), la capacidad de realizar predicciones mediante correlaciones, mayor eficacia, eficiencia y, por tanto, buena administración(12), la posibilidad de evitar los sesgos cognitivos de los humanos y de acabar con el ruido, esto es la existencia de decisiones distintas no queridas en condiciones similares(13), y la capacidad de generar nuevas ocupaciones laborales relacionadas.

Ahora bien, en todo caso no hay que olvidar los problemas que también puede generar la IA: desde la substitución de humanos en tareas privada y públicas con el consiguiente desempleo, también en el sector público(14), pasando por el hecho de que las correlaciones generadas por la IA pueden dar lugar a errores y que dichas correlaciones tienen una tendencia conservadora, al primar el status quo, puesto que se extraen predicciones de lo que ocurrió en el pasado, pero el pasado, y las personas, pueden cambiar. Los mencionados errores pueden existir también en la programación (bugs), que pueden tener un impacto a gran escala, afectando a muchas más personas que una decisión adoptada por un humano.

Por otro lado, no es cierto que la IA esté libre de sesgos (pues sesgos existen en los datos manejados para entrenar a la IA y para que esta decida o estadísticos). Ni siquiera de los sesgos cognitivos humanos, de los que es infectada por los programadores humanos, que sufren de sesgos como el de disponibilidad, respecto al uso de ciertos datos empleados para entrenar a la máquina, o de confirmación, por ejemplo, al seleccionar dichos datos(15).

Además, la IA produce un sesgo cognitivo humano específico y bien estudiado: el sesgo de automatización, por el que, en general, los humanos tendemos a confiar en lo que nos dicen los sistemas empleados y rara vez lo cuestionamos, lo que puede dar lugar a supuestos extremos como las llamadas muertes por GPS: personas pérdidas en el desierto que mueren por seguir a rajatabla las equivocadas indicaciones del navegador(16).

Además, como es sabido, los sistemas de aprendizaje automático y profundo presentan el problema de las llamadas cajas negras. La complejidad de estos sistemas de toma de decisiones hace difícil explicar los pasos seguidos hasta la toma de la decisión final, lo que plantea cuestiones jurídicamente relevantes, relativas al control judicial del seguimiento del debido proceso, en términos de interdicción de la arbitrariedad (recogida en el art. 9.3 de la Constitución española, por ejemplo), es decir la prohibición de decisiones irracionales o no motivadas, y también de buena administración, de la que luego nos ocuparemos, esto es la exigencia de decisiones fruto del respeto de la obligación jurídica de debido cuidado o debida diligencia en la toma de la decisión final, que debe haber considerado todos los factores relevantes y descartado los irrelevantes. Está aún por ver si estas mismas técnicas podrán dar iguales frutos en relación con el proceso de toma de decisiones de la IA y sus cajas negras.

Ahora bien, siendo cierto todo ello, la limitación humana del uso de la IA se basa en algo mucho más profundo aún. La doctrina jurídica y normativa que se ocupan del tema mencionan los conceptos de dignidad humana y posible violación de derechos, como en este segundo caso hace el art. 14 de la propuesta de Reglamento de la Unión Europea de IA (en adelante, RUEIA(17)), en proceso avanzado de aprobación al escribir estas líneas, para justificar la “desconfianza” humana en la IA, debido, como dice este precepto, a “los riesgos para la salud, la seguridad o los derechos fundamentales que pueden surgir cuando un sistema de IA de alto riesgo se utiliza conforme a su finalidad prevista o cuando se le da un uso indebido razonablemente previsible, en particular cuando dichos riesgos persisten a pesar de aplicar otros requisitos”.

Pero entonces, cabe formular una pregunta similar a la anterior, aunque cambiando la perspectiva: ¿por qué un sistema algorítmico en su caso con IA puede afectar a la dignidad de la persona o violar sus derechos de un modo específico en que no lo puede hacer un humano?

Para abordar esta cuestión, debemos partir de dos conceptos cruciales, uno técnico y el otro jurídico: la IA y la buena administración.

La Comisión Europea se ha referido a que la expresión IA se usa para hablar de un grupo de tecnologías que están automatizadas, es decir, que pueden decidir por sí solas. Se trata de programas informáticos que son diseñados para resolver de forma autónoma. Son sistemas que manifiestan un comportamiento inteligente, pues son capaces de analizar su entorno y pasar a la acción, con cierto grado de autonomía, con el fin de alcanzar objetivos específicos(18). Estos sistemas pueden consistir en un simple programa informático (por ejemplo, motores de búsqueda o sistemas de reconocimiento facial o de voz) pero también pueden estar incorporados en dispositivos de hardware (como robots o automóviles autónomos).

La IA incluiría tanto la IA basada en reglas (o simbólica, o determinista o GOFAI, good old-fashioned AI) en desarrollo desde los años 50 del pasado siglo hasta los 90 (por ejemplo, un programa básico del juego de ajedrez), basado en razonamientos lógicos del tipo de inferencia deductiva, basada en premisas que llevan a una conclusión (si a y b, entonces c), como la IA que con uso de la estadística para inferencias inductivas conduce a la AI de aprendizaje automático o profundo (machine o deep learning), un tipo de IA entrenada para absorber una gran cantidad de datos, encontrar patrones entre ellos y arrojar ciertas conclusiones basadas en el análisis de aquellos, sin que en la actualidad se pueda establecer el razonamiento que conduce a la decisión final.

Se puede utilizar el ejemplo de las reglas de fútbol para explicar la diferencia entre estos dos tipos de IA: se pueden aprender dichas reglas leyendo el reglamento de la FIFA o se pueden aprender mediante el visionado de miles de partidos, de los que se extraen dichas reglas (juegan 11 contra 11, no se puede tocar el balón con las manos, etc.).

Este segundo tipo de IA es capaz de proporcionar más conclusiones diferentes al captar más datos, mediante un entrenamiento y un autoaprendizaje, sea este supervisado (esto es con datos etiquetados por humanos, lo que puede ayudar a minimizar los errores) o no supervisado (o auto supervisado o por refuerzo). Este segundo tipo de IA (también llamado conexionista o subsimbólico) también incluiría el llamado aprendizaje profundo (deep learning), un tipo de IA con aprendizaje autónomo con modelos matemáticos de gran complejidad(19).

Estos dos tipos de IA no tienen por qué considerarse separadamente: así, por ejemplo, un chatbot usa ambos tipos de IA.

Lo dicho puede esquematizarse así:

Por otra parte, el derecho a una buena administración puede hallarse en el art. 41 de la Carta de Derechos Fundamentales de la Unión Europea y también en ordenamientos nacionales como el español(20).

Referencias a la buena administración se encuentra en la jurisprudencia del Tribunal Europeo de Derechos Humanos (que lo extrae del Convenio Europeo de Derechos Humanos de 1950, pese a no estar reconocido en éste explícitamente), del Tribunal de Justicia de la Unión Europea, en literalmente miles de sentencias desde 1955, en las que ha reconocido a la buena administración como una de las tradiciones constitucionales comunes a los Estados miembros de la Unión Europea) y también en los tribunales nacionales(21).

Por ejemplo, en España, en la del Tribunal Supremo, que ha establecido la existencia de un derecho a una buena administración implícito en la Constitución española, en numerosas sentencias, por ejemplo, STS de 4 de noviembre de 2021, y de los Tribunales Superiores de Justicia de las Comunidades autónomas.

Un elemento relevante y propio de la buena administración, que actúa como principio y derecho, que la distingue y la aleja de ser un concepto paraguas sin substantividad propia, el cual destaca al analizar toda la normativa y la jurisprudencia aludidas, es el de que los cargos electos, los altos cargos y los empleados públicos en cumplimiento de sus obligaciones de buen gobierno y buena administración deberán actuar:

– con la diligencia de un cuidadoso servidor público,

– actuando solo en ausencia de conflictos de intereses,

– con la información necesaria,

– teniendo en cuenta los factores relevantes y

– otorgando a cada uno de los mismos su debida importancia en la decisión, excluyendo de su consideración todo elemento irrelevante,

– motivando suficiente y congruentemente la misma en relación con la fundamentación existente en el expediente(22).

En consecuencia, el ejercicio de la discrecionalidad administrativa no puede suponer ya una libertad de elección indiferente para el Derecho, como tradicionalmente en España se ha definido. Por el contrario, supone el cumplimiento de una serie de obligaciones de conducta, de medios, en garantía de la diligencia debida y el debido cuidado en la toma de la mejor decisión posible. Entendemos por discrecionalidad administrativa aquellos supuestos en que la norma que otorga la potestad a la administración deja a ésta un margen de apreciación que implica un elemento volitivo, lo que sucede también en el caso de los conceptos jurídicos indeterminados con margen de apreciación(23).

2.1. La IA simbólica o de reglas preprogramadas: el problema jurídico de la rigidificación (fettering) de la discrecionalidad

El correcto ejercicio de la discrecionalidad de acuerdo con la buena administración exige, pues, aplicarla a cada caso en función de las circunstancias específicas del mismo, no siendo posible su cristalización de antemano en decisiones ya pre adoptadas, lo que en el ámbito angloamericano se denomina fettering, debiendo el decisor administrativo cumplir la obligación de tener en cuenta las circunstancias del caso, obligación jurídica que diversos ordenamientos jurídicos destacan(24).

CRAIG señala al respecto que como el principio general en Derecho británico es que un organismo público dotado de poderes discrecionales concedidos por ley no puede adoptar una política o norma que le permita resolver un caso sin ninguna consideración de los méritos del solicitante individual. La línea de autoridad dominante permite al organismo aplicar su norma, siempre que se conceda al individuo la oportunidad de impugnar su aplicación al caso concreto. La política debe ser legítima dado el marco legal en el que se ejerce la discrecionalidad. Debe basarse en consideraciones pertinentes y no perseguir fines indebidos. Estos controles son necesarios ya que, de lo contrario, una autoridad pública podría eludir las limitaciones normales al ejercicio de la discrecionalidad mediante la elaboración de políticas generales. Sin embargo, señala CRAIG también existe un principio de coherencia, que crea la presunción de que un organismo público seguirá su propia política. Si pretende apartarse de esa política, debe haber buenas razones para ello y éstas deben comunicarse al solicitante(25).

Estos preceptos doctrinales expuestos pueden resultar problemáticos cuando las decisiones se toman mediante sistemas de inteligencia artificial en la opinión de CRAIG. Esto se debe a que dichos sistemas suelen estar orientados a la uniformidad de los resultados, en lugar de tener en cuenta consideraciones específicas de cada caso concreto. Esto es especialmente cierto cuando un organismo público se basa exclusiva o irreflexivamente en un algoritmo a la hora de ejercer su poder discrecional(26).

2.2. La IA basada en estadística: el problema jurídico de la falta de empatía humana y de ausencia de capacidad de realizar inferencias inductivas

2.2.1. Empatía humana

Las máquinas carecen de empatía (aunque puedan imitarla), por lo tanto, no pueden adoptar buenas decisiones en aquellos casos en que exista un margen de valoración administrativo, manteniendo el debido respeto al derecho a una buena administración de los ciudadanos.

Efectivamente, las máquinas carecen de empatía, un factor relevante en las relaciones entre seres humanos, que se vincula con su dignidad y su personalidad (art. 10.2 CE). Podemos definir la empatía ahora muy sencillamente como un componente cognitivo humano que permite comprender a los demás, incluyendo sus dificultades, vulnerabilidades y problemas, y adaptar nuestro comportamiento de forma correspondiente. Se trata del sentimiento de identificación con algo o alguien y la capacidad de identificarse con alguien y compartir sus sentimientos. De hecho, formar parte de la humanidad implica una sensibilidad, una compasión por las desgracias de otras personas, pues es humano aquél que es comprensivo, sensible a los infortunios ajenos(27).

Obviamente, no todos los humanos tienen el mismo nivel de empatía, pero casi todos tienen la capacidad no sólo de tenerla sino de entrenarla. Decimos casi todos porque, precisamente, un rasgo que caracteriza a los psicópatas, que serían un 1% de la población, sería la falta de esta (lo que no significa que no la puedan imitar, para manipular a otros seres humanos en su favor). Estamos frente a una enfermedad grave y peligrosa, pese a intentos de configurarla como una ventaja evolutiva (!)(28), en vez de como lo que es: un trastorno grave de la personalidad, denominado por el DSM-5 trastorno de la personalidad antisocial (el DSM-5 es el Diagnostic amd statistical Manual of Mental Disorders, ediatado por la American Psyhiatric Association).

Por otro lado, no cabe confundir la empatía con la simpatía o con la compasión: la primera incluye sentimientos similares a los que siente el otro, pero no sentimientos por lo que siente esa otra persona. La empatía es un primer paso que puede o no conducir a la simpatía y la compasión o bien a un contagio emocional que puede ser de angustia orientado no al otro, sino a uno mismo. En consecuencia, no cabe confundir empatía con una simple emoción que va a conducir en el ámbito jurídico a la adopción de decisiones parciales y no objetivas: bien al contrario, va a ser esa empatía, esa capacidad de considerar perspectivas distintas la que nos llevará a la imparcialidad y a la objetividad ponderando todos los factores.

Pues bien, los sistemas algorítmicos y la IA no tienen empatía. Los medios de comunicación acostumbran a utilizar un lenguaje metafórico, humanizando a las máquinas, y así, por ejemplo, han dado noticia de Norman, un sistema, que, entrenado con datos específicamente negativos, al cual se le ha denominado el primer sistema de IA psicópata(29).

No somos partidarios de usar ese lenguaje metafórico con las máquinas, pero si seguimos ahora el juego, en realidad los medios de comunicación creemos que erraron completamente: Norman no era el primer sistema de IA psicópata, por la sencilla razón de que todos ellos han sido, son y en principio, luego diremos algo más al respecto, serán psicópatas. Todos carecen de empatía, no pueden comprender ni ponerse en el lugar de un ser humano, porque las máquinas no enferman, envejecen o mueren; no sufren y por tanto no pueden empatizar con un ser humano, si bien pueden imitar la empatía (como los humanos psicópatas), lo cual si cabe es todavía más escalofriante y puede conducir a manipulaciones de los humanos

En ese sentido, es destacable el análisis de WEIZENBAUM, científico y programador del MIT (Massachussets Institute of Technology), de origen alemán, que, como es sabido, diseñó en 1966 el primer chatbot de la historia, a quien bautizó como Eliza, en honor del personaje de la obra Pigmalión de George Bernard Shaw. Eliza fue diseñada y programada para actuar como un terapeuta rogeriano, entrando en comunicación con las personas mediante preguntas y respuestas, que se realizaban mediante un teclado. Weizenbaum descubrió que las personas, incluidas su secretaria, pasaban a confiar en el programa, al que humanizaban y en el que confiaban, dando lugar al llamado efecto Eliza, del que, por cierto, en 2022 hemos tenido un nuevo ejemplo con la IA LaMDA desarrollada por Google, un sistema mucho más sofisticado(30).

En 1976 Weizenbaum publicó un relevante libro, traducido al español, en el que alertaba sobre el peligro de atribuir tareas que exigían auténtica empatía humana a sistemas algorítmicos, aludiendo entre ellas a algunas tales como la de juez u oficial de policía(31).

Pasando de estas reflexiones generales al ámbito del Derecho administrativo y de la gestión pública, hay que destacar que, en diversos países, la literatura ha insistido en la importancia de la empatía, un valor del servicio público y un elemento a considerar en la elaboración y aplicación del Derecho(32), que cristaliza, por ejemplo, en el principio de la equidad jurídica (así, por ejemplo, art. 3 del Código Civil español). De hecho, la empatía está ínsita en el principio y derecho de buena administración ya mencionado, por cuanto, como es sabido, la buena administración exige la debida diligencia y debido cuidado en la toma en consideración de todos los factores relevantes antes de adoptar una decisión administrativa y, sin duda, la situación concreta de la persona que se relaciona jurídicamente con la Administración (por ejemplo, su vulnerabilidad por pobreza, discapacidad, dificultades vitales, errores humanos) es un factor relevante a tomar en cuenta.

Así lo destacan tanto el Consejo de Europa como el ombudsman federal belga, por ejemplo. En el primer caso, el Consejo de Europa enfatiza su relevancia, porque la empatía nos lleva a comprender los intereses, las necesidades y los puntos de vista de los demás, la empatía es un importante determinante del comportamiento moral y un elemento necesario para construir comunidades morales(33). En el segundo caso, el ombudsman belga afirma con rotundidad que la empatía es la clave en la base de una prestación de buenos servicios públicos y una condición necesaria para un servicio público humano que se adapta a la situación individual de cada ciudadano. Favorece los cambios de perspectiva, determina la forma en que la forma en que miramos a una persona o a un grupo, y tiene un gran impacto en la forma en que percibimos y respondemos a los demás y a los acontecimientos de la vida(34).

En consecuencia, esa falta de empatía de las máquinas es la que las hace inadecuadas para adoptar decisiones automatizadas con margen de valoración que afectan a seres humanos. Para adoptar buenas decisiones hace falta racionalidad, pero no sólo, como ha destacado el neurocientífico portugués que investiga en los EE. UU. Antonio DAMASIO, por ejemplo, en su libro El error de Descartes(35). En el ámbito jurídico, como en otros ámbitos profesionales, persiste la creencia, heredada de la Ilustración, de que una buena decisión no debe incorporar ni emociones ni sentimientos, sino que ha de usar, simplemente, la fría racionalidad. Sin embargo, los estudios neurocientíficos de las últimas décadas nos demuestran que ese es un concepto burdo y anticuado: somos seres sintientes y emocionales que, por ello y gracias a ello, toman decisiones racionales. Parece como si la naturaleza hubiese construido el aparato de la racionalidad desde y con el cuerpo (sobre el papel de las emociones en el correcto desempeño de la actividad administrativa por sus agentes y la necesidad de combinar la objetividad con la subjetividad, véanse las consideraciones de VAQUER(36)).

En este sentido, es muy destacable e importante el trabajo de dos profesores brasileños de Derecho, REIS DE ALBURQUERQUE y DE BRITO MACHADO SEGUNDO, quienes han puesto de relieve como en la toma de decisiones razón y emociones, cuerpo y mente se entrelazan en los humanos, algo que la IA está lejos de conseguir, si lo consigue algún día(37).

En definitiva, la adopción de buenas decisiones en el ámbito administrativo exige respetar el derecho a una buena administración. Éste implica la obligación jurídica de tomar en cuenta los factores relevantes antes de decidir. Entre ellos se encuentra el poder conocer la situación de las personas que se relacionan con la Administración, entenderla y obrar en consecuencia, aplicando la equidad si fuera preciso, en garantía del procedimiento administrativo debido, de la dignidad de la persona y del libre desarrollo de su personalidad.

Nada de todo eso pueden hacer hoy en día los sistemas algorítmicos y la IA(38).

2.2.2. Inferencias abductivas

Además de racionalidad y emociones, adoptar buenas decisiones significa pensar como lo hacen los humanos, esto es, realizando no meras inferencias deductivas o inductivas, sino abductivas, realizando conjeturas vinculadas a una comprensión global del mundo y a las experiencias vividas, con sentido común, mediante este tipo de inferencias que “impregnan nuestra cultura” y “son en un sentido amplio lo que nos convierte en humanos. Es posible que el sueño de una IA capture algún día esos saltos de manera automática, pero mientras tanto deberíamos admitir que la verdad es que no sabemos cómo mecanizar nuestra experiencia”(39).

Las máquinas no piensan como los humanos, que utilizan inferencias denominadas abductivas, señaladas por PIERCE en el siglo XIX, capaces de formular conjeturas e integrar el sentido común en un mundo cambiante(40).

Esta imposibilidad de las máquinas de realizar abducciones puede tener conexión con su falta de empatía, ya señalada antes, puesto que como se ha dicho (la traducción es nuestra): “La abducción requiere la capacidad de considerar un punto de vista singular implicado en el razonamiento. En otras palabras, el modelo abductivo presupone una forma de empatía. (...) La empatía es, por tanto, uno de los motores cognitivos cruciales del sistema abductivo. Sin empatía, el razonamiento abductivo es imposible”(41).

2.3. Derecho a una buena administración: audiencia e información pública y motivación

Por otro lado, una regla clásica del Estado de Derecho, que forma parte del derecho a una buena administración (por ejemplo, art. 41 de la Carta de Derechos Fundamentales de la Unión Europea) es la imposibilidad de adoptar decisiones que afecten a una persona sin escuchar a ésta antes (en Derecho español, art. 82 LPAC)(42). Asimismo, cuando sea preciso realizar una información pública “quienes presenten alegaciones u observaciones en este trámite tienen derecho a obtener de la Administración una respuesta razonada” (art. 83). Todo ello impide automatizar totalmente la toma de decisiones, puesto que exige una previa intervención humana en el procedimiento administrativo de adopción de la decisión que considere diligentemente, de acuerdo con la buena administración, las alegaciones de los interesados o participantes.

Además, exigencias de racionalidad, buena administración y transparencia explican la necesidad de motivar las decisiones administrativas, incluidas las adoptadas con IA (art. 9.3 CE prohibiendo la arbitrariedad, art. 35 LPAC). Sin embargo, las decisiones discrecionales que pudieran adoptarse con IA estadística (aprendizaje automático o profundo) no podrían ser justificadas conforme a hechos, fundamentos de derecho y criterio de oportunidad manejado, al encontrarnos actualmente ante cajas negras, como es sabido, en las que es posible conocer los datos que actúan como inputs y la solución adoptada final o output, pero no el razonamiento que conduce de aquellos a esta(43). Si tal fuera la situación, debería concluirse que si se pretendiera adoptar decisiones administrativas discrecionales mediante sistemas que no pueden justificarlas respecto a los criterios no jurídicos empleados en la elección (más allá, pues, de la mera explanabilidad del funcionamiento del propio sistema) tal pretensión resultaría en decisiones arbitrarias contrarias al ordenamiento jurídico vigente.

2.4. Consecuencias de la falta de empatía, de la incapacidad de abducción de la IA, de la regla audi alteram parte, de la necesaria consideración de la participación ciudadana y de la motivación en el ámbito administrativo ¿y judicial?

En resumen, en nuestra opinión, que no es unánime entre la doctrina europea(44), por las razones vistas, el uso de sistemas algorítmicos e IA para adoptar decisiones administrativas discrecionales de forma totalmente automatizadas, de acuerdo con el estado actual de la técnica, y el que se prevé a, como mínimo, a medio plazo, puede presentar problemas en relación con el adecuado uso de la discrecionalidad administrativa en un Estado de Derecho y violar el derecho a una buena administración, por lo que, con fundamento en el principio de precaución aplicado al uso de la AI en el ejercicio de potestades administrativas, debe entenderse jurídicamente no posible en el estado de la técnica en la actualidad(45).

La discrecionalidad supone la obligación jurídica de hacer efectivo el derecho a una buena administración, lo que exige una ponderación con el debido cuidado y la debida diligencia de todos los elementos relevantes en la toma de la decisión, descartando siempre los irrelevantes, para poder obtener la mejor decisión posible para los intereses generales.

Ello supone que no pueda ejercerse la discrecionalidad mediante el uso de IA simbólica, basada en reglas preprogramadas, que den lugar a decisiones automatizadas administrativas. Se violaría en caso de hacerlo el derecho a una buena administración, produciéndose un supuesto de rigidificación ilegal de la discrecionalidad, como se reconoce en diversos ordenamientos jurídicos de nuestro entorno europeo y se conoce en el ámbito angloamericano como fettering.

Descartada la posibilidad jurídica de preprogramar la discrecionalidad administrativa encorsetándola, esto es de desarrollar decisiones discrecionales automatizadas con IA simbólica, debe abordarse la posibilidad de hacerlo con IA conexionista, mediante aprendizaje automático o profundo. La falta de empatía de las máquinas, a diferencia de los humanos no psicópatas, la inmensa mayoría, los riesgos relacionados la falta de razonamiento abductivo propio de los seres humanos que les otorga su sentido común y visión global basada en experiencias, imprescindible para adoptar buenas decisiones administrativas en el servicio a los intereses generales. debería imposibilitar también decisiones administrativas discrecionales automatizadas usando sistemas basados en IA conexionista o no simbólica.

Por otro lado, una automatización total de la toma de la decisión, tanto discrecional como reglada, no sería posible cuando sea preciso escuchar a los interesados y participantes, puesto que el procedimiento administrativo deberá incluir una intervención humana que considere e integre en la resolución final, aceptando o denegando las alegaciones, pero tomándolas en consideración

Además, si no es posible motivar estas decisiones discrecionales (más allá de la mera explanabilidad del sistema), esto es, aportar razones justificativas sobre los hechos, fundamentos de derecho y criterios empleados para adoptar la decisión, entonces el uso de la AI estadística podría dar lugar a decisiones ilegales por arbitrarias.

McCANN, quien se muestra en contra del uso de IA para adoptar decisiones discrecionales, añade una interesante consideración complementaria en contra del mismo: el ejercicio por máquinas de la discrecionalidad conllevaría el desplazamiento del compromiso moral humano que el ejercicio de la misma debe conllevar, de tal manera que los servidores públicos tendrían la (muy humana) tentación de escudarse tras las decisiones maquinales, no afrontando su responsabilidad última por ellas(46).

Por otro lado, una automatización total de la toma de la decisión, tanto discrecional como reglada, no sería posible cuando sea preciso escuchar a la parte afectada, puesto que el procedimiento administrativo deberá incluir una intervención humana que considere e integre en la resolución final, aceptando o denegando las alegaciones, pero tomándolas en consideración, lo aportado por al ciudadano.

Por consiguiente, la IA para el ejercicio totalmente automatizado de potestades administrativas discrecionales (esto es, todos aquellos casos en que exista un margen de valoración) debería quedar, en principio, descartada, en aplicación del principio de buena administración, salvo decisión legal expresa distinta, y por tanto restringida al ejercicio de potestades regladas y aún en estas no será posible una automatización total si hay obligación de apertura de trámite de audiencia.

Eso sí, en todos los casos puede emplearse la IA como apoyo a la final decisión administrativa humana.

Si bien este no es el objetivo del presente trabajo, cabría reflexionar sobre si los argumentos expuestos aquí en relación con el poder ejecutivo, con los necesarios ajustes y adaptaciones, pueden ser también relevantes en relación con el poder judicial. El uso de IA en la adopción de decisiones judiciales enlaza también con las relaciones juez/a/ humano-máquina, en conexión con el principio de buena administración judicial(47).

En todo caso, simplemente quiero apuntar aquí que existen debates abiertos al respecto, algunos de los cuales guardan semejanza con los planteados y vistos en el caso del poder ejecutivo, como la posible existencia de una reserva de humanidad también en el ámbito judicial. Antes de entrar en el objeto propio de nuestra reflexión, permítasenos un apunte sobre la IA y la actividad judicial.

Así, por ejemplo, en la conocida sentencia norteamericana State v. Loomis, 881 N.W.2d 749 (2016), del Tribunal Supremo del estado de Wisconsin, se conoció del Eric L. Loomis, quien fue arrestado en Wisconsin por resistirse a una autoridad pública después de ser encontrado conduciendo un automóvil robado. Para determinar la sentencia, el tribunal utilizó COMPAS (Correctional Ofenders Management Profiling for Alternative Sanctions), un sistema algorítmico capaz de estimar el riesgo de reincidencia del delincuente sobre la base de una entrevista (137 preguntas con respuestas restringidas) así como la inclusión en el programa de datos relacionados con los antecedentes penales y las condiciones socioeconómicas y personales del imputado. La sentencia se planteó si hubo un erróneo uso de la discrecionalidad judicial. La conclusión del Tribunal Supremo de Wisconsin fue que no, pues en este caso la discrecionalidad judicial fue ejercida tomando en consideración todos los elementos relevantes del caso, entre ellos COMPAS, como uno más, pero sin substituir la ponderación judicial. Un voto particular recogió alguna de las cuestiones cruciales del caso (traducción nuestra):

“Al dictar sentencia, el tribunal de circuito debe considerar tres factores principales: la gravedad del delito, el carácter del delincuente y la necesidad de proteger al público () El ejercicio adecuado de la discreción de un tribunal de circuito para dictar sentencia incluye una sentencia individualizada basada en los hechos del caso y puede incluir la explicación de cómo la sentencia impuesta fomenta los objetivos del tribunal de circuito. Id. () Un tribunal sentenciador debe articular los factores que consideró al dictar la sentencia y cómo afectaron a la sentencia que impuso. () Es a través de esta articulación que determinamos si el tribunal de circuito ejerció adecuadamente su discreción en la sentencia. Los acusados tienen un derecho al debido proceso (due process) de no ser sentenciados en base a factores impropios como la raza o el género”.

Por su parte, el Anexo III del RIA señala que entre los usos de IA de alto riesgo se encuentra:

“8. Administración de justicia y procesos democráticos:

a) sistemas de IA destinados a ayudar a una autoridad judicial en la investigación e interpretación de hechos y de la ley, así como en la aplicación de la ley a un conjunto concreto de hechos”.

Hemos destacado el verbo ayudar. La cuestión para dilucidar aquí sería si el uso de este verbo excluye la toma de decisiones judiciales con margen de apreciación de forma totalmente automatizada. En esta línea, en las enmiendas presentadas por el Parlamento Europeo al proyecto de Reglamento de IA, se ha modificado el considerando 40 mediante la enmienda 71, que señala lo siguiente: “La utilización de herramientas de inteligencia artificial puede apoyar la toma de decisiones, pero no debe substituir el poder de toma de decisiones de los jueces o la independencia judicial, puesto que la toma de decisiones finales debe seguir siendo una actividad y una decisión de origen humano”.

No cabe duda, en todo caso, que el uso adecuado de SA en el ámbito judicial puede contribuir a hacer realidad el mencionado principio de una buena administración de justicia, citado por el TS, el TJUE y el TEDH(48). Buena administración de Justicia que, a su vez, exigie una ponderación cuidadosa de todos los elementos relevantes por parte del juez (humano) en ejercicio de los posibles márgenes de apreciación.

Si aceptamos las premisas anteriores, entonces a las prohibiciones del art. 5 del RIA cabría añadir, de modo implícito, este supuesto de ejercicio de discrecionalidad que debería quedar reservado para humanos.

Lo expuesto conduce, entonces, al uso de dos técnicas reguladoras (la reserva de humanidad y la supervisión humana), que debemos entender basadas también en el ya mencionado principio de precaución aplicado al uso de la AI en el ejercicio de potestades administrativas, para limitarla y vigilarla en aquellos ámbitos que una sociedad considere especialmente sensibles, dadas las limitaciones intrínsecas de la tecnología ya expuestas.

A continuación, dejamos sólo apuntadas algunas cuestiones esenciales.

III. RESERVA JURÍDICA DE HUMANIDAD EN EL ÁMBITO DIGITAL

En cuanto al concepto de reserva de humanidad, basada en la posición central de los humanos en el ámbito digital(49), se trataría concretamente de la decisión jurídica humana respecto de ciertos ámbitos en los que los seres humanos, a través de los órganos legitimados para ello, excluyen la aplicación de la IA porque se considera inadecuado el uso de ésta.

La idea de reserva de humanidad es comparable, en otro nivel, a la idea de reserva del ejercicio de potestades para los funcionarios de carrera(50). En este contexto, se considera por el legislador que las potestades administrativas sólo deben ser ejercidas por empleados públicos que, debido a su relación estatutaria con la Administración, la cual protege su imparcialidad y objetividad y les ofrece resistencia a presiones políticas o de grupos de presión privados, están en la situación adecuada para el buen servicio a los intereses generales.

Pues bien, en el ámbito de la IA, un razonamiento similar creemos que se encuentra implícitamente tras las normas jurídicas ya vigentes o en proceso de elaboración que requieren que sólo sean humanos los que tomen ciertas decisiones (impidiendo pues, decisiones completamente automatizadas) debido a diversas razones, entre las que se encuentra esa capacidad empática de la que carecen las máquinas.

Así, el art. 22 del Reglamento General de Protección de Datos de la Unión Europea (en adelante, RGPD(51)) configura, de hecho, una reserva de humanidad como principio, que puede ser excepcionado en diversos casos, como es sabido, entre los que se encuentra que una norma específicamente prevea el uso de la IA, norma que en el ámbito español entendemos que debería ser una norma con rango de ley aprobada por los representantes democráticamente elegidos, no un simple reglamento, por aplicación del art. 18.4 de la Constitución española (“La ley limitará el uso de la informática para garantizar el honor y la intimidad personal y familiar de los ciudadanos y el pleno ejercicio de sus derechos.”). No consideramos que la reserva de ley deba ser entendida como una habilitación específica para cada uso de la IA en el sector público(52), sino como una reserva de ley relativa (similar a la que establece la Constitución española, por ejemplo, para el ejercicio de la potestad organizativa, que no supone necesidad de una ley en la creación de cada órgano concreto(53)).

Reserva de ley que impone una regulación marco con rango de ley con la suficiente densidad, evitando remisiones en blanco a reglamentos, que establezca la forma, el procedimiento, la competencia y los límites en relación con el uso de la IA. Ello tanto en lo que se refiere tanto:

a) al procedimiento de evaluación, aprobación, supervisión y revisión de los algoritmos, que serán empleados en muchos procedimientos específicos sectoriales con posterioridad, de forma diacrónica, formando, de hecho, el primer procedimiento administrativo y los posteriores sectoriales un procedimiento complejo asíncrono(54).

b) como a la evaluación en cada uno de estos procedimientos específicos de la oportunidad y necesidad del uso de IA y de su supervisión humana, a la que enseguida nos referiremos(55).

En este caso, podríamos, decir, parafraseando la conocida expresión acuñada en la Revolución norteamericana: No Automation Without Representation.

Asimismo, con un enfoque más reducido, afectando sólo a potestades discrecionales, desde otra lógica pues, diversas leyes prohíben el uso de IA, salvo que se trate del ejercicio de potestades regladas. Así, la legislación alemana (de nuestra traducción: “Un acto administrativo puede dictarse de forma totalmente automática, siempre que así lo permita la ley y que no exista ni discrecionalidad ni margen de apreciación”, (Verwaltungsverfahrensgesetz, VwVfG, § 35a Vollständig automatisierter Erlass eines Verwaltungsaktes) o catalana (ley 26/2010, art. 44.2: “Sólo son susceptibles de actuación administrativa automatizada los actos que puedan adoptarse con una programación basada en criterios y parámetros objetivos”). En la misma línea en España, si bien con mayor flexibilidad, y sin referencia específica a autorización por norma con rango de ley, aludido en el art. 18 de la Constitución española ya mencionado) se sitúa el art. XVIII.6.d de la Carta española de derechos digitales, norma de soft law aprobada en 2021 por el gobierno español (“Que la adopción de decisiones discrecionales quede reservada a personas, salvo que normativamente se prevea la adopción de decisiones automatizadas con garantías adecuadas”)(56).

La lógica detrás de estas regulaciones, creemos, debe hallarse en la ya mencionada ausencia de empatía y de capacidad de realizar inferencias abductivas de las máquinas: el ejercicio de discrecionalidad exige empatía, ponderación de todos los elementos relevantes en la toma de la decisión (obligación de debida diligencia o debido cuidado propio del derecho a una buena administración) y aplicación, en su caso de la equidad. Sólo los humanos pueden decidir de este modo. Cuestión diferente es la aplicación automatizada de potestades regladas sin ningún tipo de margen de apreciación o el uso de la IA como soporte, como apoyo al decisor humano.

En este sentido, la normativa estatal, por ejemplo, en el actual art. 41 de la ley 40/2015, siguiendo la estela de las normas ya expuestas, debería establecer el mencionado límite.

De igual modo, el proyecto de RUEIA, en su art. 5, toma la decisión de excluir diversos supuestos del uso de la IA, entre ellos, salvo autorización específica, la identificación biométrica, pero no utiliza la distinción reglado-discrecional para prohibir el ejercicio totalmente automatizado de potestades administrativas discrecionales ni siquiera en los supuestos de alto riesgo de uso de la IA por administraciones, que el propio reglamento especifica en su Anexo III. Sería posible plantear la necesidad de dicha matización a tenor de todo de lo expuesto(57).

De igual modo, el proyecto de RUEIA, en su art. 5, toma la decisión de excluir diversos supuestos del uso de la IA, entre ellos, salvo autorización específica, la identificación biométrica, pero no utiliza la distinción reglado-discrecional para prohibir el ejercicio totalmente automatizado de potestades administrativas discrecionales ni siquiera en los supuestos de alto riesgo de uso de la IA por administraciones, que el propio reglamento especifica en su Anexo III. Es posible plantear la necesidad de dicha matización a tenor de lo expuesto.

IV. SUPERVISIÓN HUMANA DE LA IA: EL HUMANO EN EL SISTEMA (THE HUMAN IN THE LOOP)

Una segunda técnica reguladora para controlar la IA, menos drástica, es permitir su uso, sea en potestades regladas, sea en discrecionales, lo que aquí se ha rechazado, si bien sometido a supervisión o vigilancia humana.

En esta línea se sitúan el mencionado art. 22 RGPD (en caso de que se excepcione la reserva de humanidad), así como también la Carta española de derechos digitales en su art. XXV.2 y 3 (cuando no se aplique la reserva de humanidad para la discrecionalidad, esto es en potestades regladas o en discrecionales donde exista norma permitiendo el uso de IA) y legislación española, como el art. 41 de la ley 40/2015, de 1 de octubre, por ejemplo. Creemos que este supervisor debe coincidir con el responsable del procedimiento, al que alude la ley 39/2015 (véase el art. 53.1 b), y debería ser objeto de identificación de oficio por parte de la Administración actuante.

Como lege ferenda, destaca el ya citado art. 14 del RUEIA, que se refiere precisamente a esta cuestión, bajo el rótulo “Vigilancia humana” y respecto sólo a los usos de IA calificados como de alto riesgo (los detallados en el Anexo III), no existiendo la misma en otros supuestos.

Caso de ser finalmente aprobado, este precepto se ocuparía de diversos aspectos de la supervisión humana, que brevemente describimos tomando en cuenta el texto original de la propuesta de 2021(58):

-Quién supervisa:

-La supervisión debe llevarse a cabo tanto por el proveedor como por el usuario, que de conformidad con el art. 3 son:

““Proveedor”: toda persona física o jurídica, autoridad pública, agencia u organismo de otra índole que desarrolle un sistema de IA o para el que se haya desarrollado un sistema de IA con vistas a introducirlo en el mercado o ponerlo en servicio con su propio nombre o marca comercial, ya sea de manera remunerada o gratuita”;

“Usuario”: toda persona física o jurídica, autoridad pública, agencia u organismo de otra índole que utilice un sistema de IA bajo su propia autoridad, salvo cuando su uso se enmarque en una actividad personal de carácter no profesional”.

-El ser humano que vigila a la IA debe tener determinadas capacidades para poder realizar bien su labor, pues debe en las palabras del art. 14:

- “entender por completo las capacidades y limitaciones del sistema de IA de alto riesgo y controlar debidamente su funcionamiento, de modo que puedan detectar indicios de anomalías, problemas de funcionamiento y comportamientos inesperados y ponerles solución lo antes posible”;

- “ser conscientes de la posible tendencia a confiar automáticamente o en exceso en la información de salida generada por un sistema de IA de alto riesgo (<<sesgo de automatización>>), en particular con aquellos sistemas que se utilizan para aportar información o recomendaciones con el fin de que personas físicas adopten una decisión”;

- “interpretar correctamente la información de salida del sistema de IA de alto riesgo, teniendo en cuenta en particular las características del sistema y las herramientas y los métodos de interpretación disponibles”

Por lo tanto, no basta con que haya un humano que vigile. Debe ser un humano cualificado y dotado de conocimientos y habilidades específicas para ello

-Para el caso de la identificación biométrica autorizada (y sólo para ésta, no para otros casos que pueden ser igual de sensibles, por cierto), se aplica la técnica de los cuatro ojos: una doble supervisión humana (lo que suscita dudas en caso de divergencia en la opinión de ambos supervisores, supuesto no regulado).

-Cuándo se supervisa: el precepto quiere supervisión humana en todo el ciclo de funcionamiento de los sistemas de IA, desde su concepción hasta su aplicación. Dicha supervisión incluye “dotarlos de una herramienta de interfaz humano-máquina adecuada, entre otras cosas”.

-Cómo se supervisa:

-Conforme a lo que desde hace tiempo (así, recuérdense las guidelines de Article 29 Working Party en relación con el RGPD(59)) se señala, la supervisión debe ser significativa (meaningful) esto es, capaz de interferir (“decidir, en cualquier situación concreta, no utilizar el sistema de IA de alto riesgo o desestimar, invalidar o revertir la información de salida que este genere”) y, en su caso, detener el funcionamiento de la IA, mediante lo que podríamos definir como el botón del pánico: la capacidad de activar un mecanismo de parada del sistema que funciona deficientemente.

-No se establece por el RUEIA un estándar determinado de diligencia en la supervisión de la IA. En lo que se refiere a la Administración, ese estándar debe hallarse en la obligación de buena administración de diligencia debida o debido cuidado, un concepto jurídico indeterminado que habrá que precisarse caso a caso, si bien en otro momento hemos propuesto la fórmula c=p x D, una sencilla adaptación de la conocida fórmula del juez estadounidense Learned Hand, donde el coste del nivel de diligencia administrativa (c) ha de ser, como mínimo, igual a la probabilidad de daño (p) multiplicada por la gravedad de éste (D). Por supuesto, la falta de supervisión administrativa que genere daños podrá dar lugar a la correspondiente responsabilidad administrativa.

V. CONCLUSIONES Y CUESTIONES ABIERTAS. PENSAR LO SENTIDO Y SENTIR LO PENSADO

Que exista IA disponible técnicamente, ahora o en el futuro, para ser aplicada en cualquier ámbito de funcionamiento administrativo no significa que sea necesario y conveniente aplicarla siempre y obtener decisiones totalmente automatizadas. En el caso de las potestades discrecionales, consideramos que el derecho y principio a una buena administración impide que la IA simbólica elimine la discrecionalidad y que la no simbólica o conexionista pase de ser un apoyo al decisor humano, puesto que no es posible preprogramar agotadoramente la discrecionalidad basada en reglas y en el caso de la IA estadística, la ausencia de empatía y de capacidad de formular inferencias abductivas recomiendan la ausencia de automatización total.

Por otra parte, las decisiones administrativas totalmente automatizadas no serán posibles cuando el principio contradictorio en el procedimiento administrativo exija un trámite de audiencia, sea en este caso la potestad discrecional o, también, reglada.

Los límites vistos de la IA y sus diferencias con los humanos pueden aconsejar prohibir normativamente su uso en ciertos ámbitos, prohibición que entendemos debería desarrollarse aplicando una opción por defecto (opt ut) en favor del no uso de la IA, de acuerdo con el principio de precaución aludido, salvo que una norma específica la permita, norma que deberá ser aprobada por los representantes democráticos en aplicación de la reserva de ley existente en constituciones como la española, garantizando que no se viola el principio y derecho de buena administración, que en algunos sistemas, como el español, tiene relevancia constitucional, de acuerdo con reiterada jurisprudencia del Tribunal Supremo.

Aceptado el uso de la IA, ahora ya en el marco de la evaluación previa de idoneidad expuesta, la Administración debiera considerar, caso a caso la necesariedad, idoneidad y eficiencia del uso de IA.

Superado este segundo paso, y en fase ya de evaluación concreta del específico uso de la IA, éste debería acompañarse de mecanismos de supervisión o vigilancia humana que sean efectivos. Esa vigilancia humana no se satisface de cualquier manera. El humano que supervise en el seno de una Administración debe tener los conocimientos y habilidades precisas, entre ellas, la capacidad de identificar su propio sesgo cognitivo de automatización y ser capaz de revertirlo. Cabe plantear si la mera posibilidad de presentar un recurso frente a un humano contra la decisión automatizada adoptada satisface la necesidad de supervisión humana. Parece insuficiente una supervisión humana ex post, aunque puede ser útil, si no existe también una supervisión ex ante, durante el proceso de elaboración de la decisión. En todo caso, la intervención humana debe ser efectiva y significativa, en el sentido de ser capaz de interferir con el funcionamiento y llegar a detener éste en caso necesario.

Ello implica, ante todo, la necesidad de una formación y entrenamientos específicos de los empleados públicos (pues tal supervisión puede afirmarse que constituye una función pública a ellos reservada) que van a vigilar los sistemas de IA en materia de des sesgamiento cognitivo, así como formación respecto al funcionamiento de estos. Ante lo que nos podemos plantear si ese tipo de formación puede ser realmente efectiva para la evitación de dicho sesgo, un debate abierto que parece irse decantando por la respuesta afirmativa siempre que tal formación esté convenientemente diseñada(60).

La Agencia Española de Supervisión de Inteligencia Artificial, cuyos estatutos han sido aprobados por el Real Decreto 729/2023, de 22 de agosto, puede tener en este ámbito un papel interesante, dado que entre sus competencias se encuentra la de “creación de conocimiento, formación y difusión en relación con la inteligencia artificial ética y humanista, para mostrar tanto su potencial y oportunidades para el desarrollo socioeconómico, la innovación y la transformación del modelo productivo, como los retos, riesgos e incertidumbres que plantea su desarrollo y adopción” (art. 10.1 g).

En todo caso, existen voces que cuestionan que la supervisión humana de la IA sea una solución realmente efectiva, que pueda dar respuesta adecuada a las necesidades existentes, debido a la complejidad y rapidez de la IA y las limitaciones humanas en la práctica, como en el ámbito jurídico destaca MARCHETTI(61). Se trata de un argumento importante, que requerirá ulteriores análisis. Puesto que, de ser cierto en todos o algunos casos, podría convertir la regulación de la supervisión humana en un mecanismo psicológicamente tranquilizador para la sociedad, una especie de placebo regulador, pero, quizás, inane.

La supervisión o vigilancia humana de la IA en el ámbito administrativo, si es tan relevante como se sostiene, debería configurarse como un auténtico derecho subjetivo de los interesados (a incluir en el art. 53 de la ley 39/2015 y cuya identificación, como responsable del procedimiento, debería ser realizada de oficio por la Administración), generador de correlativas obligaciones jurídicas para la Administración (cuanto menos de medios, sometidas al estándar de debido cuidado propio de la buena administración ya mencionado; véase la interesante sentencia del Tribunal Supremo español de 15 de febrero de 2022(62)).

En caso de reconocerse tal derecho, probablemente debería reflexionarse sobre la necesidad de incluir éste entre los derechos de los interesados en sus relaciones jurídicas con las Administraciones Públicas.

Finalmente, la cuestión de la empatía aquí mencionada, y sus conexiones con la compasión, requerirá de una tarea importante de difusión e insistencia en la relevancia de la misma en el ámbito del Derecho administrativo y en particular en relación con la toma de decisiones discrecionales. En la comunidad jurídica actual en España esta relevancia de la empatía está lejos de ser aceptada, puesto que ha sido un tema abandonado históricamente en nuestra filosofía, cultura académica, jurídica y administrativa occidentales, en las que se acostumbra a confundir la empatía con el sentimentalismo y la parcialidad. Sin embargo, hemos dejado claro aquí que la necesaria utilización de la empatía para nada debe empañar ni la imparcialidad ni la objetividad y es un requisito preciso para la toma de buenas decisiones (también administrativas)(63).

En palabras de MIGUEL DE UNAMUNO, es preciso pensar lo sentido y sentir lo pensado para adoptar buenas decisiones(64), como la moderna neurociencia hemos visto confirma. El propio Unamuno dibujó cómo podría ser una sociedad distópica de máquinas sin empatía en su obra Mecanópolis de 1913(65). Confiemos en que se trate sólo de un relato de ciencia ficción En todo caso, de cara a futuras (y necesarias) regulaciones de la IA tanto a nivel europeo como español(66), deberá hacerse un esfuerzo para aunar lo mejor de lo humano con lo mejor de la IA, para evitar así lo opuesto e indeseable: conjugar lo peor de ambos mundos, esto es, la falta de empatía de las máquinas con los límites cognitivos humanos.

NOTAS:

(1). El presente estudio es resultado del proyecto de investigación PID2020-115774RB-I00, “Personalización de los servicios públicos, sesgos e inteligencia artificial: Hacia la consolidación de los derechos digitales en las administraciones públicas”, financiado por el Ministerio de Ciencia e Innovación español, en el que el autor es coinvestigador principal.

(2). CONSEIL D´ETAT (2022), Intelligence artificielle et action publique : construire la confiance, servir la performance.

(3). Como es sabido, un algoritmo es una secuencia de operaciones y reglas, como una ecuación matemática, diseñada por una persona o grupo de personas para resolver un problema.

(4). Esto, es ingentes cantidades de datos o big data, datos masivos caracterizados por su volumen, variedad y velocidad, las llamadas tres v.

(5). LARSON, E.J. (2022), El mito de la inteligencia artificial. Por qué las máquinas no pueden pensar como nosotros lo hacemos, Shackleton.

(6). Comunicación de la Comisión al Parlamento Europeo, al Consejo Europeo, al Consejo, al Comité económico y social europeo y al Comité de las regiones, Inteligencia artificial para Europa {SWD(2018) 137 final}: ENLACE

(7). El proyecto de Reglamento de IA de la UE define en su Anexo I a la inteligencia artificial como: “Estrategias de aprendizaje automático, incluidos el aprendizaje supervisado, el no supervisado y el realizado por refuerzo, que emplean una amplia variedad de métodos, entre ellos el aprendizaje profundo.

Estrategias basadas en la lógica y el conocimiento, especialmente la representación del conocimiento, la programación (lógica) inductiva, las bases de conocimiento, los motores de inferencia y deducción, los sistemas expertos y de razonamiento (simbólico).

Estrategias estadísticas, estimación bayesiana, métodos de búsqueda y optimización.”

(8). LICKELIDER J.C.R. (1960) “Man-Computer symbiosis”, IRE Transactions on Human Factors in Electronics, volume HFE-1, pp. 4-11, Marzo.

(9). Véase: Muere a los 77 años Stanislav Petrov, el hombre que salvó al mundo de una guerra nuclear entre la Unión Soviética y Estados Unidos - BBC News Mundo.

Existe un documental al respecto: This Man Single Handedly Stopped All Out Nuclear War - The Man Who Saved The World - War Documentary - Bing video, así como una entrevista con Petrov, quien murió en 2017, a la edad de 77 años: Stanislav Petrov, who averted possible nuclear war, dies at 77 - BBC News - YouTube

(10). PONCE SOLÉ, J. (2019): “Inteligencia Artificial, Derecho administrativo y reserva de humanidad: algoritmos y procedimiento administrativo debido tecnológico”, Revista General de Derecho Administrativo, núm. 1, enero.

(11). Art. 41 Ley 40/2015, de 1 de octubre, del Régimen Jurídico del Sector Público:

“Artículo 41. Actuación administrativa automatizada.

“1. Se entiende por actuación administrativa automatizada, cualquier acto o actuación realizada íntegramente a través de medios electrónicos por una Administración Pública en el marco de un procedimiento administrativo y en la que no haya intervenido de forma directa un empleado público.”

(12). COGLIANESE, C. y LAI, A. (2022), "Algorithm vs. Algorithm", Faculty Scholarship at Penn Law. 2795.

(13). KAHNEMAN, D., SIBONY, O., SUNSTEIN, C. (2021): Ruido: Un fallo en el juicio humano, Debate.

(14). PASTOR, A. y NOGALES, P. (2019): “El futuro del trabajo en la administración pública ¿estamos preparados?” Revista Vasca de Gestión de Personas y Organizaciones Públicas, nº. extra-3, págs. 34-51.

(15). PONCE SOLÉ, J. (2022b), Acicates (Nudges), buen gobierno y buena administración. Aportaciones de las ciencias conductuales, nudging y sectores público y privado, Marcial Pons, Madrid.

(16). Véase al respecto, y en general, el interesante libro de BRIDLE, J. (2020): La nueva edad oscura: la tecnología y el fin del futuro, Debate.

(17). Propuesta de REGLAMENTO DEL PARLAMENTO EUROPEO Y DEL CONSEJO POR EL QUE SE ESTABLECEN NORMAS ARMONIZADAS EN MATERIA DE INTELIGENCIA ARTIFICIAL (LEY DE INTELIGENCIA ARTIFICIAL) Y SE MODIFICAN DETERMINADOS ACTOS LEGISLATIVOS DE LA UNIÓN, COM/2021/206 final:

eur-lex.europa.eu/legal-content/PT/TXT/HTML/?uri=CELEX:52021PC0206

(18). Comunicación de la Comisión al Parlamento Europeo, al Consejo Europeo, al Consejo, al Comité económico y social europeo y al Comité de las regiones, Inteligencia artificial para Europa {SWD(2018) 137 final}: ENLACE

(19). Comunicación citada en nota anterior.

(20). Por todos, FERNÁNDEZ, T-R. (2021), <<El derecho a una buena administración: una nueva mirada a la Administración y al derecho administrativo>>, en J. PONCE Y M. VILLORIA (dirs), Anuario del Buen Gobierno y de la Calidad de la Regulación 2020, Madrid: Fundación Democracia y Gobierno Local, págs. 81 y ss.

(21). HOFMANN, HCH (2020): “The Duty of Care in EU Public Law–A Principle Between Discretion and Proportionality” Review of European Administrative Law, vol. 13, no 2, p. 87-112.

(22). PONCE SOLÉ, J. (2019): La lucha por el buen gobierno y el derecho a una buena administración mediante el estándar jurídico de diligencia debida, UAH-Defensor del Pueblo.

“A mi juicio, la tesis anterior no resulta convincente. No se sostiene la afirmación de que el margen de apreciación es un mero margen de cognición. Como se ha señalado, en la zona de incertidumbre los conceptos jurídicos indeterminados no ofrecen al aplicador ningún parámetro o criterio que le permita discernir cuál sea la subsunción procedente del caso concreto. Por lo tanto, en esta zona del concepto la decisión sobre la aplicación que proceda del mismo la acaba adoptando el propio aplicador con arreglo a criterios necesariamente ajenos al concepto y, por ende, conforme a criterios extrajurídicos. En consecuencia, se trata –al igual que sucede cuando se ejerce una potestad discrecional- de una decisión volitiva que en modo alguno emana de un juicio meramente cognitivo”.

BACIGALUPO, M (2023), “La vinculación de la Administración Pública a la Ley y al Derecho”, en VELASCO, F. y DARNACULLETA, M., Manual de Derecho Administrativo, Marcial Pons, Madrid, 2023, p. 150.

(24). Existe, por ejemplo, en el Common Law un deber de la Administración de ejercer su discrecionalidad previo análisis específico del supuesto concreto. Este deber ha sido afirmado en distintas ocasiones por la jurisprudencia, la cual ha declarado gráficamente en el caso British Oxygen v. Board of Trade que "the general rule is that anyone who has to exercise a statutory discretion must not "shut his ears" to an application", afirmando la necesidad de un análisis administrativo de las circunstancias del caso antes de adoptar la decisión discrecional.

(25). CRAIG, P. (2021), Administrative Law, Sweet and Maxwell, Thompson Reuters, 9th edition.

(26). CRAIG, 2021, párrafo 10-025.

(27). Consúltense las diferentes definiciones de humanidad y humano contenidas en los diccionarios. Por ejemplo, en español en el de la Real Academia Española. Éste define a la empatía como el “sentimiento de identificación con algo o alguien” y como la “capacidad de identificarse con alguien y compartir sus sentimientos”. Asimismo, incluye en una de las entradas de la palabra humanidad la siguiente: “sensibilidad, compasión por las desgracias de otras personas”. A su vez, la palabra humano/a es definida en una de sus entradas como “comprensivo, sensible a los infortunios ajenos”.

(28). PULLMAN LE, REFAIE N, LALUMIÈRE ML, KRUPP D. (2021):” Is Psychopathy a Mental Disorder or an Adaptation? Evidence From a Meta-Analysis of the Association Between Psychopathy and Handedness”. Evolutionary Psychology, Octubre.

(29). La BBC, por ejemplo, habla de algoritmo psicópata Véase Así funciona "la mente" de Norman, el algoritmo psicópata del MIT que solo ve lo más tenebroso de la red - BBC News Mundo

(30). LaMDA es el acrónimo en inglés de Modelo de Lenguaje para Aplicaciones de Diálogo. En 2022 un ingeniero de Google, Blake Lemoine, padeció el efecto Eliza, al afirmar que LaMDA era un ser consciente y sintiente, al que incluso proveyó de ayuda legal mediante un abogado. Puede consultarse “The Google engineer who thinks the company´s AI has come to life”, The Washington Post, 11 de junio de 2022.

(31). WEIZENBAUM, J. (1976): Computer power and human reason: From judgment to calculation, W. H. Freeman & Co, traducido al español un año más tarde con el título La frontera entre el ordenador y la mente, Ed. Pirámide, S.A. Madrid. 1977.

(32). RANCHORDAS, S. (2022): “Empathy in the digital administrative state”, Duke Law Journal, Forthcoming, University of Groningen Faculty of Law Research Paper, no 13.

(33). Véase la página web del Consejo de Europa: ENLACE

(34). MÉDIATEUR FÉDÉRAL (2021) - Rapport d’activités, disponible en. Rapport annuel 2021.pdf (federaalombudsman.be)

(35). DAMASIO, A. (1994): El error de Descartes. Andrés Bello.

(36). VAQUER, M. (2023), “La Humanidad del Derecho Administrativo de nuestro tiempo”, Revista de Administración Pública, núm. 222, septiembre- diciembre, pp. 33 y ss.

(37). REIS DE ALBURQUERQUE, A. y DE BRITO MACHADO SEGUNDO, H., (2023) “ A perspectiva evolutive e o problema da relaçao corpo-mente: qual o impacto da ausécia do instinto, das emoçoés e do Nao consciente no processo decisório?”, en PEDRO, R. y CALIENDO, P. (Coords), Inteligência artificial no contexto do Direito público: Portugal e Brasil, Almedina.

(38). ¿Podrían adquirir empatía real en el futuro las máquinas y por tanto replantearnos algunas de las reflexiones que vamos a efectuar aquí? En un interesante artículo en coautoría con MAN, aparecido en 2019 en Nature (MAN, K. y DAMASIO, A. (2019): “Homeostasis and soft robotics in the design of feeling machines”, Nature Machine Intelligence, vol. 1, no 10, p. 446-452 y en el libro de este último Sentir y Saber (DAMASIO, A, 2021, Sentir y Saber, Destino) no se cierra la puerta a ello: se propone trabajar en la línea de otorgar a las máquinas un sentido de supervivencia, simulando en ellas una propiedad biológica de los humanos, la de la homeostasis, esto es, la capacidad de los organismos de permanecer en unas condiciones aceptables para la vida (por ejemplo, temperatura). Si fuéramos capaces de dotar a las máquinas de un sentido de vulnerabilidad y de un comportamiento auto conservador, mediante unos sensores que les enseñen qué factores ocupan un papel en su propia supervivencia (cables conectados, cantidad adecuada de electricidad), se sostiene, ello podría conducir a generar sentimientos (inquietud, satisfacción) y de ahí, quizás, llegar a la empatía.

En todo caso, se trata de una hipótesis. El presente estudio elaborado en 2023 se basa en la situación existente en estos momentos, que no parece vaya a cambiar ni a corto ni a medio plazo.

(40). BRENT, J. (1993) Charles Sanders Pierce. A life, Indiana University Press, p. 349.

(41). HUYS, V. (2018), “L’Abduction ou le risque interprétatif >>, Revue Recherches sur la Philosophie et le Langage, n° 34 - Abduction, número bajo la dirección de Rémi Clot-Goudard, Viviane Huys et Denis Vernant.

(42). FERNÁNDEZ, T.-R. (2019), “El derecho a una buena administración en la Sentencia del TJUE de 16 de enero de 2019”, Revista de Administración Pública, 209, 247-257

(43). CERRILLO, A. (2023), “Actuación automatizada, robotizada e inteligente”, en VELASCO, F. y DARNACULLETA, M., Manual de Derecho Administrativo, Marcial Pons, Madrid, 2023, págs. 526-543

la “opacidad puede deberse a la complejidad del diseño de los algoritmos y su carácter dinámico y cambiante en función de los datos disponibles”

(44). AMERO CASADO, E. (2023) “Las garantías de régimen jurídico del sector público y del procedimiento administrativo común frente a la actividad automatizada y la inteligencia artificial”, en Inteligencia artificial y sector público: retos, límites y medios, coord. por Eduardo Gamero Casado, Francisco Luis Pérez Guerrero, págs. 397-461, sostiene en la pág. 450: “En mi opinión, fuera de los ámbitos expresamente vetados por el Derecho positivo no existe una objeción de carácter dogmático que impida adoptar decisiones automatizadas en ejercicio de potestades administrativas discrecionales. Con arreglo a los postulados que regentan la cuestión −no solo clásicos, sino unívocos, por lo que resulta innecesaria su cita−, la discrecionalidad concede a la Administración un margen de apreciación para adaptarse a las circunstancias del caso concreto. Es perfectamente defendible que esa adaptación a las circunstancias tenga lugar mediante el desarrollo de un sistema algorítmico, de decisión automatizada y, finalmente, de IA, si las circunstancias concurrentes y la parametrización del sistema determinan que ese sea el mejor modo de ejercer la discrecionalidad en un concreto ámbito”.

Por su parte, HUERGO LORA, (2023), “El derecho de transparencia en el acceso a los códigos fuente”, en Anuario de Transparencia Local, 5/2022, Fundación Democracia y Gobierno Local, pp. 35 y ss., pp. 49 y 58, tampoco ve problema, afirmando que la IA conexionista basada en la estadística “influye” en el contenido de la decisión y tiene sentido “en decisionesen las que la Administración tiene un margen de discrecionalidad o bien hay conceptos legales indeterminados”, siendo su uso “posible”, pues “Teóricamente sí” puede emplearse donde exista discrecionalidad administrativa.

Para TORCHIA, L. (2023), Lo Stato Digitale, Il Mulino, pp. 135 y ss., la distinción entre decisión administrativa reglada y discrecional no es útil para determinar los límites del recurso a estructuras algorítmicas, siendo la relación entre automatización y discrecionalidad en la actividad de la administración no de mutua exclusión sino de complementariedad, aunque todavía en estado embrionario y en vía de desarrollo.

(45). SOM, C., HILTY, L.M and KÖHLER, A.R. (2009): “The Precautionary Principle as a Framework for a Sustainable Information Society”, Journal of Business Ethics, 85:493–505.

(46). McCANN, S. (2023) “Discretion in the Automated State”, The Canadian Journal of Law & Jurisprudence, pp. 1 y ss

(47). El Poder Judicial debe ejercerse también conforme a las exigencias de una buena administración de justicia, a la que se refiere la Ley Orgánica 6/1985, de 1 de julio, del Poder Judicial, en distintos artículos (81.3, 152.1. 3º, 165, 167.1, 268, 269, 292, 293, 296, pero sin definir el concepto.