Alba Soriano Arnanz

Decisiones automatizadas y discriminación: aproximación y propuestas generales

El presente trabajo se centra en la perpetuación de la desigualdad a través de los sistemas automatizados de toma de decisiones y de creación de perfiles, analizando las formas en que la normativa en materia de igualdad y no discriminación y, en menor medida, en materia de protección de datos, puede prevenir y hacer frente a las situaciones de discriminación algorítmica. Asimismo, la parte final del artículo se dedica a realizar un esbozo general de posibles propuestas para la elaboración de un marco jurídico que, de manera efectiva, controle y lidie con los diferentes riesgos y daños derivados del creciente uso de sistemas algorítmicos, tanto en el sector público, como en el sector privado.

Alba Soriano Arnanz es Investigadora en el Departamento de Derecho Administrativo de la Universidad de Valencia

El artículo se publicó en el número 56 de la Revista General de Derecho Administrativo (Iustel, enero 2021)

I. EL CRECIENTE USO DE SISTEMAS AUTOMATIZADOS Y SUS RIESGOS. EN CONCRETO, LA DISCRIMINACIÓN ALGORÍTMICA

1. Los sistemas automatizados de toma de decisiones

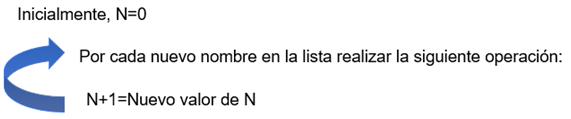

Un algoritmo constituye una serie de instrucciones dirigidas a la resolución de un problema paso a paso. En el contexto de esta investigación, los algoritmos estudiados se ejecutan por ordenadores. Por ejemplo, un algoritmo contenido en el sistema informático de una universidad puede servir para contar las personas que se matriculan en un curso.(1) El algoritmo incorporará las siguientes instrucciones: teniendo en cuenta que, inicialmente, n=0, realizar la operación n + 1 cada vez que aparezca un nuevo nombre en la lista, convirtiendo, en cada ocasión, el resultado de esa operación en el nuevo valor de n. Es decir:

Estas instrucciones se traducen y operacionalizan en código (lenguaje informático). Los algoritmos se utilizan para la consecución de una finalidad en el marco de una representación de la realidad. Esa representación de la realidad, construida mediante las instrucciones contenidas en los algoritmos, se denomina modelo. Se construye un modelo empleando un algoritmo (serie de instrucciones) para contar personas matriculadas. Tenemos un modelo informático (una representación) de lo que sería una persona humana contando alumnas y alumnos matriculados.

Los algoritmos se suelen ejecutar agrupados en programas. Es por ello que las referencias a algoritmos realizadas a lo largo del presente trabajo deben entenderse como referencias tanto a algoritmos individualmente considerados como agrupados en programas.

El algoritmo arriba explicado es muy sencillo y puede agruparse con otros algoritmos para formar sistemas o programas automatizados básicos. La automatización de procesos no es una novedad(2) pues, ya desde hace décadas, se emplean programas de software para la realización de actividades relativamente sencillas como pueda ser, por ejemplo, el cruce de bases de datos de diferentes Administraciones públicas. Por ejemplo, en Noruega, el sistema de asignación de ayudas a la vivienda se encuentra automatizado desde 1972.(3) Dicho sistema se limita a comprobar que las personas solicitantes rellenan los formularios de manera correcta y adjuntan la documentación solicitada.(4) Además, desde 1970 también se han venido desarrollando y utilizando algunos sistemas automatizados de selección de personal en las empresas privadas.

Sin embargo, lo que sí es novedoso y supone un cambio no sólo cuantitativo sino, a partir de cierto punto, también cualitativo, es la enorme y creciente capacidad computacional actualmente poseída por los sistemas de procesamiento de datos y automatización de procesos de toma de decisión, así como el aumento de su aptitud para el autoaprendizaje. En la actualidad, estos sistemas pueden analizar rápidamente enormes cantidades de datos, inasumibles para cualquier persona humana, e incluso mejorar la forma en que realizan estos tratamientos de datos, en lo que es un proceso claramente semejante al aprendizaje, de manera autónoma.(5) Es por ello que estos sistemas se emplean de manera creciente, tanto por el sector público como por el sector privado, en toda clase de procesos de toma de decisiones con el objetivo de clasificar o predecir situaciones o comportamientos, recomendar líneas de actuación, o una combinación de todas estas funciones.

En el sector privado, podemos encontrar abundantes ejemplos de uso de sistemas automatizados en la selección de personas candidatas a puestos de trabajo,(6) en la determinación de la capacidad crediticia de las personas físicas(7) o en la determinación de los resultados de las búsquedas de información realizadas en plataformas digitales.(8) En el sector público, los algoritmos se emplean en la configuración de los sistemas de ayudas públicas,(9) en la provisión de servicios públicos y también en la actividad desarrollada por los cuerpos y fuerzas de seguridad,(10) así como en otras clases de actividades de limitación, con una creciente incidencia en los procesos de análisis de datos y detección de pautas que permitan identificar conductas, o incluso preverlas, dentro de las actividades de inspección y control.(11)

Asimismo, el creciente uso y nivel de desarrollo de estos sistemas, ha traído consigo un aumento de la incidencia que los algoritmos tienen o pueden llegar a tener, en los derechos fundamentales de las personas y, de manera general, en muchos y diferentes aspectos de sus vidas. Los algoritmos empleados en la actualidad en procesos como el cálculo del riesgo de reincidencia o en la creación de publicidad dirigida y adaptada a su público objetivo, emplean tecnologías conocidas como aprendizaje de máquina o, en su nivel más complejo, aprendizaje profundo, que tienen la capacidad de extraer relaciones entre diferentes datos contenidos en inmensas bases de información y predecir resultados, llegando a conclusiones y tomando decisiones o realizando sugerencias en función de la información que les es proporcionada.(12)

2. La discriminación algorítmica

El auge de los sistemas automatizados de toma de decisiones en todos los ámbitos ha traído consigo la constatación de que, lejos de resolver problemas y procesos de manera objetiva, los algoritmos reproducen y perpetúan las estructuras de discriminación que afectan a las personas pertenecientes a grupos que, históricamente, se han encontrado en una posición de subordinación y desventaja.(13) Este trabajo se centra en las denominadas categorías sospechosas de producir discriminación, es decir, aquellas características que se corresponden con elementos de la persona en principio inmutables, como el sexo, la edad o la raza, o que se sitúan en el núcleo mismo de la dignidad de la persona, como las creencias religiosas u opiniones políticas. Precisamente por ser estas características inmutables o íntimamente relacionadas con la dignidad de la persona se atribuye un mayor desvalor a las decisiones que discriminan con base en dichos elementos.(14)

Dentro de las categorías sospechosas, este trabajo se centra en la protección de los grupos especialmente desaventajados o vulnerables, a saber, personas de bajo nivel socioeconómico; mujeres; minorías étnicas, raciales, nacionales y religiosas; grupos de edad vulnerables; identidades y orientaciones sexuales no normativas; personas con discapacidad, etc. Es decir, en las personas pertenecientes a aquellos grupos que han sufrido una situación histórica de desventaja que todavía hoy se perpetúa en la construcción de las estructuras sociales de poder.

2.1. La discriminación algorítmica como fenómeno bicéfalo

La discriminación algorítmica es una realidad que debe ser analizada desde una doble vertiente o perspectiva. Por una parte, como fenómeno que vulnera el principio de igualdad y los derechos fundamentales a la igualdad y a la no discriminación y, por otra, como uno de los múltiples daños y riesgos generados por las tecnologías de procesamiento de datos y de automatización de la toma de decisiones.

Con respecto a la primera perspectiva, resulta necesario entender la construcción de las sociedades actuales sobre unas estructuras que, históricamente, han situado a las personas pertenecientes a determinados grupos en una posición de desventaja. Dichas estructuras de discriminación generan los fenómenos de discriminación estructural, sistémica o institucional que todavía hoy perviven y que sitúan a determinadas personas en una posición de desventaja y especial vulnerabilidad como consecuencia de su pertenencia a determinados grupos. La construcción de unas sociedades sesgadas (discriminatorias) tiene como resultado la creación de instituciones y productos, también los normativos, desequilibrados a favor de los grupos dominantes y su ideología. Los algoritmos, como productos creados por los seres humanos y utilizados para analizar, reflejar la realidad y tomar decisiones con respecto a la realidad que analizan, corren el riesgo de integrar e interiorizar, por una amplia serie de razones, esos mismos sesgos y estereotipos que perjudican a las personas pertenecientes a grupos desaventajados. Como forma de vulneración de los derechos a la igualdad y a la no discriminación, la discriminación algorítmica debe ser, por tanto, abordada desde el marco jurídico en materia de igualdad y no discriminación.

Sin embargo, es importante tener en cuenta que la discriminación resultante de los procesos algorítmicos, y también la perpetuación de la desigualdad que puede resultar de la automatización de los sistemas de servicios y ayudas públicas, se producen a través de un fenómeno muy específico: el creciente desarrollo e introducción de tecnologías de procesamiento de datos y de automatización de decisiones. Es por ello que la discriminación algorítmica debe ser abordada también como uno más de los riesgos y daños generados por esta clase de sistemas y en el contexto de las características específicas de las decisiones automatizadas.

Así, cabe destacar que los algoritmos y las nuevas tecnologías de procesamiento de datos generan también una amplia variedad de problemas que van más allá de las posibles vulneraciones a los derechos a la igualdad y no discriminación con base en las llamadas “categorías sospechosas”. Los sistemas automatizados de toma de decisiones, incluyendo los de creación de perfiles, presentan problemas de opacidad, de dificultad en la adjudicación de la responsabilidad de las decisiones, así como importantes riesgos para la autonomía, libertad y dignidad de las personas y sus derechos a la intimidad y a la protección de datos. Asimismo, cuando estos sistemas se emplean por el sector público, pueden conllevar importantes quiebras en la cadena de legitimidad de las decisiones emanadas de los poderes públicos.

Con respecto a esta segunda vertiente desde la que se debe analizar la discriminación algorítmica como fenómeno social y jurídico, es necesario subrallar la íntima relación que guardan entre sí los diferentes riesgos y afecciones a los derechos fundamentales y otros intereses públicos derivados del creciente uso de algoritmos. Así, por ejemplo, difícilmente podrán probarse los casos de discriminación algorítmica directa, esto es, la toma de una decisión discriminatoria teniendo en cuenta una categoría sospechosa, si no se tiene acceso o no se dispone de una explicación suficiente de la lógica sobre la que basa su decisión el sistema.

Es más, teniendo en cuenta que, en la actualidad, el marco normativo en materia de protección de datos constituye la principal herramienta dirigida a regular, de manera específica, el tratamiento y procesamiento automatizado de datos y que las normas de protección de datos pretenden ofrecer un amplio marco que, en la medida posible, abarque todas las vicisitudes derivadas de la progresiva automatización de procesos, resulta necesario abordar de manera conjunta los diferentes problemas derivados del creciente uso de sistemas algorítmicos. Es por ello que, si bien las cuestiones problemáticas derivadas del uso de sistemas automatizados diferentes de la vulneración de los derechos a la igualdad y a la no discriminación no constituyen, en sentido estricto, el objeto de estudio de este trabajo, también lo son y se abordan, en la medida en que afectan a las situaciones de discriminación y perpetuación de la desigualdad mediadas por sistemas automatizados.

Cabe también destacar que el objeto de este trabajo no lo constituye cualquier clase de tratamiento o de procesamiento de datos, sino que solo lo constituyen aquellos tratamientos y procesamientos de datos realizados de manera total y parcialmente automatizada. Es importante delimitar esta cuestión por cuanto la normativa en materia de protección de datos, a la que se hará referencia, también aborda el tratamiento no automatizado de datos. Por ello, se debe tener en cuenta que toda referencia realizada a las disposiciones normativas contenidas en dicho marco jurídico y a los problemas derivados del tratamiento y procesamiento de datos se debe entender efectuada al tratamiento, procesamiento y consiguiente toma de decisiones automatizadas.

2.2. La discriminación algorítmica como fenómeno supranacional

Asimismo, el marco jurídico de análisis de este trabajo se centra en el ordenamiento de la Unión Europea (y también la Convención Europea de Derechos Humanos como instrumento jurídico de protección de los derechos a la igualdad, a la no discriminación y a la protección de datos, aplicable a los países miembros de la Unión Europea).

La razón por la que se opta por un ámbito de análisis supranacional es, en primer lugar, que el fenómeno de la extensión del uso de sistemas automatizados, y los problemas que dichos sistemas generan, tiene lugar de manera muy similar en todos los Estados europeos.

En segundo lugar, el ámbito de acción de los sistemas algorítmicos no se rige por las fronteras nacionales, sino que un mismo sistema puede afectar a ciudadanas y ciudadanos de distintos Estados. Además, no debe perderse de vista, reforzando esta idea, que un sistema creado en un Estado puede ser vendido a empresas pertenecientes a otros muchos, lo que abunda en la necesidad de un tratamiento y encuadre jurídico que vaya más allá del ámbito estrictamente nacional. En definitiva, y como es sabido, en el caso de las grandes corporaciones tecnológicas transnacionales, cada vez más presentes y dominantes, los problemas generados por los algoritmos que estas empresas emplean tienen incidencia a nivel global.

En tercer lugar y, por último, las respuestas normativas que, hasta el momento, se han pretendido dar a los problemas generados por esta clase de sistemas y que pueden englobarse en la elaboración del marco jurídico en materia de protección de datos, han tenido lugar a nivel europeo. Además, las recientes propuestas relativas a un nuevo marco de regulación y control de los algoritmos también prevén que las futuras respuestas jurídicas a los riesgos y daños generados por los algoritmos se desarrollen por las instituciones de la Unión.

II. EL MARCO JURÍDICO PARA LA PROTECCIÓN DE LA IGUALDAD Y LA NO DISCRIMINACIÓN Y SU APLICACIÓN A LA DISCRIMINACIÓN ALGORÍTMICA

1. (Des)igualdad y discriminación en Europa

Las sociedades occidentales se han construido, históricamente, sobre unas estructuras de subordinación de unos grupos en relación con otros. Así, con la aparición de las primeras democracias liberales, a las personas pertenecientes a los grupos subordinados les fue negada la condición de ciudadanía plena. En la actualidad y, en algunos casos, desde hace ya décadas, se reconoce la participación total de las personas pertenecientes a estos grupos o colectivos.(15) Sin embargo, dicho reconocimiento y acceso formal a las estructuras e instituciones de poder no ha venido necesariamente acompañado de un disfrute en igualdad de condiciones de los privilegios y prerrogativas de los grupos que, históricamente, han ocupado el poder.

La igualdad constituye un valor superior y principio en el que las instituciones públicas de los Estados democráticos de Derecho deben basar su actuación. Asimismo, la igualdad y no discriminación se configuran como derechos fundamentales subjetivos de la ciudadanía de estos Estados, que tienen la obligación negativa y positiva de protegerlos. Sin embargo, esta construcción parte de una aproximación eminentemente formal a la igualdad que no considera las estructuras subyacentes de discriminación que sitúan en una posición de desventaja a las personas pertenecientes a aquellos grupos que históricamente se han situado en una posición de subordinación.(16)

En la actualidad los ordenamientos jurídicos de la UE y de sus Estados miembros reconocen el especial desvalor de las situaciones de discriminación por razón de una serie de categorías sospechosas. Asimismo, de manera creciente se ha ido ampliando el cuerpo de normas que reconocen estos derechos en las relaciones entre particulares y, en paralelo, una parte cada vez más importante de la doctrina defiende la eficacia horizontal inmediata o directa de los derechos a la igualdad y la no discriminación. Ahora bien, puesto que estas construcciones se basan fundamentalmente en perspectivas formales de la igualdad, el reconocimiento de una especial protección frente a la discriminación por razón de sexo, raza, religión, etc., se basa, sobre todo, en la asunción del hecho de que estas son categorías (en principio) inmutables o que pertenecen al espacio inherente a la dignidad humana.

Así, la especial protección ofrecida en estas situaciones no se centra, o al menos no de manera principal, en el reconocimiento de la discriminación sistémica que dentro de cada una de estas categorías sospechosas coloca a las personas pertenecientes a un subgrupo (mujeres frente a hombres, minorías raciales frente a personas blancas, etc.) en una posición de desventaja social y de especial riesgo de trato desigual. Es por ello que, a pesar de que las perspectivas sustantivas de igualdad y no discriminación se van incorporando progresivamente a los ordenamientos jurídicos de los Estados democráticos y de Derecho, el ordenamiento jurídico únicamente reconoce y aborda la existencia de estas estructuras sociales de opresión de manera fragmentaria y, en demasiadas ocasiones, poco eficaz.

El reconocimiento y protección de los derechos a la igualdad y a la no discriminación encuentran importantes tensiones en relación con el libre desarrollo de la autonomía de la voluntad de los individuos y, en algunos casos, con la eficiencia entendida desde una perspectiva económica.(17) Es más, en el sector privado, estos dos elementos (autonomía y eficiencia) tienden a conjugarse y cristalizar en la libertad de empresa. Sin embargo, la libertad únicamente existe cuando las personas tienen verdadera capacidad de decidir, es decir, si tienen opciones. En cambio, si a una persona le es negado el acceso a un bien o servicio o no se le escoge para un puesto de trabajo porque pertenece a un grupo desaventajado, o por otros elementos que se encuentran vinculados a la pertenencia al grupo, se le está negando la libertad. Es por ello que la protección de la igualdad debe también ser entendida como protección de la libertad y, también, la razón por la cual, en ocasiones, una medida que aparentemente pueda suponer una limitación de la libertad, en realidad sirve para reequilibrar la balanza y garantizar la libertad de aquellas personas que, por su pertenencia a determinados grupos, parten con desventaja en algunos ámbitos de la vida social, económica y política.(18)

Ahora bien, puesto que el ordenamiento jurídico europeo se asienta sobre unas estructuras cuyo objetivo fundamental ha sido garantizar la libertad económica, y puesto que dicha libertad económica ha sido históricamente construida desde la perspectiva de aquellos que ocupaban el poder, la protección de la igualdad, aunque reconocida, carece generalmente de la profundidad requerida para atajar, desde la raíz, la discriminación sistémica existente en la sociedad. En el marco de la Unión Europea la libertad de empresa se protege por defecto y la protección de los derechos fundamentales a la igualdad y no discriminación se sitúa, en realidad, en un plano secundario.

2. Instrumentos jurídicos para la protección frente a la discriminación

El marco jurídico en materia de igualdad y no discriminación se compone de una serie de instrumentos de protección preventiva y reactiva frente a las situaciones de discriminación. Dentro de las herramientas de protección preventiva frente a la discriminación, la distinción que realiza la doctrina estadounidense entre instrumentos de anti-clasificación y anti-subordinación resulta útil de cara al análisis de la discriminación algorítmica, sobre todo con respecto a los paralelismos que pueden dibujarse entre la normativa de protección de datos y los instrumentos de anti-clasificación.(19)

Los instrumentos jurídicos de anti-clasificación se refieren a aquellas normas que prohíben la consideración de las categorías especialmente sospechosas en los procesos de toma de decisión. Esta estrategia se encuentra íntimamente ligada al artículo 9 del Reglamento General de Protección de Datos (RGPD),(20) que prohíbe el procesamiento de categorías especiales de datos personales, las cuales incluyen el origen racial, las convicciones religiosas o las opiniones políticas.

Por su parte, los instrumentos jurídicos de anti-subordinación reconocen y pretenden revertir aquellas estructuras sociales que sitúan a las personas pertenecientes a determinados grupos o colectivos en una situación de desventaja.(21) Entre los mecanismos incluidos en estos instrumentos se encuentran, por ejemplo, las acciones positivas y las iniciativas e instituciones que actúan a partir de la transversalización de la igualdad.

Con respecto a los instrumentos jurídicos reactivos frente a las situaciones de discriminación, ha de hacerse referencia a las prohibiciones de discriminación directa e indirecta. Las prohibiciones de discriminación operan también, en cierta medida, como mecanismos de prevención al articular mandatos que pretenden evitar la toma de decisiones discriminatorias. Sin embargo, dado que los efectos de dichas prohibiciones tienen lugar como mecanismos ex post de identificación y resarcimiento de vulneraciones al derecho a la no discriminación, deben ser tratados y examinados como instrumentos de reacción frente a las situaciones de discriminación.

3. La perpetuación de la desigualdad mediante el uso de algoritmos

En este marco de creciente utilización de sistemas automatizados, se ha ido llamando la atención, en los últimos años, sobre la aparición de múltiples casos de discriminación algorítmica y de situaciones en las que la automatización de procesos contribuye a perpetuar las situaciones de vulnerabilidad de algunos grupos de la población. Así, se ha puesto de relieve que los procesos de desarrollo y puesta en funcionamiento de los algoritmos ofrecen una amplia serie de posibilidades para la incorporación de sesgos que perjudican a los miembros de grupos desaventajados.(22)

Una de las formas en las que se pueden crear algoritmos que reproduzcan las tradicionales estructuras de discriminación de miembros de grupos desaventajados es a través de la selección y peso otorgado a las variables empleadas por estos sistemas para la medición y predicción del objeto del que se ocupan. La forma en la que se da prioridad a unas variables sobre otras en la medición de los fenómenos que los algoritmos se encargan de predecir puede condicionar y sesgar los resultados de estos programas. Por ejemplo, si un sistema de calificación del crédito de la clientela de un banco prioriza el nivel de ingresos sobre la capacidad de ahorro como elemento indicativo de la capacidad crediticia de una persona física, esta decisión perjudicará a las mujeres en mayor medida que a los hombres como consecuencia de la brecha salarial por razón de género. Esta cuestión es relevante por cuanto la capacidad de ahorro de las mujeres es mayor que la de los hombres.(23)

Uno de los elementos esenciales a destacar, en este sentido, es que los algoritmos, en muchas ocasiones, no discriminan con base en las denominadas categorías sospechosas, sino que lo hacen al emplear criterios de medición aparentemente neutros que, sin embargo, perjudican en mayor medida los miembros de grupos desaventajados que a los no miembros.(24)

La discriminación algorítmica también puede venir derivada de los errores o sesgos contenidos en las bases de datos empleadas en el desarrollo de los sistemas de toma de decisiones automatizadas. Por ejemplo, una base de datos de detenciones y condenas puede contener fundamentalmente datos sobre individuos de minorías étnicas y raciales como consecuencia de la discriminación sistémica sufrida por estos grupos poblacionales tanto en sus relaciones con los cuerpos y fuerzas de seguridad como con el sistema de justicia. En este caso, el algoritmo aprenderá, de manera indirecta, que la pertenencia a una minoría étnica o racial está relacionada con un mayor índice de criminalidad.(25)

En otros casos, el uso de algoritmos puede servir para perpetuar estereotipos en los que se basan las estructuras sociales de discriminación. Por ejemplo, no son pocos los casos en que se ha detectado que los resultados obtenidos como consecuencia de la introducción de determinadas combinaciones de palabras en los motores de búsqueda de Internet (principalmente Google) reproducen los roles de género, cosifican a las mujeres o contribuyen a la consolidación de estereotipos negativos sobre las personas no blancas.(26)

También existe la posibilidad de que no sea el propio algoritmo el que discrimine, sino que las decisiones que se tomen en relación con los resultados que genera sean discriminatorias. Por ejemplo, en 2018, el servicio público de desempleo de Austria comenzó a utilizar un algoritmo en fase de pruebas para clasificar a las personas desempleadas según su probabilidad de encontrar un nuevo trabajo. La introducción definitiva de este sistema automatizado, llamado PAMAS, ha tenido lugar durante 2020 y su objetivo es llevar a cabo la asignación de recursos públicos de la manera más eficiente posible.(27)

El algoritmo analiza diferentes características de las personas desempleadas y proporciona a cada persona una puntuación. Dependiendo de la puntuación obtenida, el algoritmo clasifica a las personas analizadas en tres categorías diferentes según las probabilidades que tengan de encontrar un nuevo trabajo: probabilidad alta, media o baja.(28)

La primera controversia en torno a este sistema automatizado surgió cuando la empresa contratada para crear el modelo publicó el código fuente. En dicho documento se podía ver cómo se restaban puntos a aquellas personas pertenecientes a determinados grupos desaventajados o vulnerables. Por ejemplo, entre otros elementos, ser mujer o nacional de un Estado no miembro de la UE resta puntos. Así pues, una persona perteneciente a varios grupos especialmente susceptibles de sufrir discriminación vería su puntuación considerablemente reducida y, por tanto, aquellas personas vulnerables en situación de mayor riesgo de exclusión social se clasificarían en la categoría de "baja probabilidad de encontrar un empleo".

Si bien este sistema es objetivo en la medida en que se limita a reflejar las prácticas discriminatorias existentes en el mercado laboral, ha sido muy criticado por algunas organizaciones y sectores sociales austríacos. Estas críticas no son infundadas, ya que el sistema contribuye a la estigmatización de estos grupos y de sus miembros por el mero hecho de clasificar a las personas más vulnerables en la categoría inferior.(29) Sin embargo, el servicio público de desempleo austriaco defendió la necesidad de que el sistema funcione de esta manera para garantizar que los recursos públicos se distribuyan de la mejor manera posible, proporcionando una ayuda más adecuada a las personas que puedan encontrar más dificultades para acceder al mercado de trabajo con una ayuda más apropiada.(30)

Ahora bien, aunque el servicio público de desempleo justificó esta forma de clasificación bajo el pretexto de ofrecer una mejor ayuda a las personas que tenían más dificultades para encontrar un nuevo empleo, decidieron dar prioridad a la eficiencia en la asignación de los recursos públicos sobre cualquier otro objetivo. Así pues, tras llegar a la conclusión de que la asignación de recursos más eficaz sería la de proporcionar más recursos a las personas con una probabilidad media de encontrar un nuevo empleo, se decidió reducir considerablemente la cantidad de recursos y otras ayudas proporcionadas a las personas desempleadas cuyas posibilidades de reincorporarse al mercado laboral son menores,(31) perpetuando así las situaciones de exclusión social que sufren determinados grupos e individuos, y ayudando a reforzar la construcción de estructuras e instituciones sociales mediante relatos de subordinación de los grupos históricamente oprimidos.

Es por ello, que no solo debe prestarse atención a los resultados ofrecidos por los algoritmos cuando realizan tratamientos de datos, sino también a la forma en que se toman decisiones con respecto a dichos resultados.

Asimismo, cabe destacar el riesgo para la perpetuación de la desigualdad que los sistemas algorítmicos empleados en la asignación de recursos públicos y, en general, en la gestión de programas de ayudas sociales pueden tener. Es necesario tener en cuenta que los grupos poblacionales que recurren a las ayudas y servicios públicos dirigidos a mitigar la desigualdad se encuentran en situaciones de mayor vulnerabilidad económica y disponen de menos recursos para la defensa de sus derechos e intereses frente a los posibles errores cometidos en los procesos de concesión y provisión de ayudas y servicios públicos. Es por ello que la automatización de esta clase de actividad produce una serie de riesgos especialmente perjudiciales para la reducción de las diferencias sociales. Así, estos riesgos no se refieren tanto a situaciones específicas de discriminación en las que se privilegie a un subgrupo sobre otro dentro de una categoría sospechosa, sino a que los errores que pueden producir estos algoritmos contribuyen a perpetuar la posición de desventaja y vulnerabilidad de aquellos colectivos a quienes se dirigen, de manera específica, las ayudas y servicios públicos.

En relación con la automatización de los sistemas de ayudas propios del Estado de bienestar, es especialmente relevante señalar la creciente utilización, por parte del sector público, de sistemas algorítmicos privados de detección de fraude en la solicitud de ayudas públicas.(32) Este proceso está alejando a los sistemas de seguridad social y a los programas de ayudas públicas de su objetivo como redes de seguridad para los ciudadanos.(33) Cada vez se presta más atención al control las personas con menos recursos económicos, reforzando así los estereotipos negativos de las personas pertenecientes a los estratos socioeconómicos más bajos de la sociedad como personas poco fiables que se aprovechan de los servicios y ayudas proporcionados por el Estado y que, por tanto, deben ser controladas y ver sus derechos a la intimidad y a la protección de datos mermados.(34)

4. La aplicación del marco jurídico para la protección de la igualdad y no discriminación al uso de algoritmos

La protección frente a la discriminación desarrollada en Europa se basa en las prohibiciones generales de discriminación con base en las denominadas categorías sospechosas contenidas en el Convenio Europeo de Derechos Humanos(35) y la Carta de los Derechos Fundamentales de la UE.(36) También el Tratado de Funcionamiento de la UE contiene diversas disposiciones en las que se reconoce la protección y promoción de la igualdad y no discriminación como derechos subjetivos de la ciudadanía de los Estados miembros de la Unión.(37) En el marco de la UE, el desarrollo específico de dichas prohibiciones se contiene en las Directivas de Igualdad(38) que clasifican las situaciones de discriminación como discriminación directa o indirecta.

4.1. La discriminación algorítmica directa

La discriminación directa tiene lugar cuando una persona es tratada de manera menos favorable por razón de su pertenencia a uno de los subgrupos contenidos en las categorías sospechosas. Es por ello que la discriminación algorítmica directa puede tener lugar cuando se introduzcan en el algoritmo los datos relativos a la pertenencia a un grupo desaventajado y a dicha pertenencia se asocie un valor negativo. Ese valor negativo puede conducir directamente a una consecuencia final negativa (por ejemplo, ser de procedencia hispana implica de manera automática la no concesión de un crédito) o puede contribuir a reducir la puntuación o empeorar el resultado final, pero no ser determinante para su obtención.

La discriminación directa también puede tener lugar cuando se infiera la pertenencia de una persona a un grupo desaventajado de otros datos a los que se atribuya un valor negativo. Los diseñadores del algoritmo pueden articular dichas inferencias de manera consciente o inconsciente y también es posible que el algoritmo las desarrolle una vez que se ponga en funcionamiento. Para que estos casos entren en el ámbito de la discriminación directa, los datos de los que se infiere la pertenencia al grupo especialmente protegido no pueden ser criterios aparentemente neutros, es decir, no deben ser significativos para predecir la variable objetivo.(39) La variable objetivo es el aspecto de la realidad que el algoritmo trata de medir, por ejemplo, la solvencia de una clienta de un banco o el rendimiento profesional de un trabajador de una empresa.

Esta forma de discriminación directa puede tener lugar si, por ejemplo, un algoritmo aprende que las personas que hayan pertenecido a asociaciones de mujeres no son buenas candidatas para un puesto de trabajo simplemente porque en la base de datos de la que aprende no hay prácticamente mujeres y, por tanto, no hay prácticamente personas pertenecientes a asociaciones de mujeres. Aunque la categoría “sexo” no aparezca en el procesamiento, el sistema inferirá dicho dato de otra categoría de datos que, en realidad, no predice si una persona será buena empleada o no. Algo similar ocurrió con un algoritmo que Amazon trató de desarrollar y que terminó por descartar ya que al haber sido entrenado mayoritariamente con currículums de hombres el algoritmo llegó a la conclusión que era preferible contratar hombres que contratar mujeres, por lo que discriminaba contra personas en cuyo currículum aparecían palabras de las cuales infería que una candidata era mujer aunque estos datos no tuviesen relevancia para la predicción de la calidad como trabajadora de la persona candidata.(40)

Igual que en la otra clase de discriminación algorítmica directa, el valor negativo asociado a la categoría de datos inferida podrá determinar de manera directa el resultado o contribuir a él, pero no ser necesariamente determinante en su obtención.

4.2. La prueba en la discriminación algorítmica directa

Los casos de discriminación algorítmica directa en los que la pertenencia al grupo explícitamente incluida determine de manera automática un resultado negativo, serán relativamente fáciles de probar incluso sin acceder al contenido del algoritmo. Cabe destacar, en este sentido, que el Tribunal de Justicia de la Unión Europea (TJUE) considera que, en aquellos casos en los que el criterio formal en virtud del cual se toma una decisión sea inseparable de la pertenencia al grupo desaventajado, la acción puede ser considerada como constitutiva de discriminación directa.

Por ejemplo, en el caso Tadao Maruko,(41) el TJUE determinó que una norma que sólo permite reconocer la pensión de viudedad a aquellas personas que estuvieron casadas con sus parejas constituye una medida que discrimina de manera directa contra las personas homosexuales en aquellos países en los que no se les está permitido casarse.

Por consiguiente, aunque no se disponga de la información relativa a la inclusión de la categoría sospechosa como dato que determine la decisión algorítmica, en caso de afectar esta de manera negativa a todos los miembros del grupo desaventajado, deberá considerarse como un supuesto de discriminación directa.

Sin embargo, en aquellos casos en los que se produce un caso de discriminación algorítmica directa que no afecta de manera evidente a todas las personas pertenecientes al grupo protegido, será mucho más complejo probar dicha situación. Así, en la mayoría de supuestos, salvo que se pueda acceder al contenido del algoritmo, no será fácil probar la existencia de una situación de discriminación directa. Cabe destacar que la importancia de calificar correctamente los supuestos de discriminación directa se deriva de la más fácil justificación de la discriminación indirecta.

Si bien no hay casos específicos relativos a la necesidad de revelar algoritmos en el contexto de decisiones discriminatorias, las sentencias dictadas en los casos Danfoss(42) y Galina Meister(43) del TJUE ofrecen algunas pistas sobre las posibles respuestas que podría dar el este tribunal ante solicitudes de acceso al código fuente de sistemas algorítmicos que son sospechosos de producir discriminación.

En la sentencia dictada en el caso Danfoss, el TJUE estableció que:

“[C]uando una empresa aplica un sistema retributivo caracterizado por la falta total de transparencia, recae sobre el empresario la carga de la prueba de que su política de salarios no es discriminatoria, una vez que los trabajadores femeninos hayan demostrado, a partir de un número relativamente importante de trabajadores por cuenta ajena, que la retribución media de los trabajadores femeninos es inferior a la de los trabajadores masculinos.”(44)

Si bien el Tribunal atribuye a la parte demandada la carga de probar que un sistema de remuneración opaco no es discriminatorio, solo lo hace una vez que se ha demostrado que dicho sistema perjudica a las mujeres.

Por su parte, la sentencia dictada en el asunto Galina Meister establece que las disposiciones contenidas en las Directivas de Igualdad de la UE que establecen las normas relativas a la carga de la prueba en casos de discriminación “deben interpretarse en el sentido de que no prevén el derecho de un trabajador que alega de forma verosímil que reúne las condiciones enunciadas en un anuncio de contratación y cuya candidatura no ha sido seleccionada, de acceder a la información que indica si al término del proceso de selección el empresario ha contratado a otro candidato.”(45)

Así, en ambos supuestos, si la parte demandante solo sospecha que la decisión fue discriminatoria pero no puede aportar un elemento de comparación o prueba de trato discriminatorio, la parte demandada no tiene la obligación de revelar la lógica subyacente a la decisión. Siguiendo este razonamiento, si un algoritmo arroja resultados discriminatorios pero las personas afectadas no pueden probar el trato discriminatorio porque no tienen acceso a los resultados producidos para otras personas, la persona demandada no tendrá la obligación de dar acceso al sistema ni de justificarlo.

Cabe, en todo caso, tener en cuenta que varios tribunales y órganos administrativos han obligado a dar acceso al código fuente de diferentes sistemas automatizados empleados por el sector público.(46) Si bien esta tendencia podría dar pie a una creciente exigencia de transparencia también en el contexto de la discriminación algorítmica, todavía no se encuentra lo suficientemente consolidada, ya que son pocos los supuestos de algoritmos cuya transparencia ha llegado a ser enjuiciada por tribunales o sometida a la valoración de órganos administrativos. Asimismo, todavía queda por resolver el nivel de transparencia exigible a actores privados.

Es más, en algunas ocasiones será incluso difícil proporcionar un elemento de comparación si los datos de los resultados obtenidos por otras personas sometidas al mismo proceso de toma de decisión se encuentran protegidos por la normativa en materia de protección de datos. Este problema podría ser parcialmente resuelto a través de la solicitud de datos anonimizados agregados.(47)

Asimismo, con respecto a la aportación de un elemento de comparación, dado que los algoritmos que se utilizan de manera creciente tienen la capacidad de aprender y desarrollarse de manera autónoma, puede suceder que sea casi imposible encontrar supuestos la decisión en relación con los cuales haya sido adoptada sobre exactamente los mismos parámetros.

Para aquellos casos en los que no se dé acceso pleno al algoritmo, deberá establecerse la posibilidad de experimentar con el sistema, introduciendo diferentes perfiles para comprobar si este efectivamente discrimina o no con base en alguna de las categorías sospechosas.(48) Ahora bien, si el sistema no tiene en cuenta las categorías sospechosas sino que las infiere de otros datos, será prácticamente imposible deducir si se trata de un supuesto de discriminación directa o indirecta ya que, sin acceso al sistema, no será posible determinar si las variables que se tienen en cuenta, y que derivan en un trato discriminatorio, tienen valor predictivo o no para el objetivo para el que se utiliza el algoritmo.

4.3. La discriminación algorítmica indirecta

El enjuiciamiento de los supuestos de discriminación indirecta requiere que se acredite la existencia de una disposición, práctica o criterio aparentemente neutros que produzcan efectos más perjudiciales para las personas pertenecientes al grupo protegido que a las no pertenecientes a dicho grupo. Una vez que se acredita la existencia, a primera vista, de un supuesto de discriminación indirecta como el descrito, se traslada la carga de la prueba a la parte demandada, que habrá de demostrar que no se ha vulnerado el principio de igualdad de trato.(49)

En el caso de la discriminación algorítmica, la disposición, práctica o criterio aparentemente neutro puede ser la variable específica introducida en el sistema que, por el valor que le otorga este, genera un resultado discriminatorio para el grupo desaventajado, o bien el algoritmo generalmente considerado. El primer caso será más complicado de establecer puesto que para determinar la variable o variables que generan el resultado discriminatorio se necesitará tener acceso al sistema. Es más, en muchas ocasiones, la gran cantidad de datos procesados y la complejidad de los sistemas de procesamiento impiden identificar de manera clara cuáles son los elementos que condicionan los resultados del sistema. Es por ello que, como norma general, será el sistema en su totalidad el que deba ser considerado como disposición, práctica o criterio aparentemente neutral que genera resultados discriminatorios.

4.3.1. La prueba de la discriminación algorítmica indirecta

Igual que en el caso de la discriminación directa, la prueba de la discriminación indirecta requiere de la aportación de un elemento de comparación. Puesto que la figura de la discriminación indirecta se centra en el resultado y no tanto en el trato, en ocasiones, tanto el TJUE como el Tribunal Europeo de Derechos Humanos (TEDH) han basado la existencia a primera vista de un caso de discriminación indirecta en datos estadísticos.

Los casos en que se enjuicien las decisiones tomadas por sistemas automatizados, sin duda, comportarán un aumento de la incidencia de la prueba basada en datos estadísticos. El objetivo de estos sistemas es analizar personas en masa y continuamente dar resultados sobre una misma cuestión. Por eso, en principio, será posible disponer de una importante cantidad de ejemplos que aportar como comparación.(50)

Ni el TJUE ni el TEDH han fijado un criterio único sobre qué porcentaje de personas negativamente afectadas por la disposición, criterio o práctica aparentemente neutra debe pertenecer al grupo desaventajado. Tampoco se ha establecido el porcentaje de personas del grupo que deben resultar negativamente afectadas por la medida, en comparación con el porcentaje de personas negativamente afectadas que no pertenecen al grupo para considerar que se da un caso de discriminación indirecta. Sin embargo, el TJUE sí ha indicado que la diferencia debe ser considerable y que el resultado perjudicial debe tener una incidencia de en torno al 80 o 90% para las personas pertenecientes al grupo protegido.

En todo caso, tanto el TJUE como el TEDH tienden a analizar cada situación de manera específica. Así, en el caso de D. H. y otros contra la República Checa,(51) el TEDH consideró que la desproporcionada presencia de menores de etnia romaní en centros escolares para niñas y niños con necesidades especiales constituía una medida indirectamente discriminatoria. En este caso, la presencia de menores romaníes en estas escuelas se encontraba en torno a un 50%. Sin embargo, el tribunal tuvo en cuenta dicho dato en relación con la composición de la población del país, pues únicamente un 2% de las y los menores checos eran de etnia romaní.

Por su parte, la sentencia dictada en el caso Seymour-Smith(52) abre una importante puerta a la reducción de los límites mínimos para considerar la prueba estadística válida. En dicho supuesto, se estableció la posibilidad de apreciar la concurrencia de discriminación “si los datos estadísticos mostraran una diferencia menos importante, pero persistente y relativamente constante durante un largo período de tiempo”, en aquel caso, entre mujeres y hombres trabajadores. Teniendo en cuenta que los algoritmos son generalmente implementados con el objetivo de automatizar procesos que se reproducen una y otra vez, será relativamente fácil obtener una serie longitudinal de resultados producidos por estos sistemas. Es más, una vez que un algoritmo incorpora un sesgo que perjudica a las personas pertenecientes a un grupo desaventajado, salvo que el sistema incorpore instrucciones para corregir estos sesgos, algo que generalmente no sucede, lo habitual es que dicho sesgo se perpetúe durante todo el periodo de funcionamiento del sistema.

Ahora bien, como ya se ha indicado en el caso de la discriminación algorítmica directa, será necesario establecer controles y mecanismos que den validez a los elementos de comparación y series de resultados longitudinales aportados por algoritmos de autoaprendizaje cuyo contenido, razonamiento e instrucciones pueden ir variando.

4.3.2. Igualdad como paridad en la prueba de la discriminación algorítmica indirecta

La prueba estadística de la discriminación algorítmica puede adoptar diversas formas. Por ejemplo, se puede fijar como una medida de la paridad en el grupo.(53) Es decir, de todas las personas candidatas para un puesto de trabajo, ¿a cuántas mujeres selecciona y qué porcentaje de las candidaturas representan? O, de todas las mujeres que se postularon, ¿a qué porcentaje se seleccionó? En este segundo caso cabría comparar dicho resultado con el porcentaje de hombres seleccionados del total que presentó su candidatura.

Ahora bien, estas medidas no son siempre adecuadas, puesto que se centran en el resultado final absoluto y hay determinados ámbitos en los que debe realizarse un análisis ponderado entra la igualdad y otros principios, intereses o derechos. Por ejemplo, si comparamos la presencia de hombres no blancos y hombres extranjeros en las cárceles, en relación con la presencia de hombres blancos nacionales y encontramos que la presencia de los primeros es desproporcionada en relación con el porcentaje de la población que constituyen, podremos detectar que existe un problema.(54) Este problema se puede situar en la discriminación estructural e institucional presente en los sistemas de fuerzas del orden, judicial y penitenciario o en las situaciones de exclusión social y experiencias que suelen compartir las personas migradas y no blancas. Sin embargo, no se puede considerar que un sistema penitenciario es indirectamente discriminatorio siempre que no sea absolutamente representativo de los diferentes segmentos poblacionales. Ello comportaría una construcción e implicaciones absurdas de las nociones de acción afirmativa y de discriminación indirecta.

4.3.3. Igualdad como paridad en la precisión en la prueba de la discriminación algorítmica indirecta

Es por ello que en muchos supuestos de discriminación algorítmica indirecta será más conveniente recurrir a medidas de paridad en la precisión. Esto es, si el algoritmo predice de manera igualmente precisa que personas blancas y no blancas reincidirán, dicho algoritmo no será discriminatorio. Ahora bien, surge un nuevo problema a la hora de decidir cuál sería la medida a emplear para determinar si un algoritmo no cumple con los criterios de paridad en la precisión. Por ejemplo, se podría determinar a través de las tasas de falsos positivos y negativos. En este caso, deberíamos preguntar si la tasa de falsos positivos y falsos negativos es la misma para los diferentes grupos. Otra posibilidad sería calcular si la tasa de error en el cálculo de positivos y negativos de los diferentes grupos se desvía significativamente. También se podría calcular la proporción de falsos positivos a falsos negativos y la proporción de falsos negativos a falsos positivos para cada grupo. Por último, la medida escogida podría calcular la cantidad total de verdaderos positivos y negativos como porcentaje dentro del propio grupo.(55)

No existe una única respuesta de cuál haya de ser la medida más adecuada para determinar la precisión paritaria del algoritmo pero todas ellas ofrecen un elemento probatorio adicional en los casos de discriminación indirecta y, por ello, la posibilidad de examinar la igualdad y no discriminación en ámbitos en los que no basta con demostrar la desigualdad en números absolutos.

4.3.4. El problema de la justificación de la discriminación indirecta

Una de las grandes diferencias en la valoración que reciben los supuestos de discriminación directa e indirecta es el mayor margen que se ofrece a la hora de justificar la segunda. Los supuestos de discriminación directa únicamente pueden justificarse por razones tasadas y objetivas. Sin embargo, en el caso de la discriminación indirecta, se permite la realización de un examen de proporcionalidad a través del cual se ponderen los diferentes intereses en juego.

La justificación de la discriminación indirecta pasa, en primer lugar, por la prueba de que la medida discriminatoria persigue un fin legítimo. En general, el TJUE ha dado por válidos prácticamente todas aquellas finalidades que no constituyan la obtención de un resultado discriminatorio o que escondan el objetivo de discriminar de manera evidente.(56) Por ejemplo, en la sentencia Bilka-Kaufhaus, el Tribunal abrió la posibilidad a justificar una medida que excluía a los trabajadores a tiempo parcial de su plan de pensiones con el fin de incentivar el trabajo a tiempo completo, a pesar de que esta medida afectaba negativamente a muchas más mujeres que hombres.(57) En el mismo orden de ideas, el fallo del TJUE en el caso Achbita estableció que "ha de considerarse legítima la voluntad [del empresario] de seguir un régimen de neutralidad política, filosófica o religiosa en las relaciones con los clientes tanto del sector público como del sector privado”(58) en aplicación del art. 16 de la Carta de derechos fundamentales de la UE, a pesar de que dicho régimen de neutralidad religiosa perjudicaba, de manera evidente, a las mujeres musulmanas, pues no podían portar el hiyab. Por consiguiente, en general, el TJUE ha considerado los intereses económicos como objetivos legítimos válidos dentro del sector privado.

Sí cabe hacer una especial referencia a la consideración de lo que constituyen fines legítimos para el sector público, puesto que el TJUE ha determinado que las consideraciones de carácter presupuestario no pueden, por sí solas, suponer un fin legítimo que ampare una medida indirectamente discriminatoria.(59) Por consiguiente, y aun teniendo en cuenta las mayores exigencias impuestas a los poderes públicos en la justificación de los fines de las medidas discriminatorias, es probable que se considere legítima, cualquier finalidad (lícita) para la que se emplee un algoritmo.

Una vez determinada la concurrencia de una finalidad legítima, los tribunales deben proceder a realizar el test de proporcionalidad de la medida discriminatoria. Este test incorpora la evaluación de la adecuación de la medida a los fines que persigue; su necesidad, esto es, la inexistencia de otra medida menos gravosa que alcance los mismos fines y, por último, el análisis de proporcionalidad en sentido estricto.(60)

La adecuación del algoritmo discriminatorio a los fines que persigue podrá establecerse, en los casos en que se tenga acceso al contenido del algoritmo, a través de la determinación del significado predictivo (o falta de este) de aquellas variables que conducen a resultados discriminatorios. En caso de que se determine que dichas variables no son útiles para predecir la variable objetivo y que, sin embargo, producen resultados discriminatorios, el algoritmo deberá, automáticamente, clasificarse como un sistema que produce discriminación directa.

También podría determinarse la concurrencia de discriminación algorítmica a través de sesgos en la base de datos, debiendo la parte demandada probar si, pese a dichos sesgos, la base de datos es adecuada para predecir la variable objetivo del algoritmo.

Ahora bien, teniendo en cuenta la creciente complejidad y opacidad de los sistemas automatizados y de las bases de datos que los alimentan, es poco probable que puedan llegar a identificarse aquellas variables o los sesgos en las bases de datos que derivan en la producción resultados discriminatorios. Es por ello que resulta más probable que el test de adecuación se realice sobre todo el sistema en su conjunto,(61) debiendo responder a la pregunta: ¿es el algoritmo adecuado para predecir el fenómeno del que se ocupa? La adecuación deberá, pues, medirse a partir de la precisión del sistema.

Con respecto a la necesidad de utilización del sistema discriminatorio, la parte demandada deberá probar que valoró otras posibilidades y mecanismos para la consecución del mismo fin para el que se emplea el algoritmo. Es, sobre todo, de vital importancia que no se acepte una justificación genérica de la necesidad basada en la idea de que, como norma, los algoritmos son menos discriminatorios que los seres humanos y, por tanto, el uso de un sistema automatizado de toma de decisiones implica, de manera automática, la superación del test de necesidad.

Existe una creciente rama del conocimiento dedicada a la creación de sistemas automatizados no discriminatorios.(62) Es por ello que la parte demandada deberá acreditar que valoró el uso de otros sistemas y bases de datos y que no existía un algoritmo menos discriminatorio, ni una base de datos más completa y menos sesgada. Ahora bien, con el objetivo de no imponer costes inasumibles a algunos operadores tecnológicos, deberá exigírseles el uso de sistemas no discriminatorios dentro del criterio de “las mejores técnicas disponibles”, esto es, extrapolando dicha figura aplicada en el ámbito del derecho medioambiental a los riesgos generados por las nuevas tecnologías de procesamiento de datos.(63) Es decir, deberá tenerse en cuenta tanto el estado de la técnica como la capacidad económica de la parte demandada. En este sentido, como se indicará las propuestas finales de este trabajo, debería instituirse un marco europeo de “mejores técnicas disponibles” aplicable al uso de tecnologías de procesamiento de datos y de toma de decisiones automatizadas.

Finalmente, con respecto al test de proporcionalidad en sentido estricto, será sobre todo complicado determinar si, en aquellos casos que podrían englobarse en la categoría de “discriminación estadística precisa”, deben prevalecer los derechos a la igualdad y a la no discriminación de la demandante sobre la libertad y la eficiencia como derechos o intereses de la parte demandada. Sobre todo, debe tenerse en cuenta que, incluso en aquellos casos en que el resultado que perjudica a las personas pertenecientes a grupos desaventajados sea realmente preciso, es decir, que refleje de manera adecuada la realidad, dicha realidad es el producto de la construcción de la sociedad sobre una serie de estructuras de discriminación.(64) Es más, es altamente posible que existan situaciones en las que un algoritmo que produce resultados discriminatorios que, en apariencia, son precisos, también contenga sesgos imperceptibles.(65) Ello no quiere decir que se apliquen criterios de igualdad de resultados estricta en el enjuiciamiento de estos supuestos, sino que se introduzca, como elemento de valoración, la existencia de unas estructuras sociales que, de manera sistemática, discriminan contra las personas pertenecientes a determinados grupos en muchos de los aspectos de sus vidas.

Para la realización de este último examen de proporcionalidad proponemos que se lleve a cabo un análisis de costes y beneficios, evaluando, en el contexto analizado, todos los bienes y derechos en juego. En dicho examen deberá, en todo caso, tenerse en cuenta la capacidad humana para comprender determinados elementos intangibles que no son capturados por las herramientas informáticas.

Cabe realizar una advertencia con respecto a aquellos casos en que la utilización de determinados datos que revelen la pertenencia a un grupo vulnerable sea necesaria. Por ejemplo, en el análisis de la situación económica de una persona para determinar si se le concede un préstamo o no, generalmente se valorará su clase social a través de su situación socioeconómica. En un supuesto como el descrito deberá comprobarse que la diferencia en el resultado obtenido por una persona perteneciente a una clase socioeconómica baja y una persona con mayor capacidad económica y status social no sea desproporcionada. Esto es así, sobre todo si se tiene en cuenta que existe una relación directa entre la pertenencia a determinados grupos protegidos, como minorías étnicas, y la pertenencia a estratos socioeconómicos más bajos.

Asimismo, consideramos conveniente que se impongan mayores requisitos en el respeto a los derechos a la igualdad y no discriminación a las grandes compañías tecnológicas, tanto por su poder económico como por su gran presencia en el mercado, con comportamientos que pueden definirse como monopolísticos, y por la gran influencia que sus sistemas tienen sobre la esfera de la dignidad humana y los derechos fundamentales de las personas.

4.4. Discriminación algorítmica por asociación

La figura de la discriminación por asociación, reconocida por el TJUE en los casos Coleman(66) y Chez(67), abre la puerta a la posibilidad de reconocer como discriminación algorítmica (directa o indirecta) aquellos supuestos en los que el algoritmo no seleccione a las personas por su pertenencia a un grupo desaventajado, sino por su relación con personas del grupo. En este sentido, cabe hacer referencia al sistema empleado por Facebook para excluir del acceso a publicidad sobre venta y alquiler de inmuebles, y otros productos, a personas relacionadas con determinados grupos raciales.

Hasta 2019, la plataforma utilizaba un programa de elaboración de perfiles para ofrecer a los anunciantes la posibilidad de excluir a las minorías étnicas de la visualización de determinados anuncios mediante la inclusión de una opción denominada "afinidades étnicas" en su configuración publicitaria. En la investigación realizada por Angwin y Parris jr.,(68) que se centró en publicidad sobre inmuebles, se determinó que las categorías de afinidades étnicas que podían excluirse eran: personas Afroamericanas, asiáticas-americanas e hispanas, es decir, todas las comunidades no blancas.

Facebook explicó que "afinidades étnicas" no significaba "grupo étnico", sino el interés que un individuo había mostrado en el contenido relacionado específicamente con un determinado grupo étnico.(69) Explicación que no acabó de convencer por cuanto que resultaba bastante evidente que el objetivo era excluir a personas pertenecientes o asociadas a un determinado grupo étnico o racial. Facebook se comprometió a cambiar la configuración de sus anuncios para que no permitieran opciones discriminatorias y, en una declaración pública, indicó que había establecido "instrumentos de aplicación de la ley más sólidos" que señalarían todo anuncio relativo a la vivienda, el empleo o las oportunidades de crédito que discriminara sobre la base de la "afinidad multicultural", ya que era un claro indicador de la raza.(70) Sin embargo, una segunda investigación realizada demostró que Facebook seguía permitiendo que los anuncios de vivienda no se mostraran a personas con ciertas "afinidades multiculturales". Además, se demostró que Facebook también permitía excluir a las personas interesadas en "hombres gays" y "lenguaje de señas".(71)

Finalmente, en marzo de 2019 Facebook introdujo los cambios necesarios para que no fuera posible discriminar sobre la base de la pertenencia a ningún grupo protegido en los anuncios relacionados con el empleo, la vivienda o el crédito.(72)

Este supuesto entraría dentro de la categoría de discriminación por asociación, ofreciendo tanto a las personas pertenecientes al grupo como a las no pertenecientes, pero de alguna manera vinculadas al mismo, la especial protección ofrecida a los derechos a la igualdad y no discriminación cuando estos operan en relación con las categorías sospechosas. Asimismo, este mecanismo ofrece una vía para proteger a aquellas personas que, por ejemplo, no quieran hacer pública su orientación sexual al considerarlas como parte del grupo a proteger por estar relacionadas con aquel y, no, necesariamente, por efectivamente pertenecer al mismo.(73)

En otro orden de cosas, lo que este ejemplo viene a demostrar es que la elaboración de perfiles algorítmicos se está llevando a cabo de manera activa y consciente mediante plataformas digitales y, aunque la decisión final relativa a la discriminación de determinados grupos no se toma mediante algoritmos en este caso, la utilización de herramientas automatizadas al elaborar perfiles de personas que incluyen categorías de datos especialmente protegidos como la etnia, demuestra claramente cómo estas tecnologías ofrecen nuevas formas de agilizar la discriminación y cómo, por el momento, no se están introduciendo consideraciones de igualdad en los entornos digitales.

4.5. Marco jurídico de igualdad sustantiva

Las Directivas Europeas de Igualdad también contienen una serie de preceptos dirigidos a la construcción de un marco de igualdad sustantiva, reconociendo, por ejemplo, la posibilidad de implementar acciones positivas.(74) El fomento de la igualdad entre mujeres y hombres como objetivo general también se encuentra contenido en el Tratado de Funcionamiento de la UE (art. 157.4). Las principales medidas para la realización efectiva del marco jurídico de igualdad sustantiva son las acciones afirmativas, las medidas de fomento de igualdad y el desarrollo de acciones para la generalización de la transversalidad de la igualdad.

En general, el TJUE se ha mostrado reacio a aceptar la introducción de medidas de acción positiva. Por ejemplo, solo ha aceptado que se diese prioridad al grupo desaventajado siempre que se introduzca una cláusula que permita considerar las características específicas concurrentes en las personas pertenecientes al grupo aventajado, otorgando cierta flexibilidad al mandato de priorizar la selección de mujeres. Es decir, no se permite la priorización automática del grupo desaventajado o infrarrepresentado.(75)

La igualdad sustantiva algorítmica ha de construirse sobre la noción de “igualdad en el diseño”, esto es, deben considerarse los distintos elementos que pueden derivar en situaciones de discriminación algorítmica o en usos que contribuyan a perpetuar determinadas estructuras de desigualdad en cada momento de la construcción y desarrollo de los sistemas algorítmicos, y también después de su puesta en funcionamiento.(76) Partiendo de esta premisa, existen varias propuestas relativas al nivel de igualdad al que deberían aspirar los sistemas algorítmicos, así como sobre los mecanismos existentes para su consecución.

Aquellos mecanismos que persiguen una igualdad de resultados total, basados en nociones de paridad estadística, difícilmente podrán superar el examen de aceptabilidad impuesto por el TJUE. Ahora bien, la introducción de determinados elementos que flexibilicen los mandatos de acción afirmativa sí podrían facilitar la aceptación de la acción afirmativa algorítmica. En este sentido, cada vez son más las propuestas dirigidas a introducir acciones afirmativas en el desarrollo de algoritmos cuyo objetivo es evitar generar grandes distorsiones con respecto a los resultados que serían obtenidos sin las modificaciones tendentes a crear algoritmos más igualitarios.(77)

En cualquier caso, si bien resulta relevante la introducción de acciones afirmativas para compensar la desigualdad estructural sufrida por determinados grupos, también es de gran relevancia que se acuda a la raíz del problema y se examinen las bases de datos empleadas en la creación y desarrollo de los algoritmos; las decisiones previas sobre las que pueden aprender estos sistemas, así como las variables y el peso relativo otorgado a cada una de ellas, pues, en muchas ocasiones, los resultados discriminatorios encuentran su origen en la construcción de la sociedad sobre unas estructuras que dan prioridad a los valores y características más comunes en los miembros de grupos que, históricamente, han ocupado el poder.

Finalmente, también pueden y deben emplearse los sistemas automatizados para detectar actitudes, estructuras y situaciones discriminatorias de manera más efectiva con el objetivo de mejorar las actuaciones en materia de lucha contra la discriminación y promoción de la igualdad.

5. DEFICIENCIAS DEL MARCO JURÍDICO DE IGUALDAD Y NO DISCRIMINACIÓN

El marco jurídico europeo en materia de igualdad confiere una protección más específica y extensa en aquellos supuestos previstos en las Directivas de Igualdad. Si bien es cierto que la Carta Europea de Derechos Fundamentales establece una serie de obligaciones a los Estados y, también, hasta cierto punto, a los particulares, en materia de respeto y protección a los derechos a la igualdad y la no discriminación, lo cierto es que el artículo 21 de la Carta deja un considerable margen de actuación en la determinación de las situaciones y forma de protección de estos derechos. Sin embargo, las Directivas de Igualdad incorporan un marco mucho más completo, definiendo, de manera más extensa, no solo aquellas categorías sospechosas, sino también las clases de discriminación y los ámbitos en los que los derechos a la igualdad y a la no discriminación merecen una especial protección. Las Directivas de igualdad constituyen el límite mínimo de protección que los Estados miembros de la UE deben respetar en sus ordenamientos jurídicos internos.

Es por ello que la desigual protección ofrecida por estas Directivas, dependiendo de la categoría sospecha, genera importantes limitaciones en la protección de la igualdad y la no discriminación de la ciudadanía de la Unión. Así, la prohibición de discriminación en el acceso a bienes y servicios se aplica, únicamente, por razón de raza o género y no así por razón de las restantes categorías sospechosas. Asimismo, no se incluye la publicidad en el ámbito de aplicación de la Directiva relativa a la igualdad de hombres y mujeres en el acceso a bienes y servicios. Por su parte, la protección frente a la discriminación por razón de religión, convicciones, edad, orientación sexual y discapacidad únicamente tiene lugar en el ámbito del empleo.

Se limita así la posibilidad de reconducir, por la vía de la publicidad discriminatoria, la perpetuación de estereotipos de género a través de los algoritmos empleados por los motores de búsqueda (principalmente, Google) o la utilización de algoritmos que impidan mostrar publicidad relativa a determinados productos o servicios a cualquier persona perteneciente a un grupo desaventajado, salvo en los casos en los que la exclusión se realice por razón de raza. Asimismo, teniendo en cuenta la especial vulnerabilidad de las personas pertenecientes a estratos socioeconómicos más bajos frente al creciente uso de sistemas automatizados, también resulta especialmente problemático que la clase social no se incluya como categoría especialmente protegida ni en el Convenio Europeo de Derechos Humanos ni en la Carta de los Derechos Fundamentales de la UE y, por supuesto, tampoco en las Directivas.

Entre las deficiencias del sistema europeo de protección de la igualdad y la no discriminación también cabe destacar, sobre todo con referencia al uso de algoritmos, las dificultades derivadas de la necesidad de aportar un elemento de comparación. Por una parte, cabría esperar que la cantidad de situaciones procesadas por un mismo algoritmo pudiera dar lugar a suficientes elementos de comparación. Ahora bien, si los datos referentes a los restantes resultados producidos por el algoritmo se encuentran protegidos por la normativa en materia de protección de datos será más costoso, aunque no imposible, acceder a dichos elementos de comparación. Así, la razón por la que no es imposible es porque, o bien pueden solicitarse dichos datos una vez sean anonimizados, o se pueden realizar experimentos con el programa, introduciendo diferentes perfiles para comparar los resultados entre unos y otros.(78)

Ahora bien, también puede suceder que la constante evolución de los sistemas derive en que no existan dos casos en los que el algoritmo haya funcionado de manera idéntica. En este caso, será más difícil recurrir a la solución de la experimentación con el algoritmo. Es por ello que resulta necesario que los encargados y responsables del procesamiento de datos tengan y cumplan con la obligación de guardar una copia de cada versión del programa.

También cabe destacar que, si bien es cierto que la posibilidad de emplear pruebas estadísticas en los supuestos de discriminación podría aumentar las posibilidades de acreditar la existencia de vulneraciones a los derechos a la igualdad y a la no discriminación, la dificultad de comprender el contenido de los sistemas también impide que el propio sistema se pueda considerar discriminatorio de plano, sin atender a elementos de comparación. Por ejemplo, en un supuesto en el que había una única mujer candidata a un ascenso y fue rechazada por estar embarazada, el TJUE consideró que se trataba de un supuesto de discriminación directa por razón de sexo puesto que el rechazo a una persona para un puesto de trabajo por el hecho de estar embarazada solo se puede dar en los casos en que la persona candidata sea mujer.(79) Esta consideración difícilmente podrá darse en un caso en que la decisión la tome un algoritmo a cuyo contenido no se pueda acceder.

Asimismo, la falta de consideración de la discriminación estructural como elemento de análisis en los casos de discriminación también supone una importante limitación en la protección efectiva de los derechos a la igualdad y no discriminación.(80) Esta limitación resulta especialmente relevante en el caso de la discriminación algorítmica por cuanto la discriminación estructural, como categoría analítica permite entender que, incluso en los casos en los que la discriminación es aparentemente precisa, esta es el resultado de una sociedad que, de manera sistemática, sitúa a las personas pertenecientes a determinados grupos en una posición de desventaja. Por tanto, si no se corrigen estas situaciones de discriminación aparentemente eficiente, no se corregirán las estructuras que sitúan en un punto de partida desigual a las personas pertenecientes a grupos desaventajados.

Cabe también destacar la poca consideración otorgada a los supuestos de discriminación interseccional, también conocida como discriminación múltiple. Las personas pertenecientes a más de un grupo desaventajado pueden ser y son discriminadas por razones específicas que se pueden diferenciar de aquellas situaciones de discriminación basadas en una única categoría sospechosa. En este sentido, la discriminación sufrida por una mujer migrada no es equivalente ni a la discriminación sufrida por los hombres migrados ni a la discriminación sufrida por las mujeres nacionales de un Estado. La necesidad de prestar atención a esta clase de discriminación deviene, si cabe, más acuciante como consecuencia del creciente uso de sistemas automatizados. La cantidad de datos cruzados por los sistemas algorítmicos implica un aumento de la personalización de los resultados y, por tanto, un aumento de las respuestas específicas dadas a aquellas personas en las que concurran varias categorías que las hagan especialmente vulnerables. Es por ello, que la realidad de la discriminación interseccional y la forma en la que esta se refleja en la discriminación algorítmica, debe ser abordada. En este sentido, el TEDH ha realizado una importante labor en el reconocimiento progresivo de las situaciones de discriminación que afectan de manera específica a aquellas personas sobre las cuales se toman decisiones con base en la concurrencia en ellas de dos o más categorías sospechosas.

Por ejemplo, en el caso Carvalho Pinto, el TEDH estableció lo siguiente:

“La cuestión que se plantea aquí no es la consideración de la edad o el sexo como tales, sino más bien la suposición de que la sexualidad no es tan importante para una mujer de cincuenta años y madre de dos hijos como para alguien de menor edad. Esa suposición refleja la idea tradicional de que la sexualidad femenina está esencialmente vinculada a los fines de la procreación y, por lo tanto, no tiene en cuenta su importancia física y psicológica para la realización personal de las mujeres como personas.”(81)

Por último, el sistema europeo de reconocimiento y protección de los derechos a la igualdad y a la no discriminación adolece de importantes deficiencias que dificultan la efectiva aplicación de los mecanismos tendentes a salvaguardar los derechos que nos ocupan. En este sentido, cabe destacar que, si bien existe una red de instituciones dedicadas a la protección de la igualdad, estas se ocupan, principalmente, de realizar actuaciones de investigación y no siempre tienen suficiente capacidad para controlar el respeto a los derechos a la igualdad y a la no discriminación.(82)

Asimismo, en muchas ocasiones el derecho de acceso a la justicia se ve condicionado tanto por las propias limitaciones derivadas de los costes económicos y burocrático-administrativos de los procesos de protección de los derechos a la igualdad y no discriminación,(83) como por el hecho de que las víctimas de las situaciones de discriminación en muchas ocasiones no son tan siquiera conscientes de que sus derechos están siendo vulnerados. Por ejemplo, la víctima de discriminación en un proceso de selección de personal llevado a cabo por un algoritmo, o a quien se le ha denegado un préstamo por un sistema automatizado que basa su decisión en una categoría sospechosa, difícilmente serán conscientes de las razones verdaderas por las que no se les contrata o se les deniega un préstamo, especialmente si no tienen acceso o conocimiento de otras personas que hayan participado en el mismo proceso.

A mayor abundamiento, la práctica inexistencia de la adopción de acciones colectivas en materia de igualdad y no discriminación en Europa también supone un importante impedimento a la efectiva protección de estos derechos, puesto que estas acciones otorgan a las víctimas de discriminación una red y mecanismos de apoyo que facilitan la realización de todos los trámites burocráticos y reducen el coste económico de la defensa de sus derechos.(84)

III. EL MARCO JURÍDICO EN MATERIA DE PROTECCIÓN DE DATOS

1. El marco jurídico en materia de protección de datos para prevenir y responder de manera conjunta frente a los diferentes riesgos generados por el uso de algoritmos

Como ya se ha indicado anteriormente, la creciente capacidad computacional de las tecnologías de procesamiento de datos y de automatización de decisiones genera una serie de riesgos para los derechos fundamentales de las personas, así como para los valores propios de los Estados democráticos de Derecho, que no se limitan, exclusivamente, a la esfera de la igualdad y no discriminación. Todos esos riesgos y daños se encuentran íntimamente relacionados entre sí. Hasta la fecha, el marco jurídico específicamente dirigido a lidiar y controlar, de manera conjunta, con los indicados riesgos y daños, viene dado por la normativa en materia de protección de datos. El RGPD y, en menor medida, la Directiva 2016/680,(85) establecen un sistema que puede denominarse de gobernanza colaborativa o co-regulación, en el que se incluyen preceptos estructurados como mandatos y otros como meras recomendaciones o que precisan la cooperación de los responsables y encargados del tratamiento de datos para su efectividad.

Es lógico que el marco jurídico dirigido a proteger frente a los riesgos causados por las tecnologías de procesamiento de datos y la automatización de procesos parta de la protección de datos personales, estrechamente relacionada con la protección de la intimidad. Los daños causados por estos sistemas son, principalmente, el resultado de la recogida de datos de carácter personal y muchos de sus efectos tienen lugar en la esfera personal de aquellos individuos cuyos datos han sido recogidos y procesados.

También por esta razón, podría caerse en el error de considerar que las reglas y normas establecidas por el ordenamiento jurídico privado deberían ser suficientes para gestionar los conflictos surgidos en relación con el procesamiento de datos, la creación de perfiles y la toma de decisiones automatizadas. Sin embargo, sin entrar a valorar el uso de estos sistemas por los poderes públicos, también cuando los responsables y encargados del tratamiento operan en el sector privado, los daños causados y riesgos que se originan tienen efectos más allá de la configuración tradicional de relaciones jurídicas entre personas privadas. Así, no son pocas las ocasiones en que las personas afectados por el procesamiento de datos no han compartido su información personal, sino que dichos datos han sido recopilados a través de los perfiles o cuentas en plataformas digitales de terceras personas. O, incluso, cuando hay posibilidades de ejercicio de poder público, son el resultado del cruce de bases de datos que las Administraciones públicas tienen sobre los ciudadanos y que han sido recopilados en el ejercicio de funciones públicas. (86)