Juli Ponce Solé

Inteligencia artificial, Derecho administrativo y reserva de humanidad: algoritmos y procedimiento administrativo debido tecnológico

El estudio analiza el uso de la inteligencia artificial por las Administraciones Públicas para la toma de decisiones automatizadas y semi-automatizadas. Partiendo de la situación existente en España y teniendo en cuenta las preocupaciones y regulaciones a nivel internacional, el análisis sugiere una mejora del marco regulador de la actividad automatizada, estableciendo una reserva para humanos en el ejercicio de potestades discrecionales debido a la necesidad de empatía para la realización de la ponderación con criterios extrajurídicos en que consiste la discrecionalidad. Asimismo, el estudio plantea una lucha contra la opacidad de los algoritmos en garantía del derecho a una buena administración de los ciudadanos, especialmente en su vertiente del derecho a comprender las decisiones administrativas.

Juli Ponce Solé es Catedrático de Derecho Administrativo en la Universidad de Barcelona

El artículo se publicó en el número 50 de la Revista General de Derecho Administrativo (Iustel, enero 2019)

I. INTRODUCCIÓN. INTELIGENCIA ARTIFICIAL, BIG DATA Y ALGORITMOS Y SU CRECIENTE USO EN EL SECTOR PRIVADO Y PÚBLICO. LA ACTIVIDAD ADMINISTRATIVA AUTOMATIZADA (1)

Es casi un lugar común referirse a que está en marcha desde hace años una cuarta revolución industrial, que, sin duda, está teniendo, y va a tener, profundos impactos en las personas, la sociedad y el Derecho, en la línea de los que generaron las revoluciones científicas y humanas de los siglos XVIII y XIX que dieron lugar al nacimiento del Derecho Administrativo, de cuyos paradigmas básicos aún seguimos viviendo en gran medida.

A lo largo de este estudio vamos a intentar pergeñar algunas ideas básicas sobre cómo la Inteligencia Artificial (en adelante, IA) va a impactar en el Derecho administrativo y cómo éste debería adaptarse para poder potenciar sus ventajas y controlar sus efectos menos beneficiosos. Cabe señalar, por cierto, que la relación entre los ordenadores y el Derecho Administrativo no es extraña a nuestra doctrina, entre la que podemos destacar un curioso y breve trabajo del profesor Tomás-Ramón Fernández en 1971 cuya lectura actual es deliciosa(2).

De vez en cuando, volveremos la vista a los pensadores y juristas ilustrados y del siglo XIX, los cuales, salvando las distancias, se enfrentaron también a enormes cambios tecnológicos y sociales en su época. Así, en ese sentido, se puede citar, por ejemplo, al jurista francés JOSSERAND, quién, al referirse al desarrollo de la industria y sus consecuencias dañosas, señalaba hace más de un siglo que (las cursivas son nuestras):

“Porque la industria se mejora se transforma, es que los accidentes ocasionados o el hecho de las cosas inanimadas se tornan más numerosas, mucho más terribles y también mucho más obscuras. La injusticia del sistema tradicional de responsabilidad se ve claramente. En la inmensa mayoría de los casos, las víctimas se encuentran con la imposibilidad de reconstruir la génesis del accidente, de descubrir por qué y de demostrar la culpa del patrón de la gran industria, del conductor, etc.”(3).

Sin duda, la revolución tecnológica en marcha en este siglo XXI va a hacer que las cosas inanimadas se tornen más numerosas, y está por ver si mucho más terribles y obscuras. En su limitado pero importante papel, el Derecho deberá, entendemos, intentar evitarlo. Pero el Derecho no podrá hacerlo sólo, porque aquí la importancia de la transdisciplinariedad deviene crucial, como señala la Comunicación de 2018 de la Comisión al Parlamento Europeo, al Consejo Europeo, al Consejo, al Comité Económico y Social Europeo y al Comité de la Regiones, titulada Inteligencia artificial para Europa (y a la que citaremos a partir de ahora como la Comunicación de 2018)(4):

“También es necesario impulsar la interdisciplinariedad (fomentando que se oferten titulaciones conjuntas, como, por ejemplo, en Derecho o psicología e IA)”

Ello significará romper con una manera de proceder actual, que, por lo menos, puede retrotraerse a la Prusia de principios del siglo XIX - tras la derrota de Jena ante las tropas napoleónicas-, como nueva estrategia militar para obtener soldados más obedientes(5). La misma es bien conocida y consiste en dividir el conocimiento en compartimientos o silos. Sólo si superamos esa falta de transdisciplinariedad el Derecho podrá hacer frente a los retos en este ámbito y en otros(6).

Hay que advertir que este trabajo se va a centrar en el uso de la IA para desarrollar actividad administrativa y adoptar decisiones administrativas, no, pues, en la regulación administrativa del uso de la IA por sujetos privados (aspecto éste de gran importancia y donde técnicas de mejora regulatoria como las sandbox o las normativas experimentales deberán cobrar relevancia en el futuro). Sí, en cambio, realizaremos algunas reflexiones sobre el uso de IA por parte de aquéllos privados que desarrollan funciones públicas o prestan servicios de interés general.

Tampoco se ocupará este estudio específicamente del uso de la IA para detectar la mala administración y la corrupción administrativa, aspecto específico éste al que ya dedicamos atención en su momento(7) , y que tiene en la Ley valenciana 22/2018, de 6 de noviembre, de Inspección General de Servicios y del sistema de alertas para la prevención de malas prácticas en la Administración de la Generalitat y su sector público instrumental (BOE 30/11/2018), su expresión legal más lograda en España, hasta el momento(8).

La Comunicación de 2018 mencionada llama la atención sobre la realidad de la IA y establece una analogía, en la línea de lo antes expuesto, entre anteriores revoluciones y la situación actual:

“Lejos de ser ciencia-ficción, la inteligencia artificial (IA) forma ya parte de nuestras vidas. En la utilización de un asistente personal para organizar nuestra jornada laboral, en el desplazamiento en un vehículo de conducción automática o en las canciones o restaurantes sugeridos por nuestros teléfonos, la IA se hace realidad. La IA, además de facilitarnos la vida, nos está ayudando a resolver algunos de los principales retos a los que se enfrenta nuestro mundo: desde el tratamiento de las enfermedades crónicas o la reducción de las tasas de mortalidad en los accidentes de tráfico hasta la lucha contra el cambio climático o la previsión de las amenazas a la ciberseguridad () Al igual que hicieran la máquina de vapor o la electricidad en épocas anteriores, la IA está transformando nuestro mundo, nuestra sociedad y nuestra industria”.

La importancia que está adquiriendo la IA es especialmente visible en las Administraciones Públicas de otros Estados, como veremos, donde el uso del Big Data(9) y de la IA permite intentar mejorar sus políticas públicas y sus decisiones administrativas y avanzar, en definitiva, hacia el buen gobierno y la buena administración. Decisiones administrativas sobre determinadas prestaciones sociales, acceso a las fronteras nacionales o desarrollo de ciertas políticas públicas, entre otras, están apoyándose crecientemente en la IA(10).

En España el uso de la IA en general, y en las Administraciones Públicos, en particular, ya no es una entelequia tampoco, más allá de la ley valenciana aludida. Así, destaca la creación por el Ayuntamiento de Barcelona de la Oficina Municipal de Datos(11). En el ámbito estatal, como señala la Resolución de 8 de enero de 2018, de la Dirección General de la Agencia Estatal de Administración Tributaria, por la que se aprueban las directrices generales del Plan Anual de Control Tributario y Aduanero de 2018 (publicado en el BOE 23 de enero 2018):

"Para mejorar la eficacia del uso de la información de que dispone la Agencia Tributaria se utilizarán nuevas técnicas de análisis de datos. Se desarrollarán nuevos modelos de detección de fraude basados tanto en técnicas analíticas como en el análisis de redes mediante técnicas de <<big data>> . Todo esto permitirá el desarrollo de mecanismos de análisis más complejos que los utilizados hasta ahora, facilitando a los órganos de control la detección de patrones de conducta que puedan poner de manifiesto inconsistencias en los datos relacionados con los contribuyentes y que puedan servir como claros indicadores de la existencia de riesgos fiscales que es necesario combatir por parte de la Administración”."

Asimismo, es posible hallar otros ejemplos en el mismo ámbito tributario(12) y también en el de la Seguridad social(13). Sin embargo, a tenor de los datos disponibles actualmente, las Administraciones Públicas españolas aún no han comprendido el impresionante salto para el buen gobierno y la buena administración que puede suponer el uso de la IA. En un estudio realizado en 2017, solo un pequeño porcentaje mostraba algún interés por el Big Data, declarando la mayoría, más del 60%, su desinterés por el mismo(14). Es de esperar que estos datos irán cambiando con el transcurso del tiempo.

Para finalizar este apartado introductorio conviene recordar, de forma sucinta, el significado de conceptos a los que ya hemos aludido hasta ahora, y que continuaremos empleando a lo largo del estudio, como son los de IA, Big Data y algoritmos.

El término inteligencia artificial, de acuerdo, por ejemplo, con la Comunicación de 2018, se aplica a los sistemas que manifiestan un comportamiento inteligente, pues son capaces de analizar su entorno y pasar a la acción, con cierto grado de autonomía, con el fin de alcanzar objetivos específicos. Estos sistemas pueden consistir en un simple programa informático (por ejemplo, motores de búsqueda o sistemas de reconocimiento facial o de voz) pero también pueden estar incorporados en dispositivos de hardware (como robots o automóviles autónomos).

La IA se desarrolla mediante el uso de algoritmos y datos. En la cocina de la IA, los primeros serían las recetas y los segundos los ingredientes.

Los algoritmos son un conjunto de instrucciones para solucionar un problema. Los mismos han ido haciéndose más complejos con el tiempo, pasando de ser estáticos, en el sentido de que los programadores diseñaban ya en los mismos los criterios para tomar las decisiones, a ser dinámicos, en el sentido de que los algoritmos denominados de aprendizaje automático (machine learning) tienen la capacidad de aprender con el tiempo de los datos y experiencias para tomar decisiones por sí mismos, generando sus propias instrucciones que ya no son las iniciales del programador. Por otro lado, el llamado aprendizaje profundo (deep learning) supone un funcionamiento de la IA emulando redes neuronales complejas. En estos casos, los algoritmos extraen patrones de las masas de datos y los resultados que se obtienen no están relacionados de modo lineal sino complejo, por lo que no es sencillo determinar la causalidad entre datos y decisión adoptada.

Por ello, ha sido dicho que en un medio ambiente de aprendizaje automático el problema con estos algoritmos es que los humanos no pueden ya estar en control de qué decisión es tomada y ni siquiera pueden saber o comprender por qué una decisión errónea ha sido tomada dado que están perdiendo de vista la transparencia del proceso desde el principio hasta el final, deviniendo opacos para sus creadores que no entienden la lógica que siguen. De ahí que se hable del proceso de adopción de la decisión por parte de los algoritmos como una caja negra (black box)(15).

Una definición de algoritmo incluida en un documento jurídico en el Estado español es posible hallarla en diversos dictámenes de la Comisión de Garantía del derecho de acceso a la información pública de Cataluña. Así, la Resolución de la Reclamación 123/2016 señala que (la traducción del catalán es nuestra):

“Un algoritmo, como “procedimiento de cálculo que consiste en cumplir un conjunto ordenado y finito de instrucciones con unos datos especificados para llegar a la solución del problema planteado” o “conjunto finito de reglas que, aplicadas de manera ordenada, permiten la resolución sistemática de un problema, el cual se utiliza como punto de partida en programación informática” (en las dos definiciones que da el Termcat aplicables a este caso), no deja de ser un tipo de información, expresado habitualmente en lenguaje matemático o informático (a pesar de que los algoritmos también se pueden expresar de otras muchas maneras, incluyendo los diagramas de flujo, el pseudocódigo y el propio lenguaje natural)”.

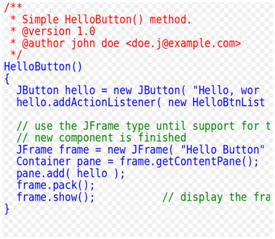

Efectivamente, un algoritmo puede expresarse en lenguaje natural, en diagramas de flujo o en pseudocódigos. Para no tratar estos conceptos, inusuales para juristas, de forma excesivamente abstracta, creemos relevante dedicarles algunos breves ejemplos y figuras gráficas que ayuden en la explicación y comprensión.

Pensemos en un sencillo ejemplo de algoritmo, el consistente en el cálculo del resultado de la suma de dos números.

En lenguaje natural lo expresaríamos así:

1.- Inicio 2.- Asignar a la variable x el valor del primer número 3.- Asignar a la variable y el valor del segundo número 4.- Realizar la suma: x + y, y el resultado se guarda en la variable z 5.- Fin

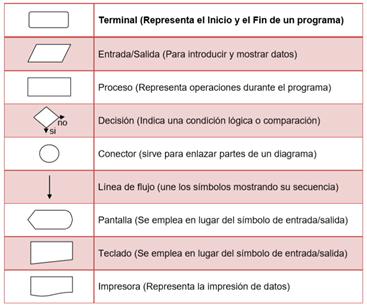

En el caso de los diagramas de flujo, se suele recomendar la representación de algoritmos mediante los mismos antes de traducirlo a lenguaje de programación. Los símbolos más comunes son los que se incluyen en la figura 1:

Figura 1(16)

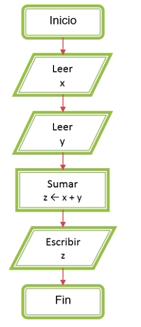

. En diagrama de flujos, el algoritmo sugerido como ejemplo se representaría así:

Figura 2

Por otro lado, un pseudocódigo es un lenguaje de descripción de algoritmos. Sirve para facilitar el proceso de codificación, es decir, la escritura del código fuente. Se le considera un borrador (código de prueba) ya que su estructura es muy similar a la empleada en la mayoría de los lenguajes de programación.

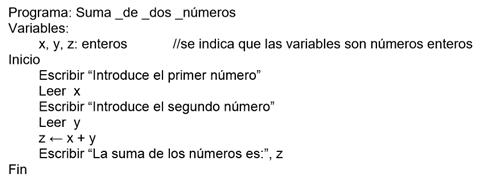

El algoritmo en pseudocódigo que permite realizar la suma de dos números de nuestro ejemplo es el siguiente(17):

Con el uso de pseudocódigo se consigue evitar errores en la elaboración del posterior código fuente.

Éste, viene definido y distinguido del algoritmo por la Comisión de Garantía del derecho de acceso a la información pública de Cataluña en su ya aludida Resolución de la Reclamación 123/2016 (la traducción del catalán es nuestra):

“A los efectos de la resolución de esta reclamación es importante distinguir el algoritmo matemático, que es aquello que solicita la persona reclamante, del código fuente del programa informático que lo implementa. Cómo se ha señalado, el algoritmo, como conjunto de pasos que se tienen que seguir para resolver adecuadamente el problema planteado, puede ser expresado en palabras (lenguaje natural), como hace el Consejo a las explicaciones dadas a esta Comisión, o, para mayor precisión (para evitar las ambigüedades del lenguaje natural), en lenguaje matemático. En los casos en que, como sucede en la designación de los tribunales correctores de las PAU [Pruebas de Acceso a la Universidad], la aplicación del algoritmo es compleja atendido el gran número de variables existentes (miles de candidatos presentados, gran número de materias y de sedes, porcentajes mínimos requeridos de hombres, mujeres, de profesores universitarios y de bachillerato –cada uno de ellos con preferencias diversas de sedes y materias–, prioridad de los candidatos que tengan asignado un número más próximo al número semilla extraído por sorteo –salvo los presidentes y subcoordinadores, que son designados directamente–, necesidades de profesorado que varían cada año en función del número de alumnos), y donde resulta necesario utilizar la potencia de cálculo de una computadora, hay que traducir este algoritmo matemático a lenguaje informático para que la computadora (mediante el programa informático correspondiente) lo pueda entender e implementar debidamente. El código fuente sería el conjunto de instrucciones escritas –en el lenguaje de programación que corresponda– del programa informático empleado para implementar el algoritmo. De la solicitud se desprende que la persona reclamante no quiere acceder al código fuente del programa informático empleado por el Consejo Interuniversitario para designar los miembros de los tribunales correctores de las PAU, sino a “el algoritmo matemático que condiciona la orden de posiciones en los tribunales correctores de las PAU a partir de la semilla extraída por sorteo”.”

Como ejemplo, véase aquí una ilustración de código fuente Java, con comentarios prólogo indicados en rojo, comentarios en línea indicados en verde, y sentencias de programa indicadas en azul:

Figura 3

Como ha sido señalado, “Un ordenador no procesa lenguaje natural sino que su funcionamiento se basa en ejecutar un software escrito en un lenguaje de programación, que es una variedad de los lenguajes formales. El software se escribe en un lenguaje comprensible para el ser humano, quien puede leerlo y transformarlo, y el texto resultante se denomina código fuente”. Pero “para que la máquina pueda ejecutarlo se necesita compilarlo, esto es, crear una lista de unos y ceros que pueda ser leído por la máquina, lo que se denomina código binario”(18)

Pero, además, para que los algoritmos funcionen, necesitan ingentes cantidades de datos o big data, datos masivos caracterizados por su volumen, variedad y velocidad, las llamadas tres v(19).

La IA llevada al campo de las Administraciones Públicas, como decíamos, puede ayudar al procesamiento rápido de ingentes cantidades de datos y a la toma de decisiones, luego veremos de qué tipo, mejor fundadas y respaldadas por dichos datos. En ese sentido, la actividad administrativa automatizada es definida por el anexo de la Ley 11/2007, de 22 de junio, de acceso electrónico de los ciudadanos a los Servicios Públicos, como toda actuación administrativa producida por un sistema de información adecuadamente programado sin necesidad de intervención de una persona física en cada caso singular. Incluye la producción de actos de trámite o resolutorios de procedimientos, así como de meros actos de comunicación(20).

II. REGULACIÓN DE LA TOMA DE DECISIONES ADMINISTRATIVAS AUTOMATIZADAS

En un Estado de Derecho, es obvio que la regulación de la IA, en general, y, por lo que nos interesa aquí, de la toma de decisiones administrativas automatizadas debería tener un importante papel, asumiendo, como hacemos aquí, que la misma encuentra acomodo en las categorías clásicas de órgano administrativo y acto administrativo.

En ese sentido, disentimos de PARADA cuando señala que no sería posible considerar resolución administrativa la adoptada de forma automatizada, porque las máquinas carecen de voluntad: “los actos administrativos son manifestaciones de voluntad y las máquinas, al no tenerla, carecen de posibilidad de producir actos jurídicos y lo que reflejan no es más que el resultado de los datos y programas que se introducen en ellas, por lo que la producción jurídica sigue estando referida a los funcionarios y autoridades que se sirven de aquéllas”(21). Siguiendo, entre otros, a MARTIN DELGADO (2009, 366): “toda persona jurídica —también la Administración— necesita con carácter general de personas físicas que realicen materialmente las actuaciones que pueden-deben llevar a cabo. Esa actividad material, y aquí radica la novedad, puede ser actualmente desarrollada por un ordenador en ejecución de una aplicación informática específicamente creada y configurada para ello. Pero esto es irrelevante para la teoría del órgano, pues la actuación se sigue imputando al órgano que tiene encomendada la competencia, que es además quien firma el acto; y también lo es para la concepción del acto administrativo, pues su contenido puede ser el mismo. La única diferencia radica en que la conexión no tiene lugar a través de la intervención directa del titular del órgano, sino mediante el empleo de un sistema de firma”.(22) En esa línea se sitúa la ley catalana 26/2010, de 3 de agosto, de régimen jurídico y de procedimiento de las administraciones públicas de Cataluña, cuando señala en su art. 44.3 que “la actuación administrativa automatizada no afecta a la titularidad de la competencia de los órganos administrativos ni a las competencias atribuidas para la resolución de los recursos administratives”

2.1 Situación internacional y en la UE: el Reglamento General de Protección de Datos de la UE y la Ley Orgánica de Protección de Datos Personales y garantía de los derechos digitales de 2018

En el nivel internacional en cuanto a cómo debiera ser la regulación de la IA, la Association for Computing Machinery ha establecido en 2017 unos principios que deberían orientar dicha regulación, en concreto 7, que son los de 1. Conciencia; 2. Acceso y corrección;3. Responsabilidad;4. Explicación;5. Procedencia de los datos;6. Auditoría;7. Validación y testeo(23).

En el ámbito de la Unión Europea, aparte de numerosos documentos sobre el tema, como la comunicación de 2018 aludida, el Reglamento General de Protección de Datos (Reglamento UE 2016/679), desde esta perspectiva, importante pero limitada, ha establecido algunas regulaciones de la IA en la toma de decisiones administrativas. Así, en sus artículos 13 (Información que deberá facilitarse cuando los datos personales se obtengan del interesado), 14 (Información que deberá facilitarse cuando los datos personales no se hayan obtenido del interesado) y 15 (Derecho de acceso del interesado) encontramos referencias de interés, sobre todo en este último:

“la existencia de decisiones automatizas, incluida la elaboración de perfiles, a que se refiere el artículo 22, apartados 1 y 4, y, al menos en tales casos, información significativa sobre la lógica aplicada, así como la importancia y las consecuencias previstas de dicho tratamiento para el interesado”

De gran interés es también el artículo 22:

“Artículo 22

Decisiones individuales automatizadas, incluida la elaboración de perfiles

1. Todo interesado tendrá derecho a no ser objeto de una decisión basada únicamente en el tratamiento automatizado, incluida la elaboración de perfiles, que produzca efectos jurídicos en él o le afecte significativamente de modo similar.

2. El apartado 1 no se aplicará si la decisión:

a) es necesaria para la celebración o la ejecución de un contrato entre el interesado y un responsable del tratamiento;

b) está autorizada por el Derecho de la Unión o de los Estados miembros que se aplique al responsable del tratamiento y que establezca asimismo medidas adecuadas para salvaguardar los derechos y libertades y los intereses legítimos del interesado, o

c) se basa en el consentimiento explícito del interesado.

3. En los casos a que se refiere el apartado 2, letras a) y c), el responsable del tratamiento adoptará las medidas adecuadas para salvaguardar los derechos y libertades y los intereses legítimos del interesado, como mínimo el derecho a obtener intervención humana por parte del responsable, a expresar su punto de vista y a impugnar la decisión.

4. Las decisiones a que se refiere el apartado 2 no se basarán en las categorías especiales de datos personales contempladas en el artículo 9, apartado 1, salvo que se aplique el artículo 9, apartado 2, letra a) o g), y se hayan tomado medidas adecuadas para salvaguardar los derechos y libertades y los intereses legítimos del interesado”

Por su parte, en España la Ley Orgánica 3/2018, de 5 de diciembre, de Protección de Datos Personales y garantía de los derechos digitales, señala que:

“Artículo 11. Transparencia e información al afectado.

1. Cuando los datos personales sean obtenidos del afectado el responsable del tratamiento podrá dar cumplimiento al deber de información establecido en el artículo 13 del Reglamento (UE) 2016/679 facilitando al afectado la información básica a la que se refiere el apartado siguiente e indicándole una dirección electrónica u otro medio que permita acceder de forma sencilla e inmediata a la restante información.

2. La información básica a la que se refiere el apartado anterior deberá contener, al menos:

a) La identidad del responsable del tratamiento y de su representante, en su caso.

b) La finalidad del tratamiento.

c) La posibilidad de ejercer los derechos establecidos en los artículos 15 a 22 del Reglamento (UE) 2016/679.

Si los datos obtenidos del afectado fueran a ser tratados para la elaboración de perfiles, la información básica comprenderá asimismo esta circunstancia. En este caso, el afectado deberá ser informado de su derecho a oponerse a la adopción de decisiones individuales automatizadas que produzcan efectos jurídicos sobre él o le afecten significativamente de modo similar, cuando concurra este derecho de acuerdo con lo previsto en el artículo 22 del Reglamento (UE) 2016/679.

3. Cuando los datos personales no hubieran sido obtenidos del afectado, el responsable podrá dar cumplimiento al deber de información establecido en el artículo 14 del Reglamento (UE) 2016/679 facilitando a aquél la información básica señalada en el apartado anterior, indicándole una dirección electrónica u otro medio que permita acceder de forma sencilla e inmediata a la restante información. En estos supuestos, la información básica incluirá también:

a) Las categorías de datos objeto de tratamiento.

b) Las fuentes de las que procedieran los datos.”

2.2 Las lagunas de leyes 39 y 40/2015 y de la LTAIBG de 2013 en relación a las decisiones automatizadas

Referencias a la actividad administrativa automatizada pueden hallarse en la Ley 58/2003, de 17 de diciembre, General Tributaria (en adelante, LGT), que en su artículo 96 –bajo el título de “Utilización de tecnologías informáticas y telemáticas”– se refiere al empleo por parte de la Administración tributaria de las nuevas tecnologías en el desarrollo de su actividad:

“Artículo 96. Utilización de tecnologías informáticas y telemáticas.

1. La Administración tributaria promoverá la utilización de las técnicas y medios electrónicos, informáticos y telemáticos necesarios para el desarrollo de su actividad y el ejercicio de sus competencias, con las limitaciones que la Constitución y las leyes establezcan.

2. Cuando sea compatible con los medios técnicos de que disponga la Administración tributaria, los ciudadanos podrán relacionarse con ella para ejercer sus derechos y cumplir con sus obligaciones a través de técnicas y medios electrónicos, informáticos o telemáticos con las garantías y requisitos previstos en cada procedimiento.

3. Los procedimientos y actuaciones en los que se utilicen técnicas y medios electrónicos, informáticos y telemáticos garantizarán la identificación de la Administración tributaria actuante y el ejercicio de su competencia. Además, cuando la Administración tributaria actúe de forma automatizada se garantizará la identificación de los órganos competentes para la programación y supervisión del sistema de información y de los órganos competentes para resolver los recursos que puedan interponerse.

4. Los programas y aplicaciones electrónicos, informáticos y telemáticos que vayan a ser utilizados por la Administración tributaria para el ejercicio de sus potestades habrán de ser previamente aprobados por ésta en la forma que se determine reglamentariamente.

5. Los documentos emitidos, cualquiera que sea su soporte, por medios electrónicos, informáticos o telemáticos por la Administración tributaria, o los que ésta emita como copias de originales almacenados por estos mismos medios, así como las imágenes electrónicas de los documentos originales o sus copias, tendrán la misma validez y eficacia que los documentos originales, siempre que quede garantizada su autenticidad, integridad y conservación y, en su caso, la recepción por el interesado, así como el cumplimiento de las garantías y requisitos exigidos por la normativa aplicable.”

Por su parte, con posterioridad la Ley 11/2007, de 22 de junio, de acceso electrónico de los ciudadanos a los Servicios Públicos, además de algunas breves menciones en conexión con los sistemas de firma electrónica, se ocupa en dos artículos y en su anexo de la actividad administrativa automatizada:

“Artículo 38. Terminación de los procedimientos por medios electrónicos.

2. Podrán adoptarse y notificarse resoluciones de forma automatizada en aquellos procedimientos en los que así esté previsto.

Artículo 39. Actuación administrativa automatizada.

En caso de actuación automatizada deberá establecerse previamente el órgano u órganos competentes, según los casos, para la definición de las especificaciones, programación, mantenimiento, supervisión y control de calidad y, en su caso, auditoría del sistema de información y de su código fuente. Asimismo, se indicará el órgano que debe ser considerado responsable a efectos de impugnación.”

El anexo de la ley contiene una definición de actividad automatizada, como ya nos consta:

“a) Actuación administrativa automatizada: actuación administrativa producida por un sistema de información adecuadamente programado sin necesidad de intervención de una persona física en cada caso singular. Incluye la producción de actos de trámite o resolutorios de procedimientos, así como de meros actos de comunicación.”

Además de esta regulación hay que tener en cuenta la que se encuentra actualmente en los arts. 40 y 41 de la ley 40/2015, que son de aplicación a todas las AAPP, de acuerdo con las bases del régimen jurídico de las AA.PP., art. 149.1.18 CE, que es usada como fundamento competencial por la DF 14ª de la ley:

“Artículo 41. Actuación administrativa automatizada.

1. Se entiende por actuación administrativa automatizada, cualquier acto o actuación realizada íntegramente a través de medios electrónicos por una Administración Pública en el marco de un procedimiento administrativo y en la que no haya intervenido de forma directa un empleado público.

2. En caso de actuación administrativa automatizada deberá establecerse previamente el órgano u órganos competentes, según los casos, para la definición de las especificaciones, programación, mantenimiento, supervisión y control de calidad y, en su caso, auditoría del sistema de información y de su código fuente. Asimismo, se indicará el órgano que debe ser considerado responsable a efectos de impugnación.

Artículo 42. Sistemas de firma para la actuación administrativa automatizada.

En el ejercicio de la competencia en la actuación administrativa automatizada, cada Administración Pública podrá determinar los supuestos de utilización de los siguientes sistemas de firma electrónica: a) Sello electrónico de Administración Pública, órgano, organismo público o entidad de derecho público, basado en certificado electrónico reconocido o cualificado que reúna los requisitos exigidos por la legislación de firma electrónica. b) Código seguro de verificación vinculado a la Administración Pública, órgano, organismo público o entidad de Derecho Público, en los términos y condiciones establecidos, permitiéndose en todo caso la comprobación de la integridad del documento mediante el acceso a la sede electrónica correspondiente(24)”

El preámbulo de la ley señala que:

““La Ley recoge, con las adaptaciones necesarias, las normas hasta ahora contenidas en la Ley 11/2007, de 22 de junio, en lo relativo al funcionamiento electrónico del sector público, y algunas de las previstas en el Real Decreto 1671/2009, de 6 de noviembre, por el que se desarrolla parcialmente la anterior. Se integran así materias que demandaban una regulación unitaria, como corresponde con un entorno en el que la utilización de los medios electrónicos ha de ser lo habitual, como la firma y sedes electrónicas, el intercambio electrónico de datos en entornos cerrados de comunicación y la actuación administrativa automatizada”

Sin embargo, como vamos a comprobar a continuación, estas regulaciones nada nos dicen del procedimiento administrativo que sea necesario para generar el algoritmo y el código fuente, ni sobre la explicación comprensible de éstos, por ejemplo.

Por otro lado, la legislación de transparencia no señala nada específico sobre la IA en el ámbito administrativo.

2.3 La necesidad de una mejora regulatoria en este ámbito.

2.3.1 El sesgo humano de confianza en la inteligencia artificial frente a los posibles límites y sesgos discriminatorios de ésta: la herencia ilustrada

Como señala la mencionada Comunicación de 2018:

“Como ocurre con cualquier tecnología transformadora, algunas aplicaciones de la IA pueden plantear nuevos problemas de carácter ético y jurídico, por ejemplo, en relación con la responsabilidad o la adopción de decisiones potencialmente sesgadas. Por consiguiente, la UE debe asegurarse de que la IA se desarrolle y aplique en un marco adecuado, que promueva la innovación y respete los valores y derechos fundamentales de la Unión, así como principios éticos tales como la obligación de rendir cuentas y la transparencia”

La confianza en la inteligencia artificial por parte de los humanos y su fascinación por la misma proviene de una larga tradición de entusiasmo humano por la ciencia, que a partir de la Ilustración surge como una nueva forma de religiosidad, con sus dogmas y santos, como han criticado incluso algunos de los propios científicos(25).

Esa admiración por la ciencia lleva desde la Ilustración a intentar extender ésta y sus métodos a las ciencias sociales, como el Derecho. García de Enterría, entre otros, ha ilustrado muy bien esa fascinación por la física newtoniana de los ilustrados y su extensión al Derecho, con referencia a Montesquieu, cuando señala, respecto a la formulación del principio de legalidad por los revolucionarios franceses del siglo XVIII, que la:

“() formulación del imperio o de la soberanía de la Ley como ideal política no es más que una transposición a la teoría social del principio de legalidad del universo sobre el que trabaja el pensamiento de occidente desde el Renacimiento y que alcanza en la Física de Newton y en la ilustración su expresión definitiva. Es bien conocido, en efecto, cómo Montesquieu abre su gran obra - que va a ser uno de los más eficaces motores del nuevo movimiento – justamente desde esta idea central, que hace unívoco el sentido de las leyes en la naturaleza y en la sociedad: “Las leyes en su significación más extensa son ls relaciones necesarias que derivan de la naturaleza de las cosas, y en este sentido todos los seres tienen sus leyes; la divinidad tiene sus leyes; las inteligencias superiores al hombre común tienen sus leyes; las bestias tienen sus leyes; el hombre tiene sus leyes”(26)

La aspiración de los revolucionarios ilustrados era conseguir una administración que fuera una máquina de aplicación automática de leyes aprobadas por el parlamento, un ser inanimado que aplicara las palabras de la ley, por utilizar por analogía la conocida metáfora de Montesquieu respecto al poder judicial(27). Forma parte del principio de legalidad esta idea, enraizada en la física newtoniana que afectó a todas las disciplinas, incluyendo al Derecho. Como señala García de Enterría en su estudio La Lengua de los Derechos:

“Por vez primera en la historia humana, todo el aparato del poder se objetiviza en un abstracto y casi mecánico (casi, porque enseguida habrá de aceptarse que la Ley puede y debe habilitar poderes llamados discrecionales en favor de las autoridades administrativas, poderes que facultan una posibilidad de elección entre soluciones igualmente justas) aparato de ejecución legal, de normas escritas y como tales ciertas, elaboradas meditadamente con la sage lenteur de las Asambleas, fijas e inmutables para los intérpretes y para los aplicadores, seguras, pues, para los ciudadanos, que por vez primera en la historia pueden conocer el Derecho a través de su publicación regular en su tenor exacto”(28)

Esta influencia mecanicista de la física newtoniana se refleja muy bien en la imagen que describe también el mismo autor de la Administración centralizada francesa - centralización heredada del Ancien Régime, por cierto, como destacó Tocqueville(29) - la cual funcionaría como “un reloj” o “un mecanismo”, del que se destaca su gran eficacia, pero del que se omite, como ha sido señalado por Prats, su sesgo en relación al papel de los ciudadanos y a la definición del interés general en el modelo francés. Se trata de un mecanismo en el que la libertad y la energía social, el capital social, por emplear una expresión moderna, tienen un papel secundario, lo que separa a esta tradición ilustrada francesa de la escocesa(30).

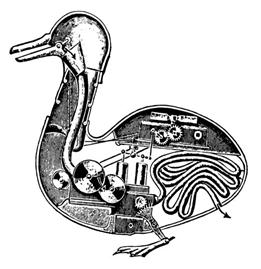

La fascinación ilustrada por un mundo mecanicista llevó al auge de los autómatas durante el siglo XVIII:

“El autómata, años antes juego, sorpresa y metáfora de la cultura manierista, se convierte ahora en trasunto de la idea que la Ilustración tiene del Hombre, al que ve como una máquina, ya no regido por los astros sino por los propios mecanismos de sus vísceras y músculos”(31).

Esa pasión por los autómatas supondría un antecedente de la admiración que para algunos despiertan las posibilidades de la inteligencia artificial hoy en día. Los autómatas de la ilustración serían algo así como los tatarabuelos de los robots actuales. Por ejemplo, Jacques de Vaucanson, creó un ‘Pato con aparato digestivo’, fabricado en metal(32). El animal mecánico era, parece ser, capaz de tragar y digerir la comida: la tomaba de la mano de su creador y desaparecía dentro de su artificial organismo para después ser excretada. Vaucanson había ideado todo un sistema de tubos que conducían el grano al supuesto estómago, donde aseguraba haber instalado una especie de laboratorio químico en miniatura para descomponer el alimento.

Figura 4 Esquema del interior del Pato con aparato digestivo de Vaucanson(33)

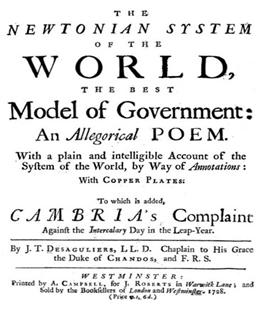

La traslación de la física newtoniana al Derecho no fue patrimonio exclusivo de Francia, pues en el ámbito del rule of law también existió la misma, dando lugar al movimiento que ha sido llamado Newtonian Government, gobierno newtoniano, menos conocido entre nosotros que la situación descrita en Francia.

En el siglo XVIII un ayudante de Newton, John Desagulier - nacido francés, hijo de hugonotes que emigró a Inglaterra con nueve años y se convirtió en asistente de Newton, en miembro de la Royal Society y en prominente masón - explicitó ese traslado interdisciplinar con un poema que loaba la aplicación de las leyes Newtonianas al gobierno

Figura 5: Portada de la obra de Desaguliers(34)

En el mismo puede leerse al principio que:

“Among my philosophical inquiries, I have considered government as a phenomenon, and looked upon that form of it to be most perfect, which did most nearly resemble the natural government of our system, according to the laws settled by the all-wife and almighty architect of the universe”.

La misma comparativa es posible detectar en el Derecho público norteamericano de la ilustración, en el que Michael Foley ha subrayado la historia de la absorción de las idees de Newton en la construcción del sistema de checks and balances norteamericano(35), a través, por ejemplo, de las ideas de James Madison, uno de los padres fundadores y participante en la redacción de la Constitución de los EEUU, cuya apasionante vida nos lleva a sus estudios en la escuela de física social de la actual Universidad de Princeton durante el siglo XVIII(36).

Esa misma fascinación de los ilustrados es posible reseguirla hoy respecto a la que muestra nuestra sociedad por los robots y la inteligencia artificial, surgiendo ya algunas voces que pronostican la posibilidad de robots con consciencia, que podrían efectuar las tareas humanas mejor y, además, sin los errores, los sesgos propios del cerebro humano(37), que nos han sido revelados ya en las últimas décadas por la psicología cognitiva(38).

Sin embargo, es preciso plantearse, en primer lugar, si la IA podrá adquirir en el futuro consciencia y característica propias humanas, y, en segundo lugar, considerar, además los problemas propios de la IA, susceptible de sus propios sesgos, como veremos más adelante.

Como recordaba el profesor Tomàs Ramón Fernández en el citado artículo de 1971 (Tomás Ramón Fernández, 1971, 331) “En primer término hay que tener en cuenta que el ordenador dice lo que previamente le han dicho quienes lo han programado (). Aun en el supuesto de que lo hagan bien (), su opinión es sólo una opinión personal que, sin embargo, a través de la información masiva y del prestigio mítico de los ordenadores en la sociedad actual, va a convertirse necesariamente en una opinión general, avalada por ese mítico prestigio social de la máquina. Sin perjuicio de volver sobre esto más: adelante, hay que convenir que la programación del ordenador y el suministro de material al mismo constituyen una especie de. codificación, realizada internamente a nivel de técnicos, sin las garantías externas de la codificación formal, pero con sus mismos inconvenientes y, sobre todo, con el mismo prestigio y fuerza social (ya que no jurídico-formal) que ésta”.

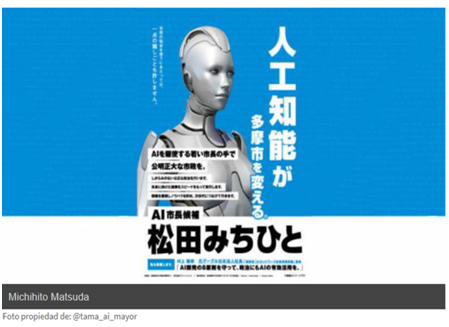

Lo cierto es que empiezan a producirse anécdotas, que podrían convertirse en categoría, en relación con una confianza taumatúrgica en la IA. Hace algún tiempo, la prensa internacional daba noticia de que un robot se presentaba a la alcaldía de un distrito de Tokio para acabar con la corrupción. El androide consiguió quedar en la tercera posición, con 4.013 votos(39)

Figura 6(40)

Sin embargo, autorizadas voces llaman también a la prudencia en el uso y control de la inteligencia artificial, para no crear algo incontrolable, como la carta abierta firmada por diversas personalidades, entre ellas Stephen Hawking, demuestra(41).

2.3.2 La inteligencia artificial en relación con los privados que ejercen funciones públicas o prestan servicios de interés general. La necesaria regulación de la autoregulación.

Ya hemos señalado que el uso de la IA que aquí nos interesa se centra en el ámbito de las AAPP. Ahora bien, creemos que las reflexiones que estamos efectuando deben ser de interés también fuera de este ámbito, en relación con aquellos privados que realizan funciones públicas o prestan servicios de interés general. Un ámbito típico es el energético(42).

Por ejemplo, a finales de octubre de 2017, un día se produjo por espacio de tres horas, desde la última hora de la tarde y hasta las 22 horas, un repunte inusual del precio de la electricidad, debido a la entrada en funcionamiento del “servicio de ajuste de reserva de potencia adicional a subir” y del modo en que éste determina el precio. El modo en que tendría que operar el algoritmo era público y estaba descrito y publicado en el BOE, en el núm. 190, de 9 de agosto de 2013, (Resolución de 1 de agosto de 2013, de la Secretaría de Estado de Energía, por la que se aprueba la modificación de los procedimientos de operación del Sistema Eléctrico Península, Anexo II: Algoritmo de asignación de ofertas para la contratación de reserva de potencia adicional a subir(43)) Pese a ello, nadie ha podido determinar las causas exactas de la muy significativa puntual elevación del precio.

Ya la Comisión Nacional de la Competencia y de los Mercados, en diciembre de 2016, en su Informe de supervisión del mercado peninsular de producción de energía eléctrica. año 2015, pág. 27, IS/DE/025/16, había advertido que:

“se siguen detectando episodios en los que ofertas más baratas que el precio que resulta finalmente casado, resultan descartadas por las limitaciones impuestas al algoritmo utilizado en este proceso”.

Pasando de la anécdota a la categoría, hay que tener en cuenta que la comunicación de la UE repetidamente mencionada de 2018 señala respecto de la autoregulación y la IA que:

“Si bien la autorregulación puede proporcionar un primer conjunto de índices de referencia con respecto a los cuales sea posible valorar las aplicaciones y resultados que van apareciendo, las autoridades públicas deben garantizar que los marcos reglamentarios para el desarrollo y el uso de las tecnologías de IA estén en consonancia con esos valores y derechos fundamentales”

2.3.3 Ejemplos de regulaciones comparadas: los casos francés y australiano

Para cerrar este apartado vamos a descender a la letra pequeña de dos ordenamientos jurídicos concretos, uno origen del modelo de Derecho administrativo denominado del règim administrative y otro vinculado a la tradición del rule of law.

Se trata de los casos de Francia y Australia.

En el caso francés, es destacable su ley n° 2016-1321 du 7 octobre 2016 pour une République numérique, que señala lo siguiente

“Art. 4: une décision individuelle prise sur le fondement d'un traitement algorithmique comporte une mention explicite en informant l'intéressé. Les règles définissant ce traitement ainsi que les principales caractéristiques de sa mise en uvre sont communiquées par l'administration à l'intéressé s'il en fait la demande

Art. 6: les administrations publient en ligne les règles définissant les principaux traitements algorithmiques utilisés dans l'accomplissement de leurs missions lorsqu'ils fondent des décisions individuelles “

Por su parte, el reglamento que la desarrolla, el Décret du 16 mars 2017 (Art. R. 311-3-1-2) establece que:

<< Art. R. 311-3-1-2.-L'administration communique à la personne faisant l'objet d'une décision individuelle prise sur le fondement d'un traitement algorithmique, à la demande de celle-ci, sous une forme intelligible et sous réserve de ne pas porter atteinte à des secrets protégés par la loi, les informations suivantes :

<< 1° Le degré et le mode de contribution du traitement algorithmique à la prise de décision ;

<< 2° Les données traitées et leurs sources ;

<< 3° Les paramètres de traitement et, le cas échéant, leur pondération, appliqués à la situation de l'intéressé ;

<< 4° Les opérations effectuées par le traitement ; >>.

En Australia, el uso de la inteligencia artificial para la toma de decisiones administrativas se está extendiendo, con habilitaciones normativas mucho más simples que las francesas. Una de las primeras se encuentra en la Social Security (Administration) Act 1999, art. 64, cuyo patrón ha sido seguido luego por muchas otras(44):

“6A Secretary may arrange for use of computer programs to make decisions

(1) The Secretary may arrange for the use, under the Secretary’s control, of computer programs for any purposes for which the Secretary may make decisions under the social security law.

(2) A decision made by the operation of a computer program under an arrangement made under subsection (1) is taken to be a decision made by the Secretary(45).”

III. SITUACIÓN ACTUAL Y POSIBLES LÍNEAS JURÍDICAS DE AVANCE EN LA MATERIA

Con lo visto hasta aquí, podemos concluir que la regulación de la actividad administrativa automatizada en España es débil, dispersa y con lagunas referidas a temas de acceso a la información, procedimiento de creación de los algoritmos y explicación de las decisiones adoptadas por éstos.

La necesaria, en nuestra opinión, mejora de la regulación española debe pasar primero, creemos, por una reflexión de fondo sobre los tipos de potestades administrativas que puedan ejercerse automatizadamente y sobre a qué clase de decisiones puede dar lugar su ejercicio.

3.1. La inteligencia artificial en relación con la toma de decisiones administrativas: apoyo a la decisión o decisión automatizada respecto a ejercicio de potestades regladas y discrecionales

El tipo de potestades administrativas en que la IA podría incidir y la clase de actos administrativos que podrían generarse es objeto de un incipiente debate entre la escasa doctrina administrativista que se ha ocupado del tema.

En primer lugar, queremos destacar la posibilidad de que la IA adopte actuaciones administrativas, formalizadas o no, tanto antes de iniciar un procedimiento administrativo (art. 55 ley 39/2015, referido a actuaciones preliminares, que es lo que en nuestra opinión realizar la ley valenciana citada), durante el procedimiento administrativo (adopción de medidas cautelares, petición o generación de informes, por ejemplo) y en la terminación del procedimiento (dictar la propia resolución definitiva). Por tanto, la IA puede generar actividad material o técnica o actos administrativos formalizados, tanto de trámite como resolutorios. Asimismo, tecnológicamente, podría producir también disposiciones generales, si bien la normativa existente calla sobre este aspecto y nosotros vamos en breve a recomendar la prohibición del uso de la IA en relación con ejercicio de potestades discrecionales, incluidas, claro está, las planificadoras o reglamentarias.

Cuestión diferente, entrando ya en el segundo aspecto anunciado, es si esas decisiones administrativas pueden ser producto indistinto del ejercicio de potestades regladas y discrecionales.

Desde luego, parece indiscutida la posibilidad de que la IA produzca decisiones automatizadas en relación con potestades regladas que impliquen, como señalan García de Enterría y Tomás Ramón Fernández que:

“la Ley puede determinar agotadoramente todas y cada una de las condiciones de ejercicio de la potestad, de modo que construya un supuesto legal completo y una potestad aplicable al mismo también definida en todos sus términos y consecuencias (por ejemplo, jubilación por edad de los funcionarios, ascenso por antigüedad, liquidación de un tributo – aplicación de una cuota establecida por la Ley a una base fijada sobre un hecho imponible determinado – etc.)”.

En estos casos, como siguen destacando estos autores “opera aquí la Administración de una manera que podría llamarse automática”. Ahora bien, como igualmente señalan estos autores, y es bien conocido:

“La existencia de potestades discrecionales es una exigencia indeclinable del gobierno humano: éste no puede ser reducido a una pura monocracia objetiva y neutral, a un simple juego automático de normas, contra lo que en su tiempo espero la entelequia social y política de la Ilustración (y como hoy, en cierto modo, alimenta la más vulgar fe en la informática y los ordenadores)”(46)

Efectivamente, como hemos visto, la traslación de los paradigmas de la física newtoniana al Derecho generó la ilusión ilustrada de que el gobierno y la administración podría suponer una aplicación automática de normas, en la que los burócratas quizás pudieran ser sustituidos en un futuro por autómatas. Ahora bien, esa fe moderna a la que se refieren esos autores cuando conecta con la IA nos lleva a una situación en que, gracias a mecanismos de aprendizaje automático y profundo y otros avances en marcha, se podría dar lugar, en teoría, a la substitución de la ponderación basada en criterios no jurídicos que pueda realizar el decisor humano. Esto es, el remplazo de la discrecionalidad humana

Pero que esa operación sea posible técnicamente, no significa que deba ser siempre deseable. Enseguida nos referiremos a los límites, que, en nuestra opinión, deben establecerse a la IA en la toma de decisiones discrecionales, no por limitaciones tecnológicas, sino de oportunidad al deberse establecer una reserva para la toma de ciertas decisiones a humanos, lo que denominaremos aquí una reserva de humanidad(47). Creemos, como vamos a razonar, que en el ámbito de decisiones discrecionales, la actividad administrativa sólo puede ser semi-automatizada, no totalmente automatizada. La IA podrá hacerse servir como apoyo, pero la ponderación final que conduzca a la decisión debería ser humana.

3.2 Límites y orientaciones en la automatización: la diligencia debida o debido cuidado derivado del derecho a una buena administración en conexión con la empatía y la phronesis humana. ¿Una reserva de humanidad?

Es en el ámbito de las potestades regladas más sencillas donde creemos, como dijimos, que la IA puede tener un papel como substituta del decisor humano. Se trata de situaciones donde la subsunción jurídica es muy simple y conduce a otorgar certificados acreditativos, por ejemplo. Un supuesto real es el contemplado en la ya citada Resolución de la Dirección General de la Agencia Estatal de Administración Tributaria, de 29 de diciembre de 2010, cuando señala entre las aplicaciones informáticas aprobadas y que se van a utilizar la referida a la obtención por los ciudadanos de certificados de encontrarse al corriente de las obligaciones tributarias (apartado primero, numero 1).

En nuestra opinión, a la que luego volveremos, aquí los algoritmos no tienen naturaleza jurídica normativa, pues se limitan a substituir al decisor humano. Como señala la legislación australiana, se puede entender que la máquina adopta la decisión por delegación del humano y éste es, a todos los efectos, a quien se imputa la decisión.

A medida que la concesión normativa de potestades supone la entrada de apreciaciones subjetivas basadas en criterios extrajurídicos (potestades regladas que exigen interpretación de conceptos, conceptos jurídicos indeterminados valorativos, discrecionalidad) se abren al decisor público una pluralidad de alternativas en el servicio al interés general, que, en nuestra opinión, disintiendo de la doctrina y jurisprudencia aún mayoritaria, no suponen una libertad de decisión, sino una obligación y responsabilidad de decidir cumpliendo las obligaciones jurídicas de buena administración conforma al estándar de diligencia debida(48).

¿Qué papel puede tener la IA, si alguno, en este caso? Si la misma puede llegar a resolver tecnológicamente de forma adecuada el ejercicio de potestades discrecionales, se abren posibilidades y problemas. Por un lado, entre las posibilidades, las asociadas a una buena administración, en su sentido de eficacia, dada la capacidad algorítmica de generar alternativas y ponderarlas, muy superior en extensión y rapidez a la humana.

Entre los problemas, sobre todo queremos llamar la atención sobre cómo el ejercicio de la discrecionalidad implica la necesidad de empatía. En ocasiones, al deber apreciarse en ocasiones conceptos jurídicos valorativos como la buena conducta, la buena fe, el ejercicio de la equidad en la revisión de oficio o la revocación, por ejemplo. En el ejercicio de discrecionalidad hay un importante papel de la empatía en esa consideración de los hechos, intereses y derechos relevantes a considerar y sopesar. El decisor público debería tener la capacidad de ponerse en la piel de los interesados, participantes y posibles afectados por la futura decisión, pues solo así podrá ponderar correctamente, para el buen ejercicio de la discrecionalidad(49).

No debe, sin embargo, confundirse esa empatía con la simpatía, prohibida por los deberes de imparcialidad y el derecho a la igualdad(50). La empatía a la que nos referimos es diferente y forma parte de una característica que parece ser específicamente humana, vinculada con la capacidad de ponerse en el lugar del otro, entrar en resonancia con los sentimientos del otro (tanto alegría como sufrimiento), no sólo de forma cognitiva sino también emocional, para dar lugar a la compasión y al altruismo(51). Esa capacidad empática, está basada en parte en las neuronas espejo, pero no únicamente, pues implica aspectos emocionales y cognitivos y a numerosas áreas del cerebro(52).

Cuando se ejerce discrecionalidad administrativa y se toman en consideración hechos, intereses y derechos de personas, esa empatía debería estar presente, y parece que sólo podría ejercerla un ser humano. Estaríamos ante un elemento de la phronesis, la sabiduría práctica o prudencia, aristotélica referida en Ética a Nicómaco, esto es al sabio ejercicio del poder, basado en una ponderación cuidadosa de las circunstancias pertinentes en cada toma de la decisión(53).

Una IA podría imitar cognitivamente la empatía (entrenamiento en gestos faciales, tono de voz, etc.) pero carece de la consciencia, emoción y humanidad precisa para no degenerar en un psicópata de sílice (54) - puesto que los psicópatas humanos carecen de empatía, pero la pueden simular, muy bien, para sus propios intereses. La existencia de empatía emocional como elemento típicamente humano, vinculado a la compasión, fue la distinción establecida por la conocida prueba o test Voight-Kampff, también llamado test de empatía, un examen científico-psicológico ficticio que aparece en la novela de ciencia ficción ¿Sueñan los androides con ovejas eléctricas? de Philip K. Dick, así como en su adaptación cinematográfica Blade Runner, cuya acción transcurre en el año 2019.

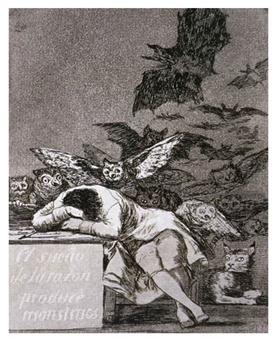

Si, por tanto, la IA no puede acabar consiguiendo disponer de máquinas con empatía emocional con los humanos, porque hace falta ser humano para ello, entonces IA y empatía emocional sería una contradictio in terminis, y el sueño, en el sentido de aspiración, de la razón total (artificial en este caso) podría llegar a producir monstruos burocráticos que no resuenen emocionalmente ni se conecten con los humanos, por utilizar el ambiguo título del genial cuadro de Goya:

Figura 7(55).

Actualmente se discute sobre la posibilidad de generar IA con consciencia similar a la humana. La discusión se enmarca en un largo debate de siglos sobre el concepto de cerebro y mente. Simplificando ahora, frente al dualismo de Descartes (el cuerpo como máquina y la mente como algo distinto), denominado críticamente por Gilbert Ryle el “dogma del fantasma en la máquina(56), una corriente potente de la ciencia materialista actual aboga por el reduccionismo biológico: la mente sólo sería un producto químico del funcionamiento del cerebro; no hay, pues, fantasma en la máquina, todo es máquina.

En consecuencia, si todo es maquinaria, no habría problema en replicar la circuitería neuronal y química de forma artificial y obtener IA con consciencia y con las características propias humanas, incluyendo la empatía. Ahora bien, frente a este planteamiento de la ciencia, esa nueva religión, como hemos visto que algunos la denominan, con sus propios dogmas también, diversos autores señalan que estamos aún lejos de poder afirmar con tal contundencia que el cerebro y la mente sean uno y que la consciencia sea un simple producto químico(57). Asimismo, el propio uso de la IA ha sido objeto de advertencias sobre sus posibles riesgos, como la conocida carta abierta firmada por científicos como Hawkins antes mencionada

En todo caso, en espera de poder avanzar, quizás, en un dilema que ha ocupado a brillantes mentes por siglos, y aplicando aquí más que las metáforas de la física newtoniana las propias de la física cuántica de nuestra época, la incertidumbre que rodea aún a la posibilidad de replicar una consciencia humana y una empatía emocional equivalente en la IA nos lleva a proponer la aplicación jurídica del principio de precaución para prevenir los graves riesgos con los que nos enfrentamos (máquinas adoptando decisiones automatizadas discrecionales que deben implicst empatía y afectan a derechos de humanos)(58). Abogamos, pues, por una regulación legal que prohíba, cuanto menos por el momento en espera de contar con más datos futuros, las decisiones totalmente automatizadas si existe discrecionalidad administrativa a ejercer, sin perjuicio de que la IA pueda emplearse dese ahora como mero apoyo en la instrucción del procedimiento antes de la decisión humana final.

Sobre la aplicación del principio de precaución fuera del ámbito ambiental, también en el social, se ha pronunciado la STS de 5 de diciembre de 2016, número de recurso 378/2013, ponente Suay Rincón, que señala que las obligaciones de debido cuidado o debida diligencia asociadas al derecho a una buena administración exigen un determinado comportamiento administrativo en el procedimiento de adopción de decisiones administrativas(59). En virtud de este principio de precaución social, seríamos partidarios de establecer, como decimos, una reserva legal de ejercicio de potestades discrecionales en favor de seres humanos, en paralelismo con el art. 9 del EBEP que exige en la actualidad que sean funcionarios lo que ejerzan las potestades administrativas, para garantizar su objetividad e imparcialidad y por tanto la buena administración. Dicha reserva, en el ámbito de la IA lo sería respecto de decisiones discrecionales exclusivamente y garantizaría algo distinto: el ejercicio humano de empatía en la diligente ponderación de hechos, derechos e intereses en que consiste la buena administración de potestades discrecionales(60).

Una limitación de este tipo debería incluirse, en nuestra opinión, en una regulación común estatal, (la ley de procedimiento común podría ser la sede adecuada). En esta línea entendemos que se inscribe, en el nivel autonómico, la ley catalana 26/2010, de 3 de agosto, de régimen jurídico y de procedimiento de las administraciones públicas de Cataluña, cuando en su art. 44.2 señala que “Sólo son susceptibles de actuación administrativa automatizada los actos que puedan adoptarse con una programación basada en criterios y parámetros objetivos”. Lo subjetivo, que no libre, es la esencia de la ponderación discrecional.

3.3. La naturaleza jurídica de los algoritmos. ¿Son los algoritmos fuente del derecho?

A la vista de todo lo expuesto, el control jurídico de la creación de algoritmos debe ir alcanzando una importancia creciente. En ese sentido, se ha dicho, parafraseando la conocida frase, que haga usted la ley y el reglamento y déjeme la aplicación informática (DE LA CUEVA, 2018). Este autor señala como:

“En la escritura del código fuente y de los algoritmos utilizados para los sistemas de gestión y de control del Estado deben exigirse los mismos requisitos que se establecen para las fuentes del Derecho y que pueden sintetizarse de la siguiente manera:

- Debe existir una regulación que establezca qué órganos tienen competencia para la escritura del código fuente y de los algoritmos, así como el procedimiento para esta labor ()

- Debe permitirse la sumisión por la ciudadanía tanto de alegaciones en lenguaje formal como en lenguaje natural ()

- El código fuente y los algoritmos deben publicarse en repositorios oficiales, donde la ciudadanía podrá leerlos y descargarlos, de la misma manera que ocurre con los boletines oficiales en línea.

- El código fuente y los algoritmos, al igual que la ley y la jurisprudencia en aplicación del artículo 13 del Texto Refundido de la Ley de Propiedad Intelectual, deben ser de dominio público

Si antes la costumbre podía ser secundum, praeter o contra legem, hoy es la aplicación informática quien puede ocupar estas tres posturas en relación con la norma jurídica. Si en aquella ocasión se resolvió el problema mediante una intervención que señaló claramente la jerarquía de las normas jurídicas, igual solución debe proponerse en la actualidad ante la aparición de estas normas secretas e indiscutibles. Los principios de legalidad y de publicidad normativa siguen vigentes y no pueden verse derogados legal o consuetudinariamente por el uso de tecnología alguna. Existen pues poderosas pero sencillas razones tanto para iusprivatistas (arts. 1.3 y 2.2 CC), como para iuspublicistas (art. 9.3 CE), para argumentar en favor de esta regulación del código fuente y de los algoritmos. Se trata de algo tan elemental como seguir reivindicando el imperio de la ley.”

Coincidimos totalmente con la necesidad de ofrecer transparencia sobre la elaboración de los algoritmos y permitir la participación ciudadana en su diseño. Pero no creemos que todo algoritmo sea siempre fuente del derecho. En el caso de ejercicio de potestades administrativas, se puede decir que se delega en la IA tal ejercicio y el autómata toma el sitio del humano en función de las instrucciones que ha recibido.

La fuente de Derecho, en nuestra opinión, sigue siendo la norma jurídica que es ejecutada mediante el algoritmo y el código fuente(61). Ahora bien, que ambos no sean fuentes del Derecho no supone que no requieran de un procedimiento debido administrativo para su adopción, del que se carece hasta el momento, de una motivación comprensible, cuya exigencia no existe, y de una transparencia adecuada, que incluya la posibilidad de participación ciudadana en su elaboración, su publicación y el derecho de acceso.

Enseguida volveremos sobre este punto.

3.4. El Estado de Derecho y la inteligencia artificial.

3.4.1 Algoritmos, derechos de los ciudadanos y cajas negras (black boxes) y muñecas rusas: abriendo las cajas negras

La citada Comunicación de 2018 destaca la necesidad de:

“Garantizar el establecimiento de un marco ético y jurídico apropiado, basado en los valores de la Unión y en consonancia con la Carta de los Derechos Fundamentales de la UE”

En la situación actual, la opacidad que rodea a los algoritmos viene determinada por una pluralidad de factores, que generan diversas cajas negras, que, a modo de muñecas rusas, se van superponiendo y haciendo opacos los programas informáticos en que se basa la IA.

Así, las Administraciones Públicas no acostumbran a formalizar ni publicitar la decisión de utilizar algoritmos y éstos; aun cuando se publicite el algoritmo, la complejidad del mismo y su funcionamiento en el caso de los de aprendizaje automático y profundo dificultan conocer cómo funcionan (a ello hace alusión en puridad la expresión caja negra, como ya sabemos); hay que contar además con el interés de los diseñadores de proteger secretos empresariales para mantener una ventaja competitiva respecto a sus competidores, protegido por la limitación del derecho de acceso cuando pueda suponer un perjuicio a “ el secreto profesional y la propiedad intelectual e industrial” (art. 14.1 j ley 19/2013) (62); debe tenerse en cuenta la voluntad de las administraciones públicas de evitar que el conocimiento por parte de los destinatarios de las decisiones tomadas a través de algoritmos les permita eludir su aplicación; y también considerar la voluntad de las administraciones públicas de garantizar la confidencialidad o el secreto del proceso de toma de decisión.

Para terminar con la opacidad y abrir estas diversas cajas negras, es preciso encontrar el modo de hacer cumplir las obligaciones jurídicas que se derivan del derecho a una buena administración de los ciudadanos, también, claro está, en el ámbito de la IA y del resto de derechos. Obligaciones que en el caso de la buena administración incluyen, y rebasan, las propias de la transparencia. Como señala la la STS de 30 de abril de 2012 (Recurso Núm. 1869/2011), aceptando los fundamentos jurídicos de la sentencia de instancia, respaldada por el TS que rechaza el recurso de casación, el derecho a una buena administración, “derecho de última generación”, es integrado por el acceso de los ciudadanos a archivos y registros, vinculado a principios de transparencia(63).

Las diversas medidas que deberían desplegarse en garantía del derecho a una buena administración de los ciudadanos, del resto de derechos y para permitir el control de la actividad automatizada (o, en terminología menos tradicional en nuestra lenguaje jurídico tradicional, su rendición de cuentas) incluirían; la construcción de un procedimiento debido administrativo para la aprobación de los algoritmos; la reafirmación de un derecho a una explicación comprensible del funcionamiento de los algoritmos basado en el derecho a comprender; el uso de programario abierto; la publicidad activa y el derecho de acceso a los algoritmos; la prevención y el control de los sesgos de los algoritmos y la evaluación de impacto de protección de datos de los mismos.

1. Procedimiento administrativo debido

La Ley 30/1992, de 26 de noviembre, de régimen jurídico de las administraciones públicas y del procedimiento administrativo común preveía que “los programas y aplicaciones electrónicos, informáticos y telemáticos que vayan a ser utilizados por las Administraciones Públicas para el ejercicio de sus potestades, habrán de ser previamente aprobados por el órgano competente, quien deberá difundir públicamente sus características” (art. 45). Asimismo, la LGT señala en su art. 96, como hemos dicho ya, que “los programas y aplicaciones electrónicos, informáticos y telemáticos que vayan a ser utilizados por la Administración tributaria para el ejercicio de sus potestades habrán de ser previamente aprobados por ésta en la forma que se determine reglamentariamente”

Las regulaciones posteriores, ya aludidas, no han desarrollado convenientemente los aspectos procedimentales de la aprobación de algoritmos y códigos fuente, cuestión que sería importante recuperar y conectar con la existencia de un procedimiento administrativo debido que permita, antes de la misma, la participación ciudadana mediante un trámite de información pública y de audiencia, en su caso.

Este momento procedimental ha de permitir a los ciudadanos alegar “para corrección de errores (bugs) y la propuesta de características (features) de la aplicación o del algoritmo” (De La Cueva, 2018). Asimismo, esas alegaciones deben ser respondidas de forma fundada, dado que como señala el art. 83.3 de la ley 39/2015 “quienes presenten alegaciones u observaciones en este trámite tienen derecho a obtener de la Administración una respuesta razonada, que podrá ser común para todas aquellas alegaciones que planteen cuestiones sustancialmente iguales”. La ausencia de tal respuesta, supone una violación de la debida diligencia o debido cuidado exigido por el derecho a una buena administración, que debería lleva a la ilegalidad de la aprobación de los algoritmos ( en relación a este tema, véase por ejemplo la STS de 29 de octubre de 2010, RJ 2011\1067, anulándose en este caso un acuerdo de Consejo de Ministros sobre distribución de derechos de emisión de gases de efecto invernadero por falta de respuesta a alegaciones de los demandantes durante el procedimiento administrativo)(64).

Este sería uno de los casos en que las características del procedimiento exigirían la información pública (art. 83.1 Ley 39/2015, cuando señala que “El órgano al que corresponda la resolución del procedimiento, cuando la naturaleza de éste lo requiera, podrá acordar un período de información pública”: evidentemente el desafortunado podrá debe entenderse como que deberá, dado que la naturaleza del procedimiento de aprobación de algoritmos y códigos fuente lo requiere).

Además, si la elaboración de los algoritmos y códigos fuente va a afectar a derechos y/o intereses identificables por la Administración, deberá abrir, además, el trámite preceptivo de audiencia, como es obvio (art. 82 Ley 39/2015).

Todo ello debería estarse haciendo ya, a pesar de que no existan aún procedimientos administrativos formalizados sectoriales de aprobación de los programas informáticos administrativos, en lo que sepamos. Y ello por simple aplicación del procedimiento administrativo común a la actividad administrativa automatizada. De lege ferenda, entendemos muy conveniente la formalización sectorial de dichos procedimientos adaptados a las necesidades específicas, pero sin obviar estos principios y reglas comunes de obligado cumplimiento. De igual modo, sería interesante, en nuestra opinión, que bien la ley de procedimiento administrativo común estatal o bien la legislación de Administración electrónica formalizase estableciese algunas reglas y principios esenciales, en la línea de los expuestos, como recordatorio a los instructores del procedimiento administrativo de sus obligaciones de buena administración.

Si los algoritmos y códigos fuentes fueran elaborados por contratistas de la Administración, creemos que debería entenderse que los mismos estarían ejerciendo, en definitiva, una función pública al aprobar un programa informático de aplicación normativa, ejercicio de función pública por privados a la que convendría extender dichos principios y reglas del procedimiento administrativo debido también por ley, con oportuna modificación del ámbito de aplicación de la ley 39/2015 actual, como entidades colaboradoras informáticas de la Administración, como hemos tenido ocasión de exponer, con carácter general, en otro momento con más detalle(65).

La traslación de la normativa que concede la potestad reglada a lenguaje informático (vid. introducción) es un paso crucial y no exento de dificultad, que debe ser objeto de escrutinio público y de los interesados. Un error (sea por negligencia o dolo) en esta fase puede suponer, y ha supuesto ya en la práctica, la réplica del mismo por cientos, miles de decisiones(66).

En virtud del derecho a una buena administración, este procedimiento administrativo desarrollado con la debida diligencia o debido cuidada debe guardar una congruencia relacional con la decisión que finalmente se adopte y la motivación de la misma.

2. Derecho a una explicación comprensible

Entendemos que la diligencia debida (o debido cuidado) ligada al derecho a una buena administración incluye también la obligación de los gobiernos y las administraciones de actuar diligentemente para hacerse comprender y el correlativo derecho del ciudadano a comprender la información que le transmite la Administración de cualquier modo (mediante notificaciones o publicaciones) y mediante cualquier soporte (páginas web, plafones informativos, cartas), incluyendo, claro está, a los algoritmos y códigos fuente utilizados, en su caso, para la adopción de decisiones.

La Resolución del Parlamento Europeo, de 16 de febrero de 2017, con recomendaciones destinadas a la Comisión sobre normas de Derecho civil sobre robótica (2015/2103(INL)), que citaremos en adelante como la Resolución de 2017, expone que el principio de transparencia:

“consiste en que siempre ha de ser posible justificar cualquier decisión que se haya adoptado con ayuda de la inteligencia artificial y que pueda tener un impacto significativo sobre la vida de una o varias personas; considera que siempre debe ser posible reducir los cálculos del sistema de inteligencia artificial a una forma comprensible para los humanos”

Este derecho a comprender estaría relacionado, por supuesto, con el derecho a utilizar las lenguas oficiales en sus relaciones con la Administración, regulado ya por nuestro ordenamiento, como es sabido y sobre el cual ahora no podemos detenernos. Pero, y esto es lo que nos interesa, va más allá. Incluye también la comprensibilidad de la información transmitida por la Administración, sea en la lengua cooficial que se emplee, de acuerdo con el ordenamiento jurídico. Algo que sólo tímidamente se ha reconocido jurídicamente en algunas normas(67).

Pues bien, en nuestra opinión, se explicite o no en una ley como las mencionadas, la obligación de diligencia de los gobierno y administraciones de hacerse comprender forma parte intrínseca de los principios de buen gobierno y del derecho a una buena administración, ya mencionados. Por tanto, es una obligación genérica y transversal, en cualquier sector y respecto de cualquier información transmitida, ligada al estándar de conducta de debida diligencia aquí propuesto y vinculada, desde un aspecto negativo, con la prohibición de interdicción de la arbitrariedad constitucional (art. 9.3 CE) y, en positivo, con la obligación de motivación de las decisiones administrativas (art. 35.1 Ley 39/2015).

Ese derecho a comprender tendría trascendencia respecto al uso de algoritmos y Big Data, puesto que la explicación que ofrezca la Administración del funcionamiento del sistema debe ser comprensible para el ciudadano(68). Ya hemos visto como diversos preceptos del Reglamento General de Protección de Datos de la UE (Artículo 13 Información que deberá facilitarse cuando los datos personales se obtengan del interesado, Artículo 14 Información que deberá facilitarse cuando los datos personales no se hayan obtenido del interesado Artículo 15 Derecho de acceso del interesado) se refieren a que cuando existan decisiones automatizadas deberá proporcionarse “información significativa sobre la lógica aplicada, así como la importancia y las consecuencias previstas de dicho tratamiento para el interesado”.

Caso de vulnerarse el estándar de debida diligencia en la comprensibilidad, cosa que habrá que presumirse si el texto no es inteligible para el hombre y mujer que a su vez despliegue una diligencia razonable en la comprensión (la de un buen padre de familia, art. 1104 Cc, no profesional, o en el caso empresarial, la de un “ordenado empresario” prevista en la legislación de sociedades, profesional y más exigente), cabría alegar la imposibilidad de cumplir lo exigido (lo que haría la decisión administrativa imposible y/o irracional, art. 47 ley 39/2015 para actos, art. 9.3 Constitución española en general) y solicitar la anulación judicial de la decisión adoptada, así como, en su caso, responsabilidad patrimonial por los daños que la actividad incomprensible de la Administración hayan causado en el destinario.

3. Las administraciones deben utilizar programario abierto o declararlo de fuentes abiertas.

La LRJSP dispone que las administraciones pondrán declarar como de fuentes abiertas las aplicaciones, desarrolladas por sus servicios o que hayan sido objeto de contratación y de cuyos derechos de propiedad intelectual sean titulares, cuando de ello se derive una mayor transparencia en el funcionamiento de la Administración Pública (artículo 157.2 LRJSP).

4. Publicidad activa y derecho de acceso a los algoritmos y códigos fuente:

Ya hemos visto como en el Derecho francés el Decreto de 16 de marzo de 2017, que desarrolla la LOI n° 2016-1321 du 7 octobre 2016 pour une République numérique, es más concreto aún, al exigir, una comunicación inteligible a quien lo requiera de “1° Le degré et le mode de contribution du traitement algorithmique à la prise de décision ; << 2° Les données traitées et leurs sources ; << 3° Les paramètres de traitement et, le cas échéant, leur pondération, appliqués à la situation de l'intéressé ; << 4° Les opérations effectuées par le traitement). >>

Pero ya antes de ello, en 2015, la Comisión francesa d’accès aux documents administratifs obligó a la Direction générale des finances publiques a hacer público el código fuente del programa de ordenador usado para calcular o el impuesto sobre los ingresos de las personas físicas y en 2018 a hacer accesible los códigos fuente de tres programas que desarrollan modelos con datos económicos usados por el Ministerio de Economía(69). También recientemente, la decisión del Tribunal Administrativo Regional de Lazio-Roma declara que un algoritmo, que servía para la toma de decisiones automatizadas sobre movilidad de docentes por la Administración pública italiana, es un acto administrativo digital y, por tanto, bajo la legislación de acceso a la información, los ciudadanos tienen el derecho a su acceso(70).

En España, ya hicimos referencia en la introducción a diversas decisiones de la GAIP catalana que han concedido derecho de acceso al algoritmo. Como señala la Resolución 200/2017, de 21 de junio (la traducción es nuestra):